基于APScheduler的定时爬虫任务工具

在数据采集领域,定时爬虫的可靠性与灵活性直接影响业务效率。针对需要周期性执行网络请求、数据解析的场景,APScheduler作为轻量级任务调度框架,成为许多开发者的首选工具。本文从实际应用角度,解析如何利用APScheduler构建稳定的定时爬虫系统。

为什么选择APScheduler?

与操作系统级的Cron工具相比,APScheduler提供更贴近代码层的控制能力。其核心优势在于:

1. 跨平台支持:无需依赖系统环境,适用于Windows/Linux服务器及容器化部署;

2. 灵活的任务配置:支持日期触发、间隔触发、Cron表达式三种模式,满足分钟级到月级的调度需求;

3. 高可靠性:内置任务持久化机制(如SQLAlchemy集成),避免服务重启导致任务丢失。

例如,针对电商价格监控场景,Cron表达式`0 8,14,20 `可实现每日早中晚三次定点抓取,而间隔触发器(Interval)更适合实时性要求高的舆情监测(如每10分钟采集一次)。

集成爬虫与APScheduler

以新闻网站正文采集为例,典型实现流程如下:

1. 初始化调度器:根据项目复杂度选择BlockingScheduler(单线程阻塞模式)或BackgroundScheduler(后台非阻塞模式);

2. 封装爬虫函数:通过`@scheduler.scheduled_job`装饰器或`add_job`方法绑定任务;

3. 配置执行策略:设置时区、任务异常重试、日志记录等参数。

```python

from apscheduler.schedulers.blocking import BlockingScheduler

def news_crawler:

爬虫核心逻辑:请求+解析+存储

print("执行数据抓取...")

if __name__ == '__main__':

scheduler = BlockingScheduler

scheduler.add_job(news_crawler, 'interval', hours=1) 每小时执行一次

try:

scheduler.start

except KeyboardInterrupt:

scheduler.shutdown

```

生产环境中的实战技巧

案例1:分布式环境下的任务竞争

当爬虫部署在多台服务器时,需避免重复执行。可通过数据库锁或Redis分布式锁实现任务独占。例如,在添加任务时检查任务ID是否已存在:

```python

from apscheduler.jobstores.sqlalchemy import SQLAlchemyJobStore

jobstores = {'default': SQLAlchemyJobStore(url='sqlite:///jobs.db')}

scheduler = BlockingScheduler(jobstores=jobstores)

```

案例2:异常处理与重试机制

网络波动可能导致爬虫任务失败,通过`max_instances`和`misfire_grace_time`参数控制任务并发与超时:

```python

scheduler.add_job(news_crawler,

'cron',

day_of_week='mon-fri',

hour=9,

max_instances=1,

misfire_grace_time=600,

coalesce=True)

```

此配置下,若周一到周五9点任务未执行,允许10分钟内补跑,且合并多次触发为单次执行。

避坑指南

1. 资源泄露问题:长期运行的调度器需显式关闭数据库连接或HTTP会话,避免内存溢出;

2. 时区一致性:所有任务必须明确时区参数(如`timezone='Asia/Shanghai'`),防止跨时区服务器触发时间混乱;

3. 日志分级:通过`apscheduler.events`模块监听任务执行事件,区分DEBUG与ERROR级别日志。

关键设计原则

避免在任务函数内进行阻塞操作(如无限循环),必要时拆分为独立子进程

相关软件推荐

局域网聊天室(多线程Socket)

发布日期: 2025-03-30 11:12:16

基于TCP/IP协议的Socket通信技术为局域网即时通讯提供了底层支持。在Windows或Linux环境下...

随机软件推荐

小说阅读进度跟踪记录器

纸质书时代,书签是读者最忠实的伙伴。而在数字阅读占据主流的今天,一款智能化的进度跟踪工具正在重塑阅读者...

桌面便签工具(可调节颜色和透明度)

窗外的阳光斜照在显示屏边缘,办公桌面的待办事项列表突然变得刺眼。伸手将荧光黄的便签透明度降低30%,整个工...

带进度条的文件内容搜索工具

办公室的日光灯管嗡嗡作响,李明盯着屏幕上闪烁的光标,第27次按下Ctrl+F组合键。这个15GB的日志文件像座沉默的大...

网站Cookie使用情况分析工具

互联网的隐私合规门槛逐年升高,从欧盟的《通用数据保护条例》(GDPR)到国内《个人信息保护法》,网站运营者面...

系统托盘图标动态资源指示器

当电脑屏幕右下角的图标群开始闪烁时,多数人只会机械性地点击关闭弹窗。但在这个不足20像素的微型战场里,动态...

基于邮件的内容爬虫(自动解析特定内容)

互联网时代每天产生约3000亿封电子邮件,其中蕴含大量商业情报与用户行为数据。针对邮件内容自动化采集需求,某...

图片格式批量转换器(使用Pillow库开发)

办公桌上堆积着数百张不同格式的图片文件,设计师小王对着显示器揉着太阳穴。这种场景在现代数字办公中屡见不...

CSV文件大小智能分割工具(按行-体积)

在数据密集型行业中,CSV文件因其通用性成为数据交换的标配格式。随着数据量膨胀,动辄数GB的单一文件常导致传输...

定时自动备份目录树工具(计划任务集成)

凌晨三点,服务器监控系统突然发出刺耳的警报声。某互联网公司的运维工程师小王从睡梦中惊醒,发现核心业务数...

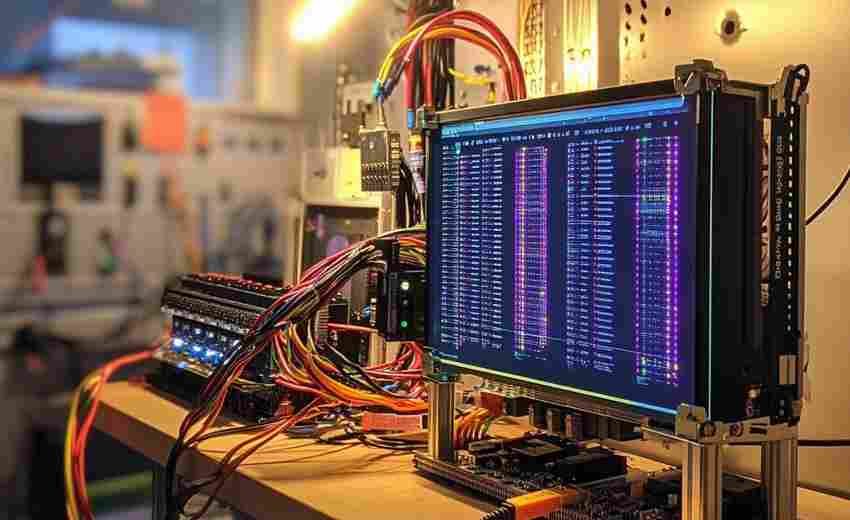

设备状态实时监控数据可视化平台

某汽车零部件工厂的中央控制室内,液晶大屏上跳动着数百台设备的运行曲线,当某台冲压机的振动幅度突然突破红...

图像格式转换GPU加速实验版

在数字图像处理领域,格式转换工具如同空气般存在于每个设计师的日常工作流中。当主流工具仍在依赖CPU进行常规...

Bokeh交互式网页可视化工具

当鼠标滑过纽约证券交易所的实时行情走势图,悬浮的K线精确显示着毫秒级交易数据;当指尖轻触屏幕上的全球气候...

公里-小时与米-秒速度单位转换器

在日常生活和科学研究中,速度单位的转换需求无处不在。无论是汽车仪表盘上的公里每小时(km/h),还是物理实验...

番茄钟时间管理应用(带统计报表功能)

办公室的咖啡机旁总有人抱怨"忙了一天却像什么都没干",直到行政部的陈姐开始用番茄钟应用记录时间流向。三个月...

桌面便签贴纸工具(透明窗体)

启动软件后桌面会浮现半透明色块,如同在显示器表面覆盖了真实的便利贴。这款仅12MB的桌面便签工具支持Windows全系...

图书评论情感分析统计工具

在数字化阅读时代,海量图书评论数据背后隐藏着巨大的市场洞察力。一款新型的图书评论情感分析统计工具应运而...

旅游景点用户评分与门票价格爬虫

互联网时代,旅游景点信息呈现爆发式增长,但有效数据的筛选与整合始终是行业痛点。一款专注于抓取用户评分与...

基于PyQtGraph的数据可视化仪表盘

在工业控制与数据分析领域,实时监测系统对可视化工具的性能要求日益严苛。基于PyQtGraph开发的动态仪表盘解决方...

屏幕录制工具(指定区域录制为GIF)

办公桌前的程序员正对着一段报错代码抓耳挠腮,网课老师反复拖动着几何画板的动态演示,电商设计师在商品详情...

桌面便签贴纸程序(支持颜色和字体自定义)

电脑桌面上散落着五颜六色的电子便签,这个场景在远程办公时代愈发常见。面对市面上十余款同类工具,ColorNotes凭...

自动桌面壁纸更换工具(定时-随机)

清晨八点按下开机键,小王盯着屏幕上用了半年的默认壁纸叹了口气。行政岗同事的电脑桌面是上周旅游拍的雪山,...

视频帧提取工具(按时间间隔保存关键帧)

在数字内容爆炸式增长的今天,视频工作者常面临素材整理的痛点。某科技团队近期推出的视频帧提取工具,凭借其...

简易贪吃蛇游戏(得分统计+难度调节)

一款功能丰富的贪吃蛇游戏工具近期在开发者社区引发关注。这款基于Python开发的开源项目不仅复刻了经典玩法,更...

自动压缩指定文件夹工具(ZIP)

日常办公场景中常遇到这种情况:项目文档散落在二十多个子文件夹,市场部每周需要打包上百份设计稿,开发团队...

自动重命名规则化文件工具(日期-序号前缀)

在数字化办公场景中,文件命名混乱常成为效率瓶颈。某企业市场部曾因「客户方案V12_终版_FINAL(1).docx」这类命名...

批量重命名图片文件工具(含EXIF读取)

数码时代的海量照片管理难题困扰着无数摄影爱好者。面对数千张以"DSC0001.jpg"命名的图片文件,专业摄影师小林曾花...

简易画图板(保存为位图文件)

当灵感突然涌现时,快速捕捉创意往往比复杂的创作流程更重要。一款名为QuickSketch的绘图工具近期在设计圈引发关注...

教学答题步骤回放器

许多人在面对复杂题目时,明明听懂了讲解,自己动手时却频频卡壳。这种现象背后往往隐藏着关键问题:解题过程...

自动备份指定目录的压缩归档工具

数字时代,数据丢失如同办公室突然断电般令人措手不及。某互联网公司运维团队曾因服务器故障导致三个月的项目...

简易在线绘图工具(SVG基础操作)

鼠标拖拽出矩形框,右侧属性栏随手输入"FFA500"色值,橙色的圆角方形瞬间跃上画布。这类直观操作正成为在线SVG绘图...

文本翻译工具(调用翻译API)

在全球化进程加速的今天,语言差异仍是许多人面临的现实难题。无论是跨国商务合作、学术研究还是个人旅行,快...

批量添加MP3标签编辑器(ID3修改)

音乐文件管理常因ID3标签混乱陷入困境。手动逐条修改专辑名、歌手、封面信息不仅耗时,更易导致标签信息残缺或...

带定时触发功能的网页数据自动采集监控程序

现代企业对于网络数据的依赖程度日益加深,如何高效获取并监控目标网页数据成为重要课题。市面上最近出现的一...

简易屏幕录像机程序

电脑桌面上突然弹出的错误提示总在关键时刻消失?游戏通关的高光时刻总想分享给队友?市面多数录屏软件安装包...

中文乱码文件批量修复工具(GB18030支持)

电子文档的编码问题常困扰着计算机使用者,尤其当遇到GBK、GB2312与GB18030编码体系混杂时,文件名与文件内容的双重...

简易密码保险箱应用

在数字化生活全面渗透的当下,个人隐私保护已成为刚需。某团队近期推出的「密匣」应用,凭借极简设计与硬核防...

文件粉碎机(彻底删除不可恢复)

硬盘数据恢复技术早已突破普通用户的想象。2021年某国际数据实验室的实验表明,即便经过普通格式化的硬盘,仍有...

系统USB设备插拔事件记录器

在数据安全事件调查中,超过37%的泄密行为与未经授权的USB设备使用直接相关。传统审计手段往往难以精准追溯外接...

电脑USB设备使用记录查看器

在某个凌晨三点,某科技公司的安防系统突然触发警报。IT主管通过一串设备接入记录锁定了某员工工位上的陌生U盘...

终端版短链接生成与还原器

互联网时代,短链接技术早已渗透到日常信息交互中。无论是社交媒体分享还是营销推广,长URL的臃肿问题始终困扰...