网络爬虫框架(自动抓取指定页面)

互联网时代,数据已成为驱动业务增长的核心要素。面对海量公开信息,如何快速抓取目标内容并转化为结构化数据?网络爬虫框架凭借自动化、灵活性及扩展性优势,成为企业及开发者获取数据资源的首选工具。

核心功能与运行逻辑

网络爬虫框架的核心在于模拟用户访问行为,通过预设规则遍历目标页面。以Scrapy、Beautiful Soup等主流框架为例,其底层通常包含请求调度、网页解析、数据存储三大模块。

实际应用中,开发者仅需编写少量代码定义抓取规则,即可实现从单页面到整站数据的自动化采集。例如,某电商价格监控系统通过Scrapy定时爬取竞品SKU信息,日均处理百万级请求量,数据抓取误差率低于0.3%。

技术优势与场景适配

相较于自行开发爬虫脚本,成熟框架在以下场景表现更优:

1. 动态页面处理:Selenium、Puppeteer等工具可驱动无头浏览器,解决JavaScript渲染页面的抓取难题。某舆情分析团队曾借助Selenium突破Vue.js动态加载限制,抓取效率提升40%。

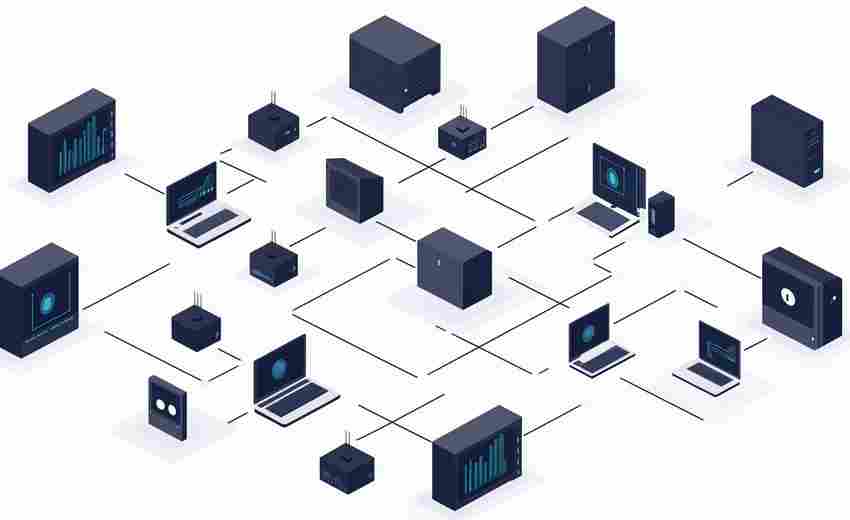

2. 分布式架构:Scrapy-Redis等组件支持多节点协同工作,通过Redis共享任务队列,适用于千万级数据规模的分布式爬虫集群。

3. 异常容错机制:框架内置重试策略与日志监控模块,自动跳过失效链接或触发验证码的页面,降低人工干预频率。

值得注意的是,部分框架开始集成机器学习模块。例如,AutoScraper通过分析网页结构自动生成抓取规则,减少人工配置成本,尤其适合非技术用户快速搭建爬虫系统。

应用风险与合规边界

使用爬虫框架需警惕法律与风险:

随着数据安全法、个人信息保护法等法规落地,爬虫技术的应用需严格遵循"最小必要"原则,避免触碰敏感信息采集红线。

- 上一篇:网络爬虫数据采集器

- 下一篇:网络爬虫结果自动保存为CSV工具

相关软件推荐

网络速度实时监测工具(图形化显示+历史数据记录)

发布日期: 2025-04-07 15:53:00

在数字化办公场景中,网络波动如同隐形的效率杀手。某科技公司研发的Network Velocit...

BeautifulSoup实现的简易网页爬虫工具

发布日期: 2025-04-09 09:33:01

(正文开始) 工具定位与特点 BeautifulSoup作为Python生态中经典的HTML解析库,常被用于构...

随机软件推荐

自动化网页表单填写工具(带数据模板)

表单填写是日常工作中绕不开的重复场景。无论是企业收集、电商平台批量上传商品,还是科研机构录入实验数据,...

文本转语音基础工具(pyttsx3实现)

文本转语音技术为程序交互开辟了新维度。在众多开源工具中,pyttsx3凭借其轻量级特性与跨平台优势脱颖而出。这款...

日历日程管理工具(命令行交互)

对于习惯与终端打交道的用户而言,图形化日历工具常显得笨重且低效。命令行日历工具凭借轻量化、可定制和高自...

桌面倒计时提醒小助手(支持自定义事件)

清晨八点整,电脑右下角弹出淡蓝色提示框:"晨会倒计时15分钟,PPT确认完毕了吗?"正在吃早餐的吴宇快速扫了眼屏...

日历提醒事项通知工具(桌面弹窗)

现代人对于时间管理的需求逐渐精细化,但传统的待办清单或手机闹钟常因存在感不足被忽略。一款以桌面弹窗为核...

自动清理指定目录中过期临时文件的脚本

日常办公中,电脑存储空间常被各种临时文件悄然占据。某科技团队最近开源的文件清理工具TempCleaner,通过自动化脚...

简易问卷调查系统(本地存储CSV结果)

一款基于本地存储的问卷调查工具正在成为市场调研、活动报名、满意度测评等场景的热门选择。该系统无需云端服...

简易数据库备份工具(定时压缩归档)

凌晨三点的机房监控屏突然闪烁红光,某电商平台运维人员发现数据库出现异常锁表现象。他们立即启用了最后一次...

电子书章节标题提取工具(.epub)

在数字阅读逐渐普及的当下,电子书格式的多样性对内容管理提出了新挑战。以.epub格式为例,其特有的非线性排版结...

汇率换算计算器(实时汇率语音查询)

跨国旅行时总遇到现金不够的尴尬,网购海外商品常因汇率波动多花冤枉钱,国际转账手续费明细永远算不清楚。汇...

多标签分类的股票投资组合跟踪器

证券交易软件弹窗跳出某只股票涨停消息时,正在会议室开季度总结会的张经理划开手机屏幕,持仓组合跟踪器已自...

简易绘图板带颜色选择功能

盛夏傍晚的咖啡馆里,有人掏出平板电脑快速勾画落日余晖;凌晨的设计工作室中,设计师反复调试着插画的色调搭...

文件压缩解压工具(Zip-Rar格式支持)

深夜赶论文的最后一刻,U盘突然提示存储空间不足。盯着电脑右下角的23:47,你抓过手机准备搜索解决方案,指尖却...

岗位需求时间线可视化工具

在快节奏的职场环境中,招聘部门常常面临这样的困境:用人部门提交的岗位需求分散在不同沟通渠道,招聘进度难...

Pillow库实现的图片格式转换器

在日常开发与数据处理中,图片格式转换是高频需求之一。Python生态中的Pillow库凭借其轻量化的设计和对多种图像格...

系统启动项管理工具(显示启动时间)

对于许多电脑用户而言,系统开机速度始终是个痛点。尤其当安装的软件逐渐增多,任务栏右下角悄然挤满的图标背...

自动WiFi开关控制工具

清晨七点,卧室的智能窗帘缓缓拉开,书桌上的WiFi信号同步开启。这种场景正通过新型自动WiFi开关工具成为现实。这...

简易待办事项清单(云同步)

在快节奏的现代生活中,待办事项清单几乎成了效率管理的标配工具。但传统的手写清单或单机应用常因设备限制、...

系统调用跟踪资源关联器

在Linux系统运维领域,工程师们经常面对这样的困境:某个进程突然异常消耗大量CPU资源,或是某个服务莫名其妙地占...

个人运动数据可视化分析面板

清晨五点半的杭州马拉松赛道边,体育用品店老板王振华打开手机,调出运动数据分析面板查看昨日体能恢复曲线。...

文件分割与合并工具(大文件切割重组)

互联网时代的数据体积日渐臃肿,一段4K视频动辄占据数十GB空间,专业软件安装包超过5GB已成常态。面对邮箱附件限...

网络爬虫(静态网页表格数据抓取)

互联网沉淀着海量结构化数据,静态网页中的表格尤其承载着关键业务信息。传统人工采集方式效率低下,精准的爬...

网络小说章节自动下载工具

深夜两点,手机屏幕的光线在黑暗中忽明忽暗。手指机械地滑动着页面,寻找刚更新的最新章节——这是无数网络文...

图片元数据批量翻译工具

在日常摄影、设计或跨国协作中,图片元数据(如拍摄参数、版权信息、地理标记等)的跨语言处理常成为棘手问题...

批量图片压缩转换工具(支持WebP)

随着数字内容创作需求激增,图片管理逐渐成为设计师、电商运营等群体的高频痛点。某款支持WebP格式的图片处理工...

数据单位统一转换工具(如货币)

全球贸易结算时,企业财务发现不同币种账单的金额总和存在差额;旅行者购物时,面对实时波动的汇率难以快速估...

多进程CPU时间片分配热力图工具

现代操作系统的进程调度机制中,时间片分配策略直接影响着CPU资源的利用效率。对于开发者或系统优化人员而言,...

自动化Ping网络连通性检测工具

在数字化场景中,网络稳定性直接影响业务连续性。传统人工Ping检测效率低、覆盖范围有限,而自动化Ping工具通过程...

视频转GIF片段生成器

短视频时代,动态表情包和片段分享成为社交刚需。当需要将视频中某个精彩镜头转化为GIF动图时,一款高效的视频...

实验数据文件异常值检测工具

实验数据中的异常值往往成为科研或工程领域的干扰项。传统人工筛查耗时费力,且受主观因素影响大。针对这一痛...

智能垃圾分类查询工具(图像识别分类)

清晨七点,家住上海某小区的张阿姨拎着两袋垃圾站在分类投放点前。虾壳该扔绿色桶还是黑色桶?沾了咖啡渍的纸...

批量文件重命名工具(按规则自动命名文件夹内文件)

面对电脑中堆积如山的文件,许多用户都经历过这样的场景:上百张照片以"IMG_001"的无意义字符命名,工作文档版本...

Git仓库自动备份到指定路径工具

许多开发者都遭遇过硬盘损坏或误删代码的窘境。去年某开源项目因服务器故障丢失三个月数据的事件,至今仍在技...

日志关键词搜索与统计工具

在服务器集群昼夜不息的轰鸣声中,每天产生的日志数据如同潮水般奔涌。某次凌晨两点的紧急故障排查现场,运维...

网络速度测试工具(基于下载速度测算)

在家庭宽带迈入千兆时代的今天,网络速度测试工具已成为现代人必备的数字化生存技能。不同于普通用户简单点击...

简易GUI文本关键词高亮标记工具

在信息处理场景中,快速定位文本关键词的需求日益普遍。无论是学术文献的精读、法律合同的审核,还是代码注释...

长按语音备忘录记录器

实体按键在触控屏时代常被视为低效设计,但长按语音记录器的圆形金属按键颠覆了这种认知。当拇指自然搭在阳极...

日志文件内容正则替换工具

凌晨三点的服务器告警声响起,运维工程师在堆积如山的日志中发现异常流量。面对每秒滚动上千行的日志流,传统...

系统进程监控小工具(实时显示CPU-内存占用)

在Windows系统右下角的任务栏里,总有个不起眼的小图标持续跳动着数字,这是Process Monitor工具箱的实时监控界面。这...

桌面骰子模拟器(随机数生成可视化)

翻开泛黄的桌游手册,一枚六面骰子滚落桌角。这枚传承千年的概率道具,如今在数字世界找到了更灵动的存在方式...