网络爬虫数据采集器

互联网每天产生超过300万GB的数据,如何高效挖掘这座信息金矿?网络爬虫数据采集器作为数字化时代的核心技术工具,正在重塑数据获取的边界。从企业决策到学术研究,从市场分析到舆情监测,这项技术正悄然改变着信息处理的方式。

数据抓取的底层逻辑

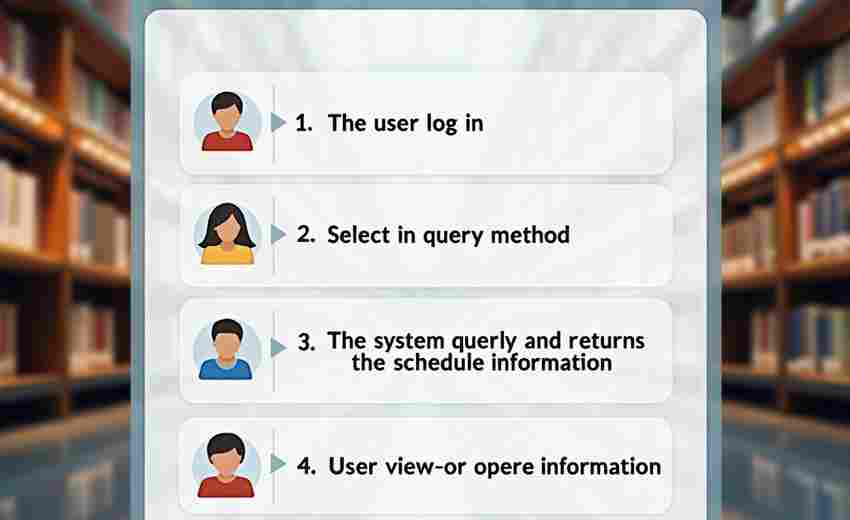

爬虫工具的工作原理类似人类的浏览行为,通过模拟HTTP请求与网页交互。核心模块包括URL调度器、网页下载器、解析引擎三部分。调度器负责分配抓取任务,下载器处理反爬机制与动态加载,解析器则通过XPath、正则表达式等技术提取结构化数据。区别于早期简单脚本,现代爬虫支持分布式架构,可通过IP池、请求头随机化等技术规避网站限制。

技术演进中的功能突破

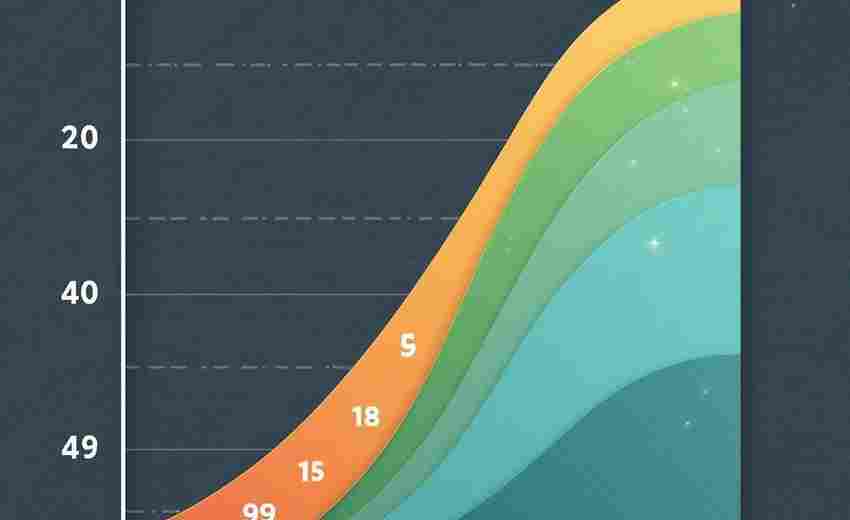

2022年GitHub开源项目统计显示,排名前50的爬虫框架中,38%已集成机器学习模块。这种进化使得工具能够自动识别网页结构变化,动态调整抓取策略。某电商价格监控案例显示,智能爬虫在网站改版后仍保持98%的数据捕获率,而传统脚本的失效率达到73%。部分商业级产品开始融合自然语言处理技术,实现评论情感分析与数据清洗的同步完成。

应用场景的多元裂变

金融领域的数据抓取正在改变投资决策模式。某私募基金通过抓取全球2000+新闻网站,构建舆情指数模型,其回测数据显示该策略超额收益达年化12.7%。医疗研究机构利用爬虫收集临床试验数据,将药物研发周期缩短约18个月。值得注意的是,政务数据开放平台上线后,超60%的开发者使用爬虫工具进行数据集整合。

合规边界的动态平衡

2023年欧盟《数字服务法案》实施后,全球主要爬虫工具均更新了robots.txt解析模块。实际操作中,技术成为关键考量。某跨国零售企业因过度抓取竞品网站数据,被法院判决赔偿230万欧元。专业开发者建议设置1-2秒的请求间隔,单日抓取量控制在网站总数据量的0.3%以内,这些细节往往决定项目的法律风险等级。

数据加密技术的升级倒逼爬虫工具持续迭代,基于WebAssembly的新型反爬机制使传统抓取方式失效率提升40%。开源社区正在探索浏览器指纹模拟等突破方案。政务数据的API化接入趋势,可能在未来五年内改变60%以上的数据采集模式。

- 上一篇:网络爬虫数据抓取工具(静态页面版)

- 下一篇:网络爬虫框架(自动抓取指定页面)

相关软件推荐

网络速度实时监测工具(图形化显示+历史数据记录)

发布日期: 2025-04-07 15:53:00

在数字化办公场景中,网络波动如同隐形的效率杀手。某科技公司研发的Network Velocit...

随机软件推荐

基于SQLite的简易家庭太阳能发电量统计系统

在屋顶光伏日渐普及的背景下,某技术爱好者社区近期流传着一套基于SQLite数据库的发电量统计方案。这套完全开源...

图片像素化处理工具(马赛克强度调节)

当一张照片需要隐藏敏感信息时,像素化处理往往是最直接的选择。市面上主流的图像处理软件基本都配备马赛克功...

网络爬虫图片抓取工具(过滤尺寸类型)

在电商平台批量采集商品图、为论文收集实验样本、给自媒体账号储备封面素材——这些场景背后都隐藏着图片抓取...

自动化邮件正文内容模板生成器(支持变量替换)

在商务沟通场景中,邮件正文的重复撰写耗费大量时间。据统计,普通职场人每天需处理约20封邮件,其中半数内容涉...

批量网页上传图片自动压缩工具

在数字化内容爆发式增长的今天,网页运营者常面临图片上传效率低、服务器负载过高的难题。手动逐张压缩图片不...

简易问卷调查系统(本地存储CSV结果)

一款基于本地存储的问卷调查工具正在成为市场调研、活动报名、满意度测评等场景的热门选择。该系统无需云端服...

EXCEL表格数据透视统计工具

面对密密麻麻的销售记录、庞杂的财务数据或是海量的库存信息时,很多职场人都会陷入手工统计的泥潭。Excel内置的...

基于关键词的本地文档全文检索工具

信息爆炸时代,个人电脑中堆积的文档数量常以千计。从工作报表到学术论文,从合同协议到读书笔记,如何在需要...

键盘输入记录分析器(带热力图)

办公室的日光灯下,程序员小王的手指在机械键盘上翻飞,清脆的敲击声里藏着肉眼难辨的输入规律。某天他在GitH...

简易RSS阅读器(Feedparser库版)

当信息获取成为现代人的刚需,RSS技术凭借其"订阅制"的内容聚合特性,在信息爆炸时代重新焕发生机。基于Python的...

PDF文本提取工具(内容复制与保存TXT)

日常工作中总会遇到需要从PDF文件中提取文字的场景。无论是合同条款整理、论文资料收集还是电子书内容归档,传...

简易VPN连通性测试工具

网络工程师常遇到VPN连接不稳定的问题,一款轻量级测试工具能快速定位故障点。市面上不少专业工具操作复杂,而...

系统服务状态监控与启停工具

在服务器机房此起彼伏的嗡鸣声中,运维工程师的日常工作如同在钢丝上行走。某个关键服务进程的意外中断,可能...

QQ微信消息关键词自动回复框架

深夜十一点半,某电商客服小王盯着电脑屏幕,手指在键盘上飞速敲击。聊天窗口里不断弹出"订单查询"、"物流跟踪...

屏幕录制工具(帧捕捉与视频合成)

数字内容创作场景中,屏幕录制工具正逐渐成为跨领域工作者的刚需装备。这类软件的核心功能围绕帧捕捉技术与视...

论文查重基础版(文本相似度比对)

随着学术研究规模的持续扩大,学术不端行为的监测需求呈现几何级增长。某科研团队基于自然语言处理技术研发的...

网站HTTP状态监控工具

互联网服务稳定性直接影响用户体验与商业转化。当服务器出现异常状态码时,如何快速定位问题成为运维团队的核...

短视频字幕文本摘要生成器

短视频时代的创意生产流程中,字幕文本的提炼需求正快速增长。某科技团队推出的短视频字幕文本摘要生成器,凭...

Flask实现的员工权限分级管理系统

在企业数字化管理中,员工权限分级直接影响数据安全与协作效率。一款基于Flask框架开发的权限管理系统,通过模块...

Python简易汇率换算命令行工具

折腾过汇率换算的朋友都知道,浏览器查汇率总有广告弹窗干扰,手机APP又常要求注册登录。某次帮朋友代购商品时...

PDF文件自动分页与关键字搜索工具

PDF文档处理工具近年来持续迭代,但真正解决用户核心痛点的产品依然稀缺。在信息爆炸的办公场景中,用户经常面...

外汇数据自动备份到云存储脚本

在金融交易领域,外汇数据的高频更新与海量存储需求使得数据备份成为刚需。传统人工备份效率低、容错性差,一...

系统进程优先级调整与管理工具

在多任务操作系统中,进程优先级的管理直接影响着系统资源的分配效率。无论是服务器运维、开发调试,还是普通...

网络爬虫天气数据获取器

气象数据在农业规划、物流调度、灾害预警等领域具有基础性作用。基于Python语言开发的网络爬虫天气数据获取器,...

代码仓库提交异常频率监测系统

清晨八点的办公室,某互联网公司的技术总监李航习惯性打开监控面板。一组红色预警引起他的注意:支付核心模块...

财务报表PDF智能解析导出工具

在财务数据量激增的数字化时代,企业对于高效处理财务报表的需求日益迫切。传统人工录入或简单PDF转Excel工具常面...

视频时长统计与分段切割工具

在视频内容井喷的当下,创作者们普遍面临素材管理的技术门槛。工欲善其事必先利其器,针对视频时长统计与智能...

Tkinter画板应用程序(支持保存为PNG)

在Python生态中实现一款轻量级绘图工具并不复杂。基于Tkinter框架开发的画板程序,既保留了原生GUI的简洁特性,又能...

物联网传感器数据时间戳对齐工具

工业现场的三轴加速度传感器每秒采集200次振动数据,智能电表的计量模块每15分钟上传一次能耗记录,车载GPS定位器...

网络图片自动下载与分类存储工具

现代数字信息处理领域,图片素材的获取与管理效率直接影响着工作效率。某款基于Python开发的网络图片采集工具,...

网页内容变更检测通知器

在信息爆炸的数字化时代,网页内容更新速度远超人工监控的极限。无论是电商价格波动、新闻动态发布,还是政策...

连续重复数据包网络监控器

在网络通信中,重复数据包通常被视为"冗余噪音"。它们可能由设备故障、配置错误或恶意攻击引发,长期堆积不仅浪...

帖子评论情感倾向分析插件

互联网每天产生海量评论数据,这些文字背后隐藏着用户真实的情绪密码。某款新近推出的情感分析插件正在帮助运...

使用PyYAML的配置语法校验工具

在软件开发领域,YAML格式的配置文件因其结构化与易读性深受开发者青睐。但当项目复杂度攀升时,手工检查数百行...

热搜数据自动生成交互式图表网页

互联网时代的热搜数据如同流动的黄金矿脉,蕴含着大众关注焦点与趋势密码。某款新兴工具通过智能算法,将微博...

股票价格监控与可视化预警工具

金融市场瞬息万变,投资者往往面临信息滞后与决策盲区。某科技公司近期推出的证券数据分析系统,通过多维技术...

简易服务健康状态HTTP接口

服务器运行异常往往在业务高峰突然爆发。某电商平台去年双十一期间因未及时发现数据库连接池泄露,导致支付系...

CSV文件列数据快速分析工具

在数据驱动的时代,技术人员每天需要处理大量结构化数据。面对动辄数十列的CSV文件,传统电子表格软件常常力不...

基于TXT文件的简易个人日记管理系统

许多人习惯用纯文本记录日常,但缺乏高效的管理方式。一款基于TXT文件的日记工具应运而生,它通过简单的命令行...

二十四节气日期计算与提醒工具

农历二十四节气是中国古代农耕文明的重要智慧结晶,既指导农业生产,也渗透于日常生活。随着现代生活节奏加快...