简易网络爬虫框架(使用Scrapy基础功能)

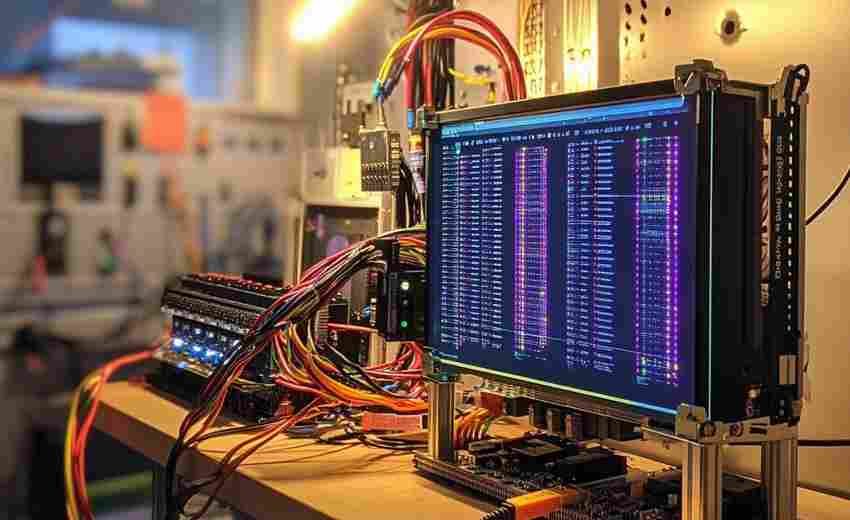

清晨的阳光照进办公室,程序员王磊习惯性打开终端窗口,十指在键盘上快速敲击。他要为正在开发的旅游比价平台抓取航空公司的票价数据,此刻Scrapy框架的黑色启动界面正泛着幽幽蓝光。

一、框架基础架构

Scrapy采用模块化设计,其核心引擎负责调度各组件协同工作。项目创建命令`scrapy startproject`会自动生成标准目录结构,其中settings.py文件存储着请求头、并发数等全局配置。实际开发中常见这样的场景:工程师在middlewares.py里添加自定义代理中间件,同时通过pipelines.py配置数据入库前的清洗逻辑。

二、数据抓取流程

爬虫启动时会从start_urls列表发起首个请求,这个设计让新手也能快速上手。在电商价格监控的案例中,开发者通常需要配置Rule规则实现分页抓取。当遇到动态渲染页面时,可搭配Splash服务处理JavaScript,此时需要调整DOWNLOADER_MIDDLEWARES设置加载渲染组件。

三、数据提取机制

XPath和CSS选择器在Scrapy中各有拥趸。某新闻网站抓取项目显示,使用`response.css('div.article::text').getall`能准确提取正文段落。对于复杂页面结构,开发者常组合使用这两种选择器,比如先用XPath定位包含评分的父节点,再用CSS获取具体的星级数值。

四、实用扩展方案

在爬取论坛类网站时,自动限速功能显得尤为重要。settings中的AUTOTHROTTLE_ENABLED参数能智能调节请求频率,避免触发反爬机制。实战中曾有团队通过自定义Item Pipeline,在数据存入MySQL前自动过滤广告内容,这种设计将数据处理与采集逻辑有效分离。

五、典型应用场景

旅游行业常用Scrapy抓取酒店房态信息,配置CrawlSpider可自动跟踪房型详情页链接。金融领域的数据分析师则依赖框架定期采集股票论坛舆情,他们会在spider_closed钩子函数中触发数据分析脚本。需要特别注意的是,某些新闻网站要求遵守robots.txt中的爬取延迟设置。

网络数据采集如同数字时代的淘金热,Scrapy提供的不仅是工具更是工业化解决方案。其异步处理机制能轻松应对百万级请求,但开发者仍需关注目标网站的API限制条款。定期检查爬虫日志中的重试记录,适时调整请求头中的User-Agent参数,这些细节往往决定着爬虫项目的存活周期。

- 上一篇:简易网络爬虫框架(Scrapy基础应用)

- 下一篇:简易网络爬虫框架(带反爬策略)

相关软件推荐

随机软件推荐

利用sounddevice实现的音频录制工具

许多开发者面对音频采集需求时,常被复杂的接口文档与设备兼容性问题困扰。Python生态中的sounddevice库因其简洁的...

网页内容变更监控工具(定时对比检测)

互联网信息的动态更新特性催生了网页监控工具的普及。这类工具通过定时抓取目标页面并与历史版本对比,能够快...

医院患者挂号信息管理桌面程序

在医院日常运营中,挂号流程的效率直接影响患者体验与资源分配合理性。一款专注于挂号信息管理的桌面程序,正...

基于CSV的奖学金评定辅助工具

每年高校奖学金评审季,教务人员总要面对堆积如山的申请材料。某理工学院学工处李主任回忆道:"去年我们手工核...

本地文件夹全文搜索工具

办公室电脑里堆积着15G的合同文档,研究资料分散在8个分类文件夹中,小说草稿隐藏在层层嵌套的目录深处——当数...

抖音无水印视频下载工具

短视频时代,抖音每天产出超过7000万条新内容。当用户偶然刷到心仪的视频时,收藏夹只能保留作品却无法下载,尤...

系统进程监控器(实时显示CPU-内存)

窗外的雨水敲打着玻璃,王工习惯性地按下Ctrl+Alt+Del,看着任务管理器里跳动的CPU曲线突然卡在98%。这已经是本周第...

自动生成目录结构文档工具(Markdown)

对于需要频繁处理复杂文件结构的开发者、文档工程师或项目管理者而言,手工维护目录结构文档既耗时又容易出错...

文件差异对比工具(支持目录对比)

程序员小张盯着屏幕上两份相似度99%的配置文件,额头渗出细密的汗珠。凌晨三点的办公室里,只有键盘敲击声和咖...

自动检测启动项数字签名工具

当计算机出现莫名卡顿或频繁弹窗时,很多用户的第一反应是打开任务管理器检查启动项。但面对列表中密密麻麻的...

日志文件缓存命中率分析器

在分布式系统与大数据处理场景中,缓存机制的有效性直接影响着系统性能。某互联网公司研发团队近期推出的日志...

多页面分页内容批量采集器

在信息爆炸的时代,如何快速、精准地获取结构化数据成为许多企业与研究者的痛点。传统的人工采集方式效率低下...

汇率换算计算器(实时汇率语音查询)

跨国旅行时总遇到现金不够的尴尬,网购海外商品常因汇率波动多花冤枉钱,国际转账手续费明细永远算不清楚。汇...

天气查询命令行接口(API调用)

三伏天出门前想查温度,打开手机却发现软件广告弹出、界面卡顿——当代人对于天气查询的需求早已从"看预报"转向...

批量下载网页图片资源采集工具

互联网图片资源采集常面临两大痛点:手动保存效率低、重复操作耗时久。以某款自主研发的图片抓取工具为例,其...

密码强度检测器(正则规则评分)

互联网时代每天产生近300万个密码,其中23%的密码能被黑客在30秒内破解。一套基于正则表达式的密码强度评分系统,...

文件属性批量签名工具(添加数字签名元数据)

在数字化办公场景中,文件安全传输面临着严峻挑战。某企业市场部近期遭遇的案例颇具代表性:发送给客户的200份...

航空航班时刻表冲突检测器

在航空运输领域,航班时刻表的编排直接影响机场运行效率与飞行安全。传统人工调度模式下,时刻表冲突检测依赖...

简易画图板应用程序(鼠标绘图)

在数字创作工具层出不穷的今天,一款操作简单的鼠标绘图软件正在设计爱好者中悄然流行。这款无需专业设备支持...

动态柱状图竞赛排名可视化器

在信息爆炸的时代,如何快速解读实时数据并直观呈现排名变化,成为许多领域的刚需。动态柱状图竞赛排名可视化...

多显示器屏幕画中画控制器

办公室的日光灯管嗡嗡作响,工位上的两块屏幕各自忙碌。左侧的Excel表格正在自动刷新数据,右侧的视频会议界面突...

文件压缩备份工具(zip-tar格式可选)

在数字文件管理领域,压缩备份工具堪称数据处理的瑞士军刀。Windows系统自带的zip功能虽然方便,但遇到大体积文件...

基于Requests库的网页内容抓取器

在数据驱动的技术场景中,高效获取网页内容成为开发者必备技能。Python生态中的Requests库凭借简洁的接口设计,成为...

批量图片格式转换脚本(PNG-JPG转换)

现代数字内容创作中,PNG与JPG格式的图片占据着绝对主流地位。专业摄影师常遇到客户临时要求变更图片格式的情况...

纺织品外贸报价单自动生成工具

传统纺织品外贸企业的业务员每天需要花费3小时处理报价单,反复核对汇率、税率、运输成本等数据。某服装出口公...

多文件类型缩略图生成器

数字资产管理已成为现代办公场景中的刚需。面对海量文档、图片及音视频文件,如何快速定位目标内容?一款名为...

屏幕放大镜工具(局部区域像素查看)

在数字图像处理领域,某些肉眼难辨的细节往往决定着作品的成败。设计师调整图标边缘的半透明像素,程序员排查...

语音小说转电子书生成器

通勤地铁里戴着耳机的上班族,深夜熄灯后辗转反侧的学生党,这些现代人习以为常的生活场景,正在推动阅读方式...

基于EXIF信息的图片批量重命名工具

当数码相机存储卡积累到第32GB时,摄影师王明发现他的工作流程出现了严重瓶颈——3427张未命名的.JPG文件杂乱堆砌...

错误日志与部署版本关联分析器

凌晨三点的告警短信惊醒运维工程师,生产环境突发服务崩溃。面对上千条错误日志和本月六次版本迭代记录,排查...

多线程微博粉丝画像数据采集工具

在社交媒体数据价值持续释放的今天,微博平台每日产生的用户行为数据量已突破5亿条。针对企业精准营销与用户研...

证件照背景色替换工具(OpenCV图像处理)

证件照背景色处理是图像处理领域的经典课题。传统方案依赖专业软件操作,存在学习成本高、流程繁琐等问题。基...

基于NLTK的文本情感原因定位分析工具

在自然语言处理领域,情感分析技术已广泛应用于商业决策与舆情管理。基于NLTK开发的文本情感原因定位分析工具,...

PyGObject系统剪贴板历史管理

在Linux桌面生态中,剪贴板作为高频使用的数据中转站,其功能拓展始终是开发者关注的焦点。基于GTK+框架的PyGObje...

时间单位转换器(秒-分-时-天-周换算)

地铁通勤时无意瞥见站台显示屏:列车将于3分25秒后进站。大脑下意识开始换算——205秒?0.057小时?这种条件反射式...

文件树形结构生成工具(输出为文本)

在软件开发或文档整理过程中,经常需要将复杂的文件目录结构转化为清晰的可视化文本。传统的命令行tree命令虽然...

打印机驱动关联文件验证工具

在日常办公或家庭使用中,打印机驱动问题常导致设备罢工。驱动文件丢失、版本冲突、注册表错误等隐患,可能让...

Python版扫雷游戏(矩阵算法实现)

折腾过代码的人都知道,用二维矩阵实现扫雷游戏的核心在于数据结构的精准把控。本文将拆解基于Python的扫雷矩阵...

自动同步分类文件至云存储工具

数字时代,文件管理成为日常工作的隐形负担。面对海量文档、图片、视频的存储需求,如何高效分类并同步至云端...

Excel表格数据合并工具(多文件同结构合并)

在日常办公场景中,Excel表格常被用于存储结构化数据。但面对多个格式相同、内容分散的文件时,手工复制粘贴不仅...