网络爬虫监控工具(基于Scrapy框架)

网络爬虫技术已成为企业获取数据的重要手段,而如何高效管理爬虫任务并确保稳定性,成为开发者关注的焦点。Scrapy作为Python生态中成熟的爬虫框架,凭借其模块化设计和高扩展性,成为多数企业的技术选型。但原生Scrapy在任务监控、异常处理等方面存在短板,需结合特定工具构建完整解决方案。

一、Scrapy的核心优势与监控痛点

Scrapy框架采用Twisted异步引擎,能轻松处理数千并发请求,其内置的Selector组件支持XPath与CSS选择器,显著提升数据解析效率。Middleware机制允许开发者自定义请求处理逻辑,例如动态代理、请求头随机化等功能。Item Pipeline模块则为数据清洗、去重和存储提供标准化接口。

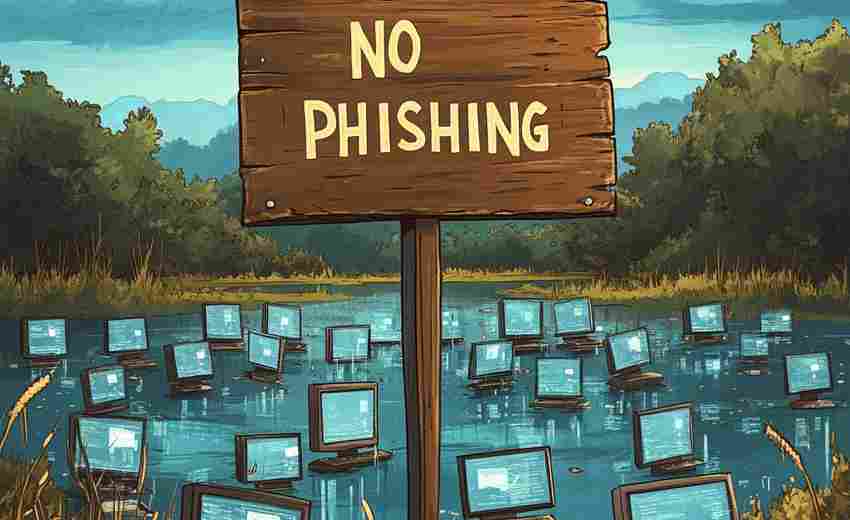

但在实际生产环境中,爬虫常面临三大问题:1)分布式部署时任务分配不均;2)反爬策略升级导致请求失败率陡增;3)数据入库环节出现异常难以快速定位。某电商公司曾因未设置IP熔断机制,触发目标网站防护系统,导致200余台爬虫服务器IP被永久封禁。

二、监控工具的核心功能设计

针对Scrapy的监控需求,成熟工具通常包含以下模块:

1. 代理IP池管理

集成动态代理服务接口,实时监测IP可用性。通过设置成功率阈值(如低于80%自动切换),配合地理位置伪装功能,某舆情监测平台将日均封禁率从35%降至6%。

2. 异常捕获与重试

在Downloader Middleware层植入异常分类器,区分网络错误(5XX响应)、内容异常(验证码触发)和系统错误。智能重试策略对验证码类错误立即切换代理,网络波动则采用指数退避重试,某新闻聚合项目借此将任务中断率压缩至0.3%。

3. 可视化仪表盘

基于Elasticsearch+Kibana构建实时监控视图,动态展示请求成功率、数据产出速率等20余项指标。支持设置阈值告警(如连续5分钟成功率<90%触发短信通知),某金融数据服务商借此将故障响应时间缩短至8分钟内。

三、典型应用场景实践

在电商价格监控领域,工具需每小时处理百万级SKU数据。通过设置分级速率限制:核心商品30分钟/次,长尾商品6小时/次,既保证数据时效性又避免触发反爬规则。配合分布式任务队列(如RabbitMQ),某比价平台实现日均400万条数据稳定采集。

舆情分析场景中,工具整合自然语言处理模块,实时识别网页正文并过滤广告内容。当监测到特定关键词(如品牌负面词汇)时,自动提升该站点的抓取优先级,某公关公司利用此功能将危机事件发现时效提升至15分钟级别。

四、技术选型建议

中小团队可优先考虑Scrapy+ScrapydWeb开源方案,通过Docker快速搭建监控环境。对于日请求量超千万级的企业,建议采用自研架构,结合Kafka实现日志实时分析,配合Prometheus进行资源监控。要注意避免过度设计——某初创团队曾因部署复杂监控链路,导致系统延迟增加40%,最终回归轻量级方案。

数据合规层面,需内置Robots协议检测模块,设置爬取间隔不低于目标网站要求。当涉及欧盟用户数据时,监控系统应自动触发匿名化处理流程,避免触碰GDPR红线。工具的价值最终体现在风险控制与效率平衡,而非技术堆砌的复杂程度。

- 上一篇:网络爬虫数据抓取工具(指定URL与规则)

- 下一篇:网络研讨会最佳举办时间计算器

相关软件推荐

随机软件推荐

薪资范围分布可视化工具

薪资分析一直是企业管理和职业规划中的重要环节。面对复杂的人力市场数据,如何快速理解行业薪酬趋势成为关键...

网页代码差异对比存档工具

互联网行业的技术迭代推动着网页开发流程的革新。当开发团队频繁更新页面时,代码版本管理常出现比对混乱、历...

文件修改时间范围搜索工具

日常工作中常会遇到这样的困扰:电脑里堆积了上千份文档,却急需找出上周修改过的合同终稿,或是需要核查某个...

利用正则表达式的文本敏感词过滤软件

数字时代的信息交互呈爆发式增长,社交平台、在线论坛等场景对内容合规性提出更高要求。基于正则表达式技术研...

实时股票价格查看器(调用财经API)

金融市场瞬息万变,专业投资者办公桌上总少不了一台持续闪烁的显示器。如今,依托财经数据接口(API)构建的实...

网页转PDF工具(基于浏览器引擎渲染)

互联网时代的信息保存需求催生了大量格式转换工具,其中基于浏览器引擎的网页转PDF工具因其独特优势逐渐崭露头...

网页广告元素屏蔽统计器

互联网广告的屏蔽率正以每年12%的速度攀升。当用户借助插件过滤页面元素时,企业主犹如在数字迷雾中蒙眼狂奔—...

扫描版PDF文字识别增强工具

扫描版PDF文件在数字化过程中常面临文字模糊、排版错位等痛点问题。针对这一需求,文字识别增强工具应运而生。...

天气信息API查询与展示工具

实时天气数据已成为现代人生活与工作中不可或缺的参考信息。无论是出行规划、活动安排还是商业决策,精准的天...

系统磁盘空间不足自动清理临时文件工具

电脑弹出"磁盘空间不足"提示时,多数人会陷入两难境地:手动清理既费时又怕误删文件,放任不管又影响系统运行速...

仓库物流信息批量更新脚本

在仓储物流管理中,信息同步效率直接影响库存周转与订单交付周期。传统人工录入或单条数据修改的模式耗时费力...

简易计算器图形界面工具

普通用户日常使用的计算器软件大多功能单一,但在开发者眼中,这类工具承载着人机交互的典型范例。现代编程语...

学生成绩管理系统(单机版)

教务办公室的日光灯管嗡嗡作响,张老师正对着堆积如山的成绩单发愁。期中考试刚结束,六个班级三百多份试卷需...

系统托盘日历日程提醒插件

现代人对于效率工具的依赖程度越来越高,一款好的软件往往能在细节中撬动生产力。系统托盘日历日程提醒插件正...

压缩包空目录清理器(自动删除无效路径)

在数字文件管理领域,隐藏着一个常被忽视的效率杀手——压缩包内残留的空目录结构。某网络安全公司的技术报告...

自动重命名规则化文件工具(日期-序号前缀)

在数字化办公场景中,文件命名混乱常成为效率瓶颈。某企业市场部曾因「客户方案V12_终版_FINAL(1).docx」这类命名...

论坛内容关键词密度分析工具

在论坛内容生态中,关键词如同潜行的导航员,直接影响着帖子的传播效率与搜索排名。某第三方数据机构统计显示...

气象数据文件重命名器(正则替换+气象站代码整合)

科研机构的气象观测站每天产生数十万份数据文件,某省气象数据中心曾因文件名编码不一致,导致台风路径分析延...

自动化Excel表格数据合并与格式转换工具

在数字化办公场景中,Excel数据处理的效率痛点长期存在。某科技团队近期推出的智能数据处理工具,针对性地解决了...

人口年龄结构堆叠柱状图生成器

在人口研究、政策制定或市场分析领域,年龄结构数据的可视化呈现往往直接影响决策效率。传统图表工具需要手动...

批量文件MD5校验码生成器

文件完整性校验是数据安全领域的基础需求。在科研数据传输、软件版本发布或企业内部文档管理中,文件在传输或...

图片EXIF信息提取与分类工具

日常拍摄的照片中隐藏着大量肉眼不可见的元数据。在专业影像管理领域,EXIF信息处理工具正成为摄影师、调查员、...

多进程日志文件实时分析监控工具

日志文件作为系统运行的核心记录载体,其分析效率直接影响运维响应速度。传统单线程日志处理工具面对TB级实时数...

网站Cookie内容正则解析工具

互联网应用中,Cookie作为用户身份验证与状态管理的重要载体,其内容解析常让开发者感到棘手。面对包含多个键值...

进程流量消耗阈值自定义提醒器

电脑或手机后台程序偷跑流量,是许多用户都遇到过的问题。下载软件时突然弹出流量告急提醒,追查原因才发现是...

批量文件压缩解压工具(ZIP-7z格式支持)

当代办公环境中,ZIP和7z格式的压缩文件已成为跨平台传输的标准载体。面对动辄上百个文件的打包需求,一款专业级...

本地文件搜索工具(按名称、扩展名过滤)

桌面上散落着新建文件夹(1).docx?下载目录里躺着三年前存过的发票扫描件?面对硬盘里数以万计的文件,多数人都会...

简易画板工具(支持保存为PNG文件)

屏幕右下角闪烁的光标常让人灵感枯竭,传统绘图软件复杂的工具栏更易劝退临时起意的创作者。一款名为QuickCanva...

绘画色彩混合模拟调色板

在数字绘画领域,色彩混合模拟工具正悄然改变着艺术家的创作方式。这类工具通过算法还原真实颜料混合效果,让...

批量重命名图片工具(日期序列化)

手机相册里堆积的五千张照片,旅行途中拍摄的八百张风景照,工作中积攒的三千份产品图——当数字影像占据存储...

屏幕区域监控与异常警报工具

在数字化办公场景中,屏幕内容的安全性与操作合规性逐渐成为企业管理的核心诉求。针对这一需求,屏幕区域监控...

系统托盘网络速度监控工具

许多人在日常使用电脑时会遇到网络卡顿问题。一款常驻系统托盘的网络监控工具能直观显示实时网速,帮助用户快...

文本转语音基础工具(pyttsx3实现)

文本转语音技术为程序交互开辟了新维度。在众多开源工具中,pyttsx3凭借其轻量级特性与跨平台优势脱颖而出。这款...

局域网文件传输助手(Python实现)

在办公场景中,跨设备文件传输的需求时常困扰着用户。传统方式如U盘拷贝存在硬件依赖,微信传输受限于网络速度...

PyQt5开发的GIF帧提取工具

在短视频创作与社交媒体传播盛行的当下,GIF动图因兼容性强、体积小巧的特点,成为内容创作者的重要素材。GIF编...

股票价格监控邮件提醒系统

在瞬息万变的股票市场中,价格波动往往以秒为单位计算,普通投资者很难全天候盯盘。针对这一痛点,股票价格监...

简易计算器应用(PyQt)

日常办公与学习中,一款操作流畅、界面简洁的计算器应用能够显著提升效率。基于Python生态的PyQt框架开发的桌面计...

多设备数据合并存储与对比工具

多设备数据合并存储与对比工具:效率与精准的革新方案 在数字化场景中,用户常面临跨设备数据分散的痛点。手机...

启动项运行环境检测工具

电脑开机后莫名卡顿?新安装的软件频繁闪退?这些问题往往与启动项配置存在直接关联。当操作系统加载过多自启...

桌面倒计时提醒小工具(可设置多个提醒事件)

电脑屏幕右下角突然弹出提示框,咖啡杯图标配合气泡文字提醒:"三分钟后部门例会"。这种场景正逐渐成为现代办公...