网络爬虫数据抓取工具(指定URL与规则)

一、核心功能解析

网络爬虫工具通过输入目标URL与规则参数,即可实现自动化数据抓取。用户只需在可视化界面配置网页元素路径,系统自动生成数据提取规则。动态网页支持JavaScript渲染技术,突破传统爬虫无法加载动态内容的限制。数据清洗模块内置正则表达式引擎,支持XPath和CSS选择器混合使用,确保采集结果的准确性。

分布式架构设计支持多线程并发采集,单机日处理量可达百万级数据条目。IP代理池功能有效应对反爬机制,自动切换匿名代理服务器,保持采集任务持续运行。断点续传机制在遭遇网络波动时,能自动保存采集进度,恢复后继续执行未完成任务。

二、技术实现特点

基于Chrome内核的无头浏览器技术,完整模拟人类浏览行为。页面加载速度优化至毫秒级响应,智能识别网页结构变化。规则配置界面采用拖拽式操作,非技术人员也能快速上手。API接口支持与MySQL、MongoDB等数据库直接对接,实现采集存储一体化。

反反爬策略包含请求头随机化、鼠标移动轨迹模拟等12种防护突破技术。数据校验机制通过机器学习模型自动识别异常数据,准确率比传统规则校验提升47%。任务调度系统支持定时触发和事件驱动两种模式,满足周期性采集与实时监控双重需求。

三、典型应用场景

某电商企业使用该工具监控1688个竞品店铺的价格波动,数据更新间隔压缩至15分钟。新闻聚合平台每日抓取327家媒体网站内容,信息采集效率提升20倍。科研机构通过配置专业术语词典,三个月完成百万篇学术论文的数据挖掘。

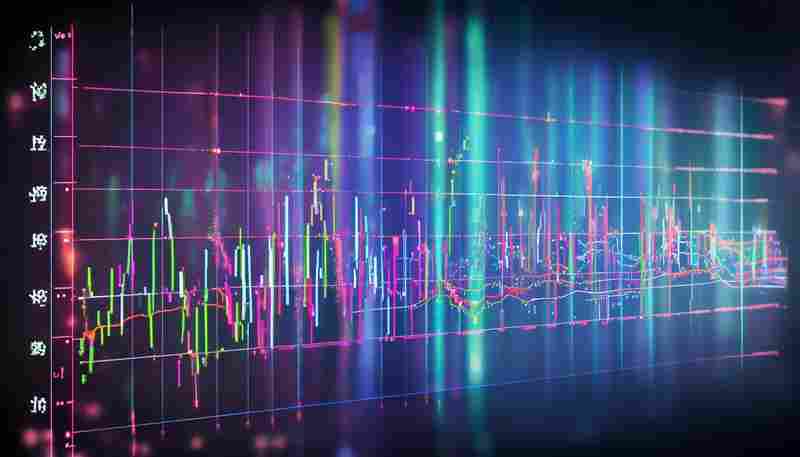

金融领域用户利用动态渲染功能,成功抓取股票交易平台的实时数据流。政务部门借助IP代理技术,突破地域限制采集全国工商信息数据。某制造企业整合供应商报价数据,采购成本降低12.6%。

数据质量直接影响决策有效性,工具内置的数据校验模块可过滤98%的脏数据。企业用户更关注数据采集的合法合规性,工具提供Robots协议检测与数据脱敏功能。开源框架二次开发成本是商业工具的3.2倍,中小企业更倾向选择现成解决方案。

相关软件推荐

随机软件推荐

密码管理工具(AES加密存储)

在各类账号数量爆炸式增长的当下,多数人仍在使用"生日+123"或"姓名+手机号"这类高危密码组合。某银行2022年泄露的...

桌面悬浮时钟工具(带秒表-计时器功能)

现代人的电脑桌面上总有几个"钉子户"软件,但最近我的任务栏被一款透明悬浮时钟取代了。这个半透明窗体像块玻璃...

知乎热门问题爬取与分析工具

打开知乎客户端,每天滚动出现的海量信息背后,隐藏着当代社会的认知图谱。当传统人工检索难以应对指数级增长...

多文件版本号自动更新工具

在软件开发过程中,版本号管理是一项看似简单却极易出错的任务。尤其是在涉及多个模块或跨平台项目时,手动修...

单词本记忆卡片系统(艾宾浩斯复习算法)

翻开单词本时,那些似曾相识的字母组合总让人陷入纠结——昨天刚背过的词汇,今天却像从未见过。这种遗忘困境...

基于历史数据的台风路径预测可视化工具

每年夏秋季节,台风路径的预测总会牵动沿海地区数亿人的神经。过去几十年间,气象学家通过分析近十万条台风历...

股票数据可视化K线图生成工具

提到K线图工具,很多人的第一反应是复杂的数据处理流程和专业术语门槛。但随着数据分析需求激增,市场上涌现出...

图片格式转换定时任务工具(元数据保留)

日常工作中,设计师经常遇到这样的场景:凌晨三点完成产品图册制作,第二天却要面对不同平台对WebP、JPEG、PNG格式...

基于邮件的内容爬虫(自动解析特定内容)

互联网时代每天产生约3000亿封电子邮件,其中蕴含大量商业情报与用户行为数据。针对邮件内容自动化采集需求,某...

简易计时器软件(正计时-倒计时模式)

手机应用商店里各类计时工具令人眼花缭乱,但真正能做到简洁高效的产品并不多。今天介绍的这款计时器软件,凭...

二维几何图形面积-周长计算器

在数学计算与工程测绘领域,二维几何图形的面积和周长计算需求几乎无处不在。一款高效的计算工具不仅能提升工...

基于DeepL API的文本翻译批处理工具

在全球化场景中,多语言文本处理的需求日益迫切。针对需要批量处理文档的场景,基于DeepL API开发的文本翻译批处...

简易网络端口监听检测器

在网络运维或安全检测场景中,端口监听状态排查是高频需求。一款轻量级端口检测工具可快速定位服务异常或潜在...

多条件文件分类存储管理器

现代办公环境中,电子文件的数量呈现指数级增长。面对海量文档、图片、音视频资料,传统的手动分类方式已难以...

空文件夹查找删除工具(递归扫描)

在数字文件管理过程中,空文件夹如同角落里无人认领的废弃纸箱,既占用视觉空间又拖累系统效率。尤其当用户经...

网络存储资源使用趋势分析工具

数字化浪潮推动企业数据存储需求呈指数级增长,传统存储管理方式逐渐暴露出响应滞后、资源浪费等问题。某科技...

CSV文件列数据格式合规性检查器

在数据处理领域,CSV文件因格式简单、兼容性强被广泛使用,但其灵活性也带来隐患:列数据格式错误可能导致下游...

基于标签的个人笔记分类与管理工具

凌晨三点的研究室灯光下,历史系博士生林默在堆积如山的文献中突然顿悟:当他在笔记软件中输入"拜占庭货币制度...

单词本背单词记忆应用

现代语言学习者常面临碎片化时间利用不足、记忆效率低下等问题。市面上各类背单词工具层出不穷,但真正贴合用...

学生成绩表关联分析与统计工具

教育场景中,成绩数据蕴藏着大量可挖掘的信息。传统人工统计难以发现学科间的潜在关联,更无法精准定位教学薄...

桌面宠物喂养小游戏

桌面宠物喂养小游戏:虚拟陪伴与趣味养成 在快节奏的现代生活中,许多人渴望通过轻松的方式缓解压力。桌面宠物...

备忘录搜索工具(全文关键字检索)

手机备忘录里堆着上千条未整理的工作日志,电脑桌面上散落着十几份会议纪要文档,社交软件里还收藏着几十条同...

天气API调用的登山路径安全评估器

登山活动因自然环境的多变性存在较高风险。如何提前预判潜在危险并规划安全路线,成为户外爱好者及专业团队的...

数据存储单位计算器(字节转MB-GB)

数据存储单位计算器:破除数字时代的换算焦虑 下载文件时看到“剩余存储空间不足”的提示,手机相册弹出“内存...

网页转PDF工具(基于浏览器引擎渲染)

互联网时代的信息保存需求催生了大量格式转换工具,其中基于浏览器引擎的网页转PDF工具因其独特优势逐渐崭露头...

网页快捷书签本地管理工具

当浏览器收藏夹累积到四位数时,上班族小李发现每次找资料都要滚动半分钟。某天他尝试导出书签文件,意外发现...

多窗口文件内容对比工具

在信息爆炸的时代,文件版本混乱、内容交叉对比的需求日益频繁。无论是程序员调试代码、编辑核对稿件,还是团...

金融指标关系力导向图生成器

在金融市场分析领域,数据间的关联性往往隐藏在庞杂的指标背后。如何快速梳理指标间的逻辑,成为从业者面临的...

电影收藏与评分记录工具

深夜的书房里,电脑屏幕泛着微光,鼠标光标在无数个电影海报缩略图之间来回跳跃。电影爱好者们或许都经历过这...

PySimpleGUI开发的桌面天气查询工具

窗外阴云密布时,桌面右下角的气温提示突然闪烁起黄色预警标志——这款由Python开发者社区近期热议的天气查询工...

CSV-Excel表格数据去重合并工具

CSV/Excel数据去重合并工具:提升效率的实用助手 在数据处理的日常工作中,重复记录和分散表格的合并问题几乎是每...

个人日记本加密存储软件

咖啡厅角落敲击键盘时,总担心旁人瞥见屏幕上的文字;手机备忘录里的心情碎片,某次误触分享险些酿成社交事故...

代码仓库历史版本空间追踪器

(段落间插入空行) 凌晨三点的办公室,屏幕上跳动着"Out of disk space"的报错提示。开发组长李明盯着持续集成流水线...

简易井字棋对战游戏(人机模式)

许多人对井字棋的印象还停留在童年课桌上的涂鸦游戏——简单、直接,胜负往往取决于谁先走错一步。但如今,一...

文字转语音播放工具

地铁站台的到站提示音响起,某出版社编辑在拥挤车厢里打开手机,将刚审阅完的电子书章节导入语音生成器。十五...

办公文档(DOCX-PPTX)内容批量提取器

日常工作中,大量堆积的Word文档与PPT文件常让人头疼。手动逐页复制、粘贴不仅耗时,还容易遗漏关键信息。一款专...

合并多个PDF文档的批处理工具

日常工作中,PDF文档的合并需求无处不在。无论是整合项目报告、归档合同文件,还是整理学术资料,一款操作便捷...

小型活动嘉宾邀请名单管理工具

组织小型活动时,嘉宾邀请名单管理常让筹备者头疼。传统的手动记录方式效率低下,纸质表格容易丢失,电子文档...

智能WiFi信号强度测绘仪

地下车库的智能门锁频繁掉线,会议室视频会议中途卡顿,复式住宅二楼总存在信号死角——这些真实存在的WiFi信号...

文件权限与属性保留同步工具

在服务器运维或跨设备协作场景中,文件同步工具的可靠性往往被简化为"能否完整传输数据"。真实环境中存在一个常...