Selenium驱动的动态网页数据抓取工具

互联网数据量爆炸式增长的时代,动态网页已成为主流技术形态。传统爬虫工具在应对JavaScript渲染、AJAX异步加载等动态内容时频繁失效,此时基于浏览器自动化技术的解决方案逐渐成为行业标配。

核心痛点与破局思路

动态网页的交互元素往往依赖用户行为触发,例如电商平台的商品评价需要手动点击"加载更多",社交媒体信息流随滚动条下滑持续更新。常规请求库仅能获取静态HTML,无法捕捉由JavaScript动态生成的内容。Selenium通过模拟真实浏览器环境,完整执行页面脚本,为数据抓取提供可行性保障。

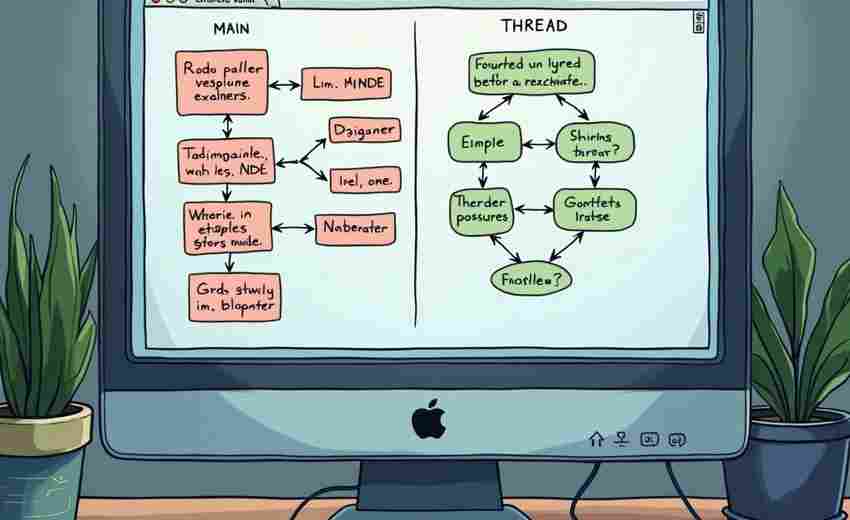

技术实现关键点

实际部署中需要着重处理几个技术细节:

1. 元素定位策略需兼顾稳定性与效率,优先采用相对XPath结合CSS选择器的混合定位方式

2. 显式等待机制(WebDriverWait)配合EC条件判断,能有效规避异步加载导致的元素定位失败

3. 通过禁用图片加载、启用无头模式(Headless)可提升30%以上的执行效率

4. 代理IP池与User-Agent轮换需与浏览器指纹修改同步实施,突破反爬机制

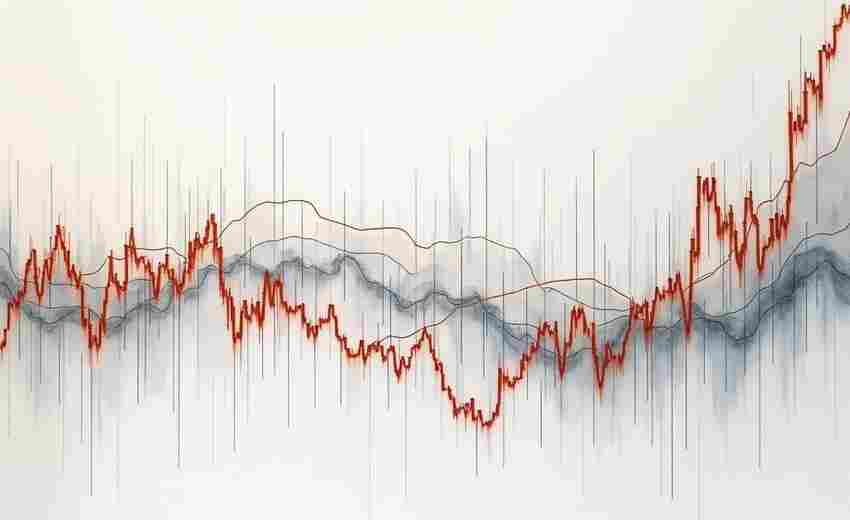

某金融数据平台的项目案例显示,使用Selenium配合智能等待策略后,动态财报数据的抓取成功率从47%跃升至92%。不过要注意控制浏览器实例数量,单个节点建议配置不超过3个WebDriver实例,避免内存过载。

进阶应用场景

对于需要登录验证的复杂系统,可通过持久化cookies实现会话保持。当遇到验证码拦截时,合理设置超时重试机制比即时破解更符合成本效益。部分团队尝试将Selenium与Scrapy结合,形成动静结合的混合爬虫架构,这种方案在处理大型网站时展现出了独特的优势。

数据抓取工具的选型需要平衡开发成本与维护成本。当遇到需要执行点击、滚动、表单提交等交互行为的采集需求时,基于Selenium的方案仍然是技术选型清单里的优先选项。随着无头浏览器技术的持续演进,这类工具的适用场景仍在不断扩展。

- 上一篇:Selenium Web自动化测试工具

- 下一篇:SHP文件属性表快速查看器

相关软件推荐

随机软件推荐

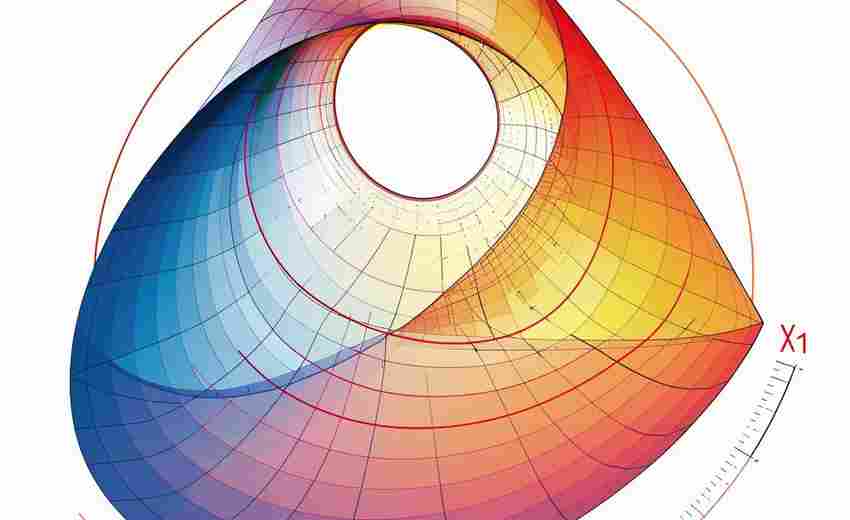

本地磁盘空间分析可视化工具(树状图)

在数字化时代,硬盘空间总在不知不觉中告急。面对层层嵌套的文件夹与混杂的文件类型,传统存储管理方式如同在...

屏幕截图与区域录屏工具

办公场景中,随手截取屏幕内容或录制操作流程已成为刚需。面对市面上数十款工具,如何选择适合自己的解决方案...

系统定时关机助手

办公桌前的咖啡早已凉透,屏幕上密密麻麻的窗口仍在运行。匆忙离开工位的职场人常会遇到这样的困扰——未完成...

自动生成周报模板工具(含时间区块划分)

职场人大多经历过类似的场景:每周五下午对着空白文档发愁,既要梳理工作成果,又得规划下周安排,折腾半天才...

TXT文件行号自动添加与移除工具

在办公场景或代码编写过程中,文本文件的行号管理常成为刚需。行号自动添加与移除工具正是为解决这一痛点而生...

文件夹同步备份到外接设备工具

日常工作中,文件误删、硬盘故障或设备丢失带来的数据风险难以预测。如何快速将本地文件夹同步至外置硬盘、U盘...

文件夹自动备份工具(定时压缩)

日常办公中,临时文件误删、硬盘突发故障造成的项目数据丢失屡见不鲜。某广告公司设计部曾因未及时备份,导致...

跨平台PDF阅读器历史记录清理器

数字时代的文件处理离不开PDF阅读器,无论是学术研究、商务合同还是日常资料查阅,用户几乎每天都会在不同设备...

自动生成测试数据工具(姓名-地址-日期等)

在数字化开发与测试领域,数据生成工具正成为工程师不可或缺的助手。这类工具通过算法模拟真实场景数据,既能...

基于Plotly的交互式流量仪表盘

在数字化转型浪潮中,数据可视化工具正在重构企业的决策模式。作为行业领先的可视化解决方案,Plotly推出的交互...

基于PyODBC的数据库查询性能分析器

在数据库密集型应用场景中,查询性能直接影响着系统响应速度和用户体验。基于PyODBC开发的数据库查询性能分析器...

社交媒体平台数据抓取与分析工具

在信息过载的社交媒体时代,每分钟产生的UGC内容超过50万条。某国际美妆品牌通过实时监测TikTok平台数据,发现"无...

简易待办事项管理工具(桌面提醒)

现代生活节奏加快,任务管理成为刚需。一款轻量、免安装的桌面待办事项工具,能帮助用户快速整理碎片化事务,...

电子书阅读进度跟踪器(TXT-EPUB格式)

地铁车厢里,电子书阅读器屏幕的冷光映在乘客脸上,手指划过页面的动作频繁却机械。当数字阅读逐渐成为主流,...

Matplotlib生成的文件大小分布柱状图工具

在服务器运维和存储优化的实际工作中,技术人员经常需要分析海量文件的体积分布特征。某开源社区近期推出的文...

自动桌面壁纸切换工具(定时更换源)

窗外天色渐暗时,电脑屏幕突然铺展开梵高的《星月夜》,这种不期而遇的视觉惊喜,是自动壁纸切换工具带给办公...

文件重复内容查找器(文本比对)

当电脑里积累上百份工作报告时,总有几个段落似曾相识;在整理学术资料过程中,不同文献的雷同表述让人难辨真...

文件权限修改工具(Linux权限数字模式)

在Linux系统中管理文件权限时,数字模式(Numeric Mode)始终是系统管理员绕不开的操作工具。这种看似简单的三位数组...

系统网络带宽监测工具

网络带宽如同数字世界的交通枢纽,实时监控如同给管理员配备了一副透视眼镜。当在线会议频繁卡顿、文件传输速...

根据关键词自动分类文档的整理工具

日常办公场景中,文档管理始终是困扰多数团队的难题。堆积如山的合同、会议记录、项目资料常因分类混乱导致检...

自动关机定时工具(可设置倒计时)

夜深人静的工作室,程序员小李突然想起下午设置的渲染程序还没保存。冲到电脑前,屏幕早已熄灭多时——这个月...

在线课程视频自动播放与打卡工具

随着在线教育渗透率逐年攀升,海量课程视频的观看进度管理与签到打卡成为高频痛点。某技术团队近期推出的智能...

基于Flask的个人博客静态页面生成器

在追求效率与个性化的互联网时代,越来越多的开发者开始尝试自建博客系统。基于Python Flask框架的静态页面生成器...

JSON文件结构验证与格式化编辑器

在数据交换与存储领域,JSON因其轻量化和易读性成为主流格式。手动处理JSON文件时,开发者常面临两大痛点:格式错...

股票价格提醒通知工具(定时爬取数据)

股市瞬息万变,价格波动往往在几分钟内决定盈亏。对于普通投资者而言,实时盯盘耗费精力,而错过关键节点可能...

多线程网站可达性批量测试工具

互联网服务稳定性已成为企业运维的核心指标之一,面对动辄上千的域名列表,传统检测工具常因效率不足导致监控...

文件路径规范化处理工具

在软件开发与运维领域,文件路径的标准化处理长期困扰着技术人员。某研发团队近期在部署Web应用时,因测试环境...

邮件正文自动摘要生成器

在信息爆炸的现代职场中,处理海量邮件已成为许多人的日常负担。据不完全统计,普通职场人平均每天需浏览超过...

自动化商品价格变化追踪器

在电商竞争日益激烈的当下,商品价格波动频繁成为常态。无论是商家制定促销策略,还是消费者寻找最佳入手时机...

任务完成打卡日历生成器

当代年轻人对抗拖延症的方式,总绕不开各类效率工具。在众多时间管理类应用中,任务完成打卡日历生成器凭借其...

简易CPU-内存占用监控工具(系统资源可视化)

当电脑突然卡成PPT,或是软件莫名闪退时,大多数人的第一反应都是疯狂点击鼠标。这时候如果有个工具能直观告诉...

图片背景移除工具

在电商视觉优化领域,某服饰品牌近期通过智能工具将日均产品图处理效率提升了5倍。这个数据背后,折射出当代图...

星空地图实时渲染程序

夜晚的城市灯光遮蔽了银河的光辉,但技术为现代人打开了一扇全新的观星窗口。某科技团队近期推出的星空地图实...

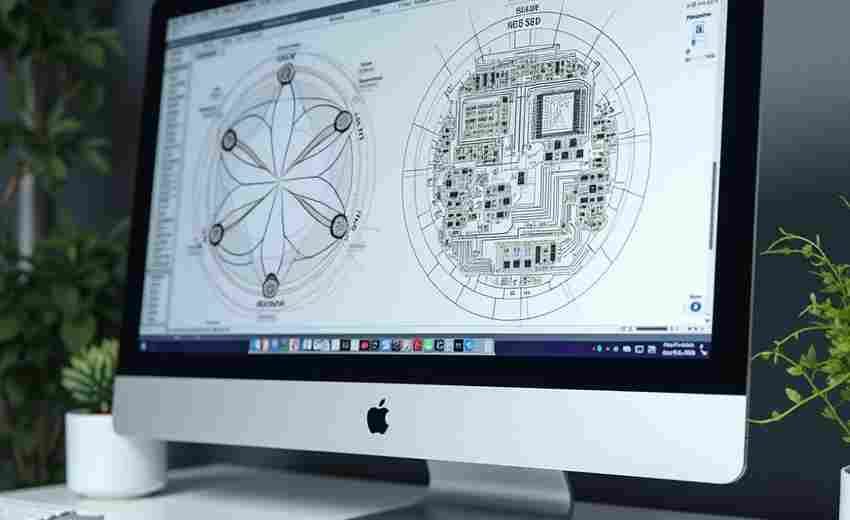

企业股权结构解析工具

现代资本市场中,股权结构的复杂程度往往超眼识别范围。某集团企业最近发现,旗下参股的科技公司通过多层嵌套...

批量重命名ZIP内文件工具

日常工作中总会遇到这样的场景:电脑里堆积着数百个从不同渠道获取的压缩文件包,打开某个ZIP文档时,内部的文...

本地文件版本库浏览器

在软件开发过程中,代码版本管理的重要性无需多言。无论是个人开发者还是团队协作,如何快速回溯历史版本、对...

软件需求文档变更追踪系统

在软件开发过程中,需求文档的频繁变更是团队面临的常态。据统计,约70%的项目延期与需求管理失控直接相关。面...

网络文件同步备份工具

窗外的雨点敲打着玻璃,李然盯着电脑屏幕弹出的"硬盘损坏"提示,手指微微发凉。这个月第三次发生的存储故障,让...

本地文件搜索工具(按关键词查找文件)

办公族都经历过这样的抓狂时刻:上周刚保存的方案文档、三个月前的财务报表、去年拍摄的客户活动照片,明明记...

办公文档自动生成目录工具(TOC)

打开任意一份超过二十页的文档,超过七成用户会首先寻找目录定位内容。传统手动编制目录不仅耗时耗力,更存在...