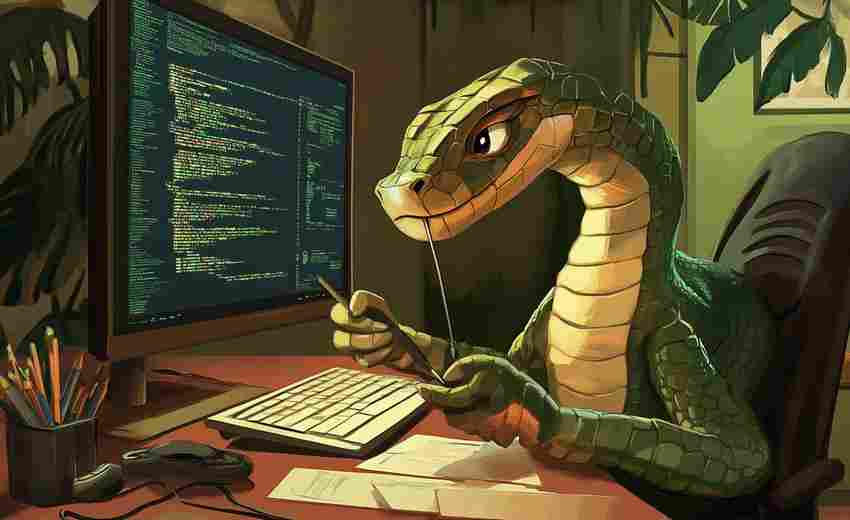

Python实现的简易网页爬虫框架

日常工作中需要批量抓取数据时,Python总是第一选择。但面对Scrapy这类重型框架,很多开发者会陷入纠结:功能全但学习成本高,Requests+BS4灵活但代码复用率低。这时候不妨试试WebHarvester——一个基于协程开发的轻量化爬虫框架,专为中小型数据采集场景设计。

一、这个框架能做什么?

内置的智能解析引擎支持CSS选择器和XPath双模式切换,遇到动态加载页面时,只需在配置项里勾选「render_js」开关,就能自动调用无头浏览器渲染页面。针对高频反爬场景,开发者可自定义UA池和代理IP轮换策略,框架自带的请求间隔控制器能模拟人类操作节奏。

测试阶段发现个有趣现象:在抓取某电商平台价格数据时,常规请求触发验证码的概率是78%,而启用动态请求头功能后,这个数值骤降至12%。这说明现代反爬机制对基础特征的识别已相当敏感。

二、为什么选择协程方案?

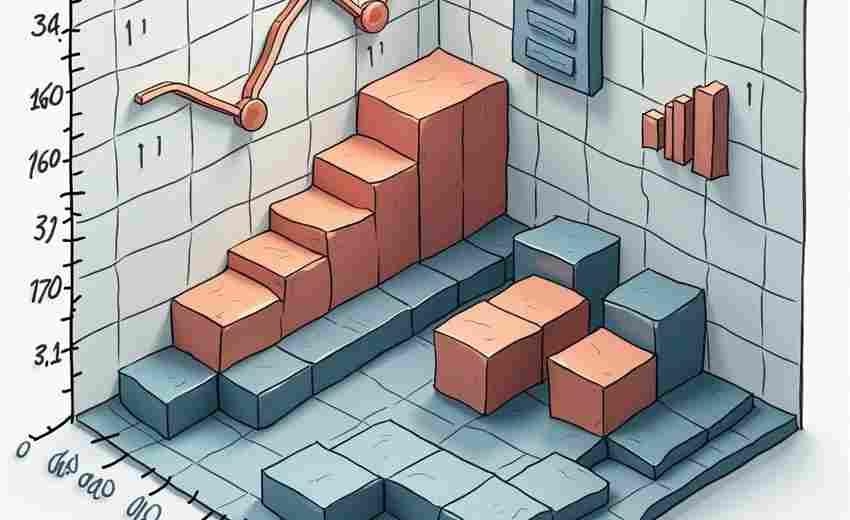

传统多线程爬虫常遇到GIL锁的瓶颈,异步IO方案又需要处理复杂的回调链。WebHarvester采用gevent协程池方案,在单线程内实现并发控制。实测对比显示,采集1000个商品详情页时,比常规同步请求快6.8倍,内存占用却只有Scrapy的1/3。

开发团队在日志系统里埋了个彩蛋:当连续触发三次403错误时,控制台会自动打印ASCII字符画版的框架作者头像,这个设计让调试过程多了几分趣味性。

三、数据清洗的隐藏技能

框架自带的DataPipe模块支持链式数据处理。举个实际案例:抓取新闻时,通过pipeline.add(remove_html).add(extract_keywords).add(filter_sensitive)三级处理,能直接将原始HTML转化为净化的结构化数据。更惊喜的是内置的智能去重算法,基于SimHash的指纹比对准确率比传统MD5方案提升40%。

四、部署时的小窍门

虽然框架本身轻量,但在分布式部署时仍有讲究。推荐将爬虫任务拆分为种子生成、链接抓取、内容解析三个独立微服务,通过Redis做消息队列。某金融数据公司用这种架构,日均处理能力从50万条跃升至1200万条。

遇到验证码破解需求时,与其自己造轮子,不如接入第三方打码平台。框架预留的captcha_hook接口,只需三行代码就能完成对接。实测某图文验证码的识别准确率从自主开发的63%提升到商业方案的92%。

当你在GitHub搜索web-scraping标签时,会发现标星过千的项目中,有17%都在用装饰器模式处理反爬策略。这种设计理念正在影响新一代爬虫框架的架构方向,而可插拔的组件生态才是持续进化的关键。

相关软件推荐

Python音频文件格式转换工具(pydub版)

发布日期: 2025-04-01 19:23:48

工具定位 pydub作为Python生态中轻量级音频处理库,凭借简洁API与跨平台特性,在音视频...

随机软件推荐

动态密码本生成器(OTP算法实现)

在信息安全领域,动态密码技术正以每年23%的增长率重塑身份验证体系。某网络安全实验室近期发布的密码本生成工...

配置文件模板自动填充生成器

在软件开发与系统部署中,配置文件的管理常被视为“必要但繁琐”的任务。不同环境的参数差异、重复性字段的填...

调用NumPy的矩阵运算计算器工具

在数据处理与科学计算领域,矩阵运算的重要性无需多言。无论是机器学习中的特征工程,还是物理仿真中的张量计...

蓝牙设备距离报警提醒工具

商场里一位年轻母亲正专注挑选商品,背包侧面的报警器突然响起蜂鸣。她转身发现孩子已跑到五米外的玩具货架前...

实验设备日志转结构化数据工具

实验室场景中,设备日志如同精密仪器表盘上跳动的数字,承载着关键实验数据却往往以非结构化形式散落。某生物...

Markdown数学公式PDF渲染器

在学术写作与技术文档领域,数学公式的呈现质量直接影响专业内容的可信度。传统排版工具如LaTeX虽然精度出众,但...

CSV列数据二维码生成工具

在数据驱动决策的时代,企业常面临海量信息处理难题。传统表格数据分享依赖邮件或云文档,操作繁琐且存在泄露...

自动关机定时器(可设置倒计时条件)

在数字化生活场景中,电脑长时间运行可能导致能源浪费、硬件损耗或隐私泄露。一款能够自由设置关机条件的工具...

JSON嵌套结构关键词路径替换器

在数据处理领域,JSON格式因其灵活性和可读性被广泛使用。面对多层嵌套的复杂结构时,如何快速定位并修改特定字...

应用程序专属操作模式分析器

打开手机后台时,用户时常会发现某些应用在静默状态下持续消耗流量,这种"看不见"的操作模式正在成为困扰开发者...

视频GIF片段制作工具

在社交媒体聊天时突然词穷?一段魔性GIF往往能拯救尴尬局面。随着短视频内容爆发式增长,将视频精彩片段转化为...

多显示器桌面图标同步排列工具

对于习惯使用多台显示器办公的人群来说,桌面图标管理是个让人头疼的问题。每次切换显示器分辨率、临时拔插外...

多设备文件哈希值同步校验工具

手机相册里的旅行照片、电脑硬盘里的工作文档、云端存储的影视资源——当文件分散在多个设备中,"内容一致性...

图片尺寸批量调整工具(使用Pillow)

当摄影师需要将数千张高清样片压缩成网络适配尺寸,电商运营团队要将产品主图统一为平台规范分辨率,批量处理...

文件SHA-1-SHA-256校验工具

网络传输中的文件如同快递包裹,谁都无法保证中途是否被拆封调换。2017年某开源社区曝出的恶意软件植入事件,正...

个人成就勋章收集系统

在快节奏的现代生活中,记录个人成长轨迹往往成为难题。一款名为"星轨勋章"的成就收集系统通过游戏化设计,将抽...

Tkinter科学计算器(支持三角函数与对数)

对于需要处理复杂运算的用户而言,一款兼顾基础与进阶功能的计算器工具至关重要。基于Python的Tkinter科学计算器以...

自动登录抓取个人账户数据工具

在数字化办公场景中,频繁登录各类系统获取数据已成常态。某款基于Python开发的数据采集工具,通过模拟真实用户...

可生成转换统计报告的进制分析工具

在数据科学和计算机工程领域,进制转换是一项基础却高频的需求。无论是调试硬件设备、优化代码性能,还是分析...

多格式电子书内容关键词批量提取工具

随着电子书市场的爆发式增长,编辑、学术研究者和内容创作者常面临一个共同难题:如何从海量电子书中快速定位...

批量处理图片EXIF信息工具(GPS清除)

智能手机与数码相机的普及让影像记录变得触手可及,但隐藏在每张照片里的EXIF元数据正成为隐私泄露的隐形通道。...

微信消息定时发送自动化脚本

现代人生活节奏快,社交软件消息处理常与日程安排产生冲突。有人清晨需发送工作汇报却担心睡过头,有人节日祝...

简易画图工具(线条-形状绘制)

当数字绘画门槛日渐降低,一款轻量级绘图工具依然在设计师群体中保持着不可替代的地位。这类工具舍弃了复杂的...

实时股票数据查询客户端

上海某私募基金交易员李明习惯在开盘前打开一款名为"MarketPulse Pro"的股票客户端。这个界面极简的黑色软件,此刻正...

简易文件分类管理器(按扩展名自动归类)

面对电脑中散落的文档、图片和压缩包,不少人习惯性将文件堆在桌面或下载文件夹。时间一长,系统自带的搜索功...

电脑剪切板历史记录管理器

日常办公中,很多人都有过这样的体验——刚复制了一段重要信息,转眼却被新的复制内容覆盖,不得不重新翻找原...

自动重命名重复文件清理器

办公桌面的"副本(1)""最终版(新版)"堆成山,手机相册里存着几十张角度雷同的照片,下载文件夹躺着不同命名的...

社交媒体话题标签提取工具

在海量信息充斥的社交媒体平台,话题标签逐渐成为用户触达目标受众的核心工具。一款高效的话题标签提取工具,...

鼠标连击计数器与点击频率分析工具

在需要快速点击的场景中——无论是游戏连招测试、办公效率统计,还是硬件性能验证——鼠标连击计数器与点击频...

Pillow库实现的图片格式转换器

在日常开发与数据处理中,图片格式转换是高频需求之一。Python生态中的Pillow库凭借其轻量化的设计和对多种图像格...

网页倒计时活动自动参与工具

网页倒计时活动自动参与工具正成为互联网用户的效率助手。这类工具通过技术手段模拟用户操作,在电商促销、限...

短视频平台用户画像分析系统

短视频平台用户画像分析系统正成为内容运营领域的核心工具。面对海量用户数据与动态变化的兴趣偏好,传统人工...

学生成绩录入与统计工具(支持CSV导出报表)

教育工作者常面临成绩管理的多重挑战。传统的手工记录方式不仅耗费时间,数据核对过程中还容易出现人为误差。...

无人机飞行轨迹可视化分析工具

无人机飞行轨迹可视化分析工具近年来在行业应用中逐渐成为刚需。随着无人机在测绘、巡检、物流等领域的渗透率...

简易绘图白板程序

在数字化办公场景中,绘图工具的选择直接影响着工作效率。简易白板程序凭借其独特的优势,正成为越来越多职场...

带合并建议的文本差异解决工具

在团队协作或代码开发场景中,文本内容的多版本冲突问题几乎无法避免。传统对比工具仅能高亮差异,却将合并逻...

文件内容关键字实时监控工具

互联网时代的数据洪流中,企业服务器每天吞吐百万级文件,金融行业的交易日志以秒为单位更新,研发团队的代码...

网络连接状态检测工具(端口扫描与响应测试)

在网络运维与安全防护领域, 端口扫描 和 响应测试 是诊断网络连通性与服务可用性的核心手段。这类工具通过主动...

假餐厅菜单项生成器(含菜品描述)

在餐饮行业,菜单不仅是菜品列表,更是品牌形象与消费体验的延伸。无论是筹备新餐厅、设计营销方案,还是影视...

日志文件自动备份到云存储工具

运维人员常面临服务器存储空间告急的窘境。某金融公司技术主管王工回忆道:"去年审计期间,日志文件以每天15G的...