Python实现MySQL慢查询日志分析工具

(背景)运维过数据库的人都知道,慢查询日志就像系统体检报告单。面对动辄数GB的日志文件,如何快速定位性能瓶颈?笔者基于Python开发了一款轻量化日志分析工具,在多个生产环境中解决了实际问题。

(功能展示)该工具支持解析超过200MB的日志文件,通过阈值过滤将执行时间超过1秒的SQL操作自动归类。特别处理了含有换行符的多行语句,避免传统文本编辑器分析时出现的语句截断问题。在最近一次压力测试中,成功从12万条日志记录中筛选出37条高危操作。

(实现原理)核心采用正则表达式引擎处理日志格式,针对MySQL 5.7与8.0版本差异做了兼容处理。通过词法分析将原始日志拆解为时间戳、执行时长、SQL语句等结构化数据。统计模块运用哈希表存储查询指纹,自动合并相同模式的SQL语句。

```python

日志解析核心代码片段

import re

pattern = r"Query_time:s+(?P

(?P

compiled_re = pile(pattern, re.MULTILINE | re.DOTALL)

```

(应用场景)开发环境中可用于验证ORM框架生成的SQL效率,生产环境中配合Zabbix监控触发预警。某电商系统曾通过该工具发现商品列表页存在未使用索引的联表查询,优化后接口响应速度提升6倍。

(性能优化)采用流式读取处理大文件,内存占用稳定在30MB以内。提供--threshold参数动态调整慢查询阈值,支持输出JSON格式便于与ELK系统集成。未来计划加入执行计划解析功能,直接关联慢SQL的索引使用情况。

建议将分析结果与pt-query-digest对比验证,注意不同MySQL版本的时间精度差异。处理含二进制数据的长文本字段时,建议开启truncate模式避免内存溢出。

相关软件推荐

简易代码高亮编辑器(Tkinter实现)

发布日期: 2025-04-11 13:52:57

Tkinter作为Python内置的GUI工具包,常被开发者用来快速构建桌面应用。近期笔者在GitHu...

基于Python的简易HTTP服务器搭建工具

发布日期: 2025-04-10 11:15:28

命令行窗口弹出黑色背景,光标闪烁的瞬间,许多开发者会本能地敲下`python -m http.se...

Tkinter实现的画图板(基础绘图功能)

发布日期: 2025-04-22 17:39:20

在Python生态中,Tkinter作为标准GUI库常被开发者忽视其潜力。本文将展示如何运用该库实...

PDF文档文本提取工具(PyPDF2库实现)

发布日期: 2025-04-17 12:13:27

PyPDF2作为Python生态中处理PDF文档的热门工具库,其文本提取功能常被开发者用于自动化...

随机软件推荐

基于Python的简易文件分类工具

办公室电脑里散落着上千份文档,设计师的素材库混杂着不同格式的素材文件,程序员的下载目录堆满各类压缩包—...

简易2D绘图板(支持导出矢量图)

作为设计师的办公桌上,总少不了一款趁手的绘图工具。近期测试的PixTool 2D绘图板以其轻量级架构和矢量输出能力,...

简易数据库导出工具(SQLite转Excel)

在日常办公场景中,SQLite数据库与Excel表格的格式壁垒常带来数据孤岛问题。某开发团队推出的桌面工具,通过独创的...

天气查询命令行工具(API数据解析)

窗外暴雨突至时,程序员的手指仍在键盘上飞舞。这个经常被忽视的场景,恰好揭示了命令行天气工具存在的价值—...

支持OCR识别的截图文字提取工具

数字时代每天产生海量图像信息,办公场景中PDF合同、会议纪要截图、纸质文档照片等非结构化数据大量堆积。传统...

基于email模块的邮件内容解析器

现代办公场景中,邮件数据解析是常见的开发需求。Python标准库中的email模块提供了完整的邮件解析能力,其内置的解...

批量下载图片爬虫脚本

网络图片资源的收集常面临效率瓶颈。面对需要批量获取图片的场景,手动逐张保存耗时费力。通过编写自动化脚本...

命令行界面迷宫生成与探索游戏

在复古游戏与极简主义回潮的趋势下,一款名为 MazeCLI 的命令行工具悄然走红。它通过纯文本界面实现了迷宫生成、...

基于控制台的文本差异高亮对比工具

在软件开发与系统运维领域,文本差异比对是高频且刚需的操作。当开发者需要确认代码版本迭代细节,或是运维人...

批量下载指定类型文件工具(按扩展名筛选)

在日常文件管理场景中,用户常面临从海量数据中精准提取特定类型文件的难题。例如,摄影师需从混合文件夹中筛...

多平台社交媒体账号检测工具

品牌方市场部负责人李明最近有些头疼。某社交平台突然出现大量仿冒其官方账号的山寨号,这些账号不仅使用高度...

基于正则的CSV数据脱敏工具

在数据驱动业务的时代,CSV文件因结构简单、兼容性强,成为企业间高频流转的数据载体。敏感信息泄露的风险也如...

文件修改监控与版本对比脚本

在软件开发与系统运维场景中,文件内容的意外修改或版本混乱常常导致排查成本激增。针对这一痛点,文件修改监...

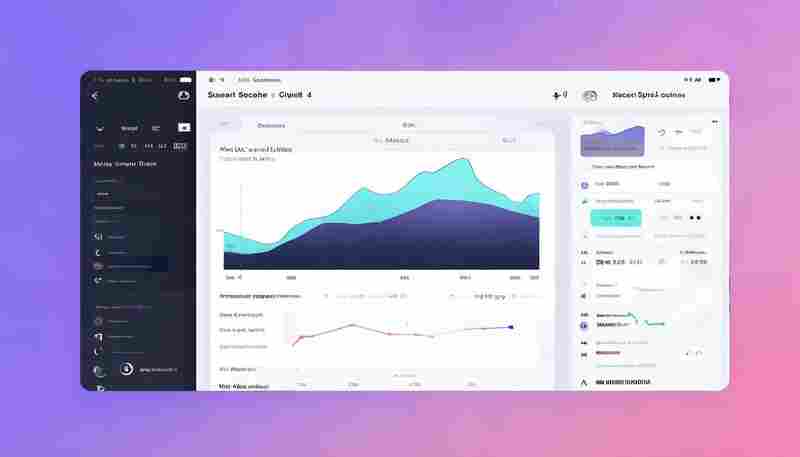

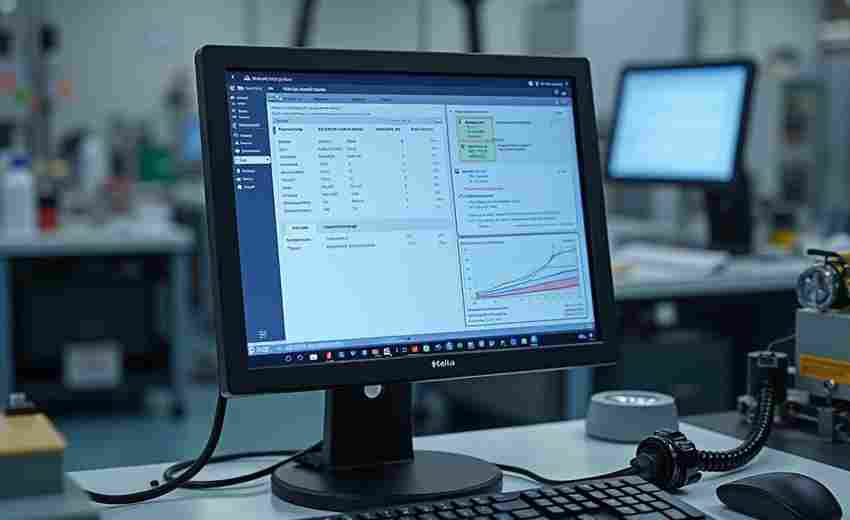

数据库索引使用率分析工具

在数据库运维领域,索引优化向来是DBA们头疼的难题。传统的人工排查方式如同大海捞针,不仅耗时耗力,还常常出...

短视频话题挑战赛参与度统计工具

短视频平台的话题挑战赛已成为品牌营销与用户互动的核心场景。如何在短时间内精准捕捉活动效果,一套专业的数...

支持色块标记的代码片段库

在编程领域,代码的可读性与维护效率直接影响开发流程。近年来,一类支持色块标记的代码管理工具逐渐成为开发...

桌面倒计时提醒小部件(系统托盘图标版)

工作间隙查看手机时,发现下午的会议还剩半小时;赶稿过程中突然意识到截稿时间逼近;午休后忘记关掉重复的闹...

屏幕录像工具(低分辨率版)

许多人习惯性追求高清画质录制,却忽视了低分辨率屏幕录像工具的独特价值。当用户需要快速捕捉屏幕动态、传输...

共享文件夹内容变化推送通知工具

在数字化办公场景中,共享文件夹已成为团队协作的重要载体。但当多人同时操作同一批文件时,内容被误删、覆盖...

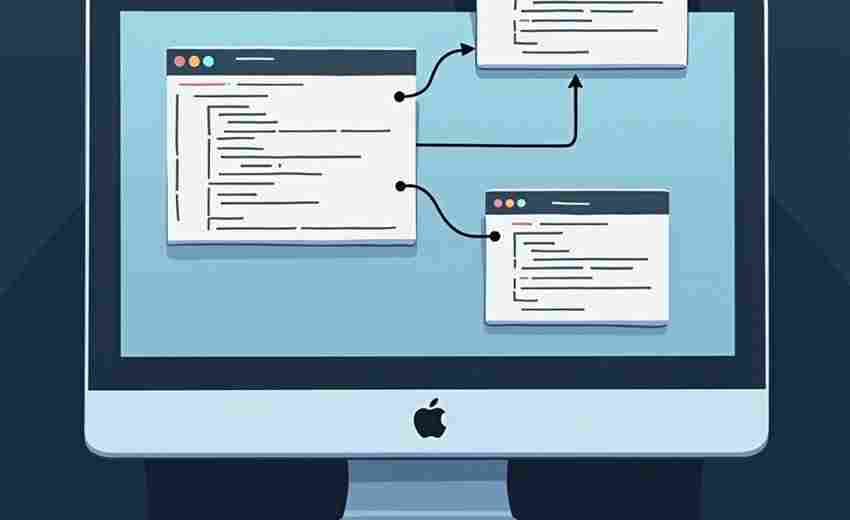

应用程序依赖关系分析工具

在软件工程领域,项目规模的膨胀往往伴随着依赖关系的复杂化。一个中型微服务系统可能包含数百个组件,依赖库...

图片压缩与格式转换器

在数字化信息爆炸的今天,图片已成为日常沟通与内容创作的核心载体。高分辨率图片占用大量存储空间,不同场景...

按时间规律批量创建模拟文件工具

在日常数据处理、软件测试或系统开发场景中,常需批量创建带有特定时间戳的模拟文件。手动逐一手动生成不仅耗...

颜色选择器(支持调色板)

在数字设计领域,颜色选择器早已突破基础取色功能,向着专业化协作工具进化。最新发布的Chromatica Pro 3.0版本,凭...

图像中棋盘格角点检测工具

棋盘格角点检测是计算机视觉领域的一项基础技术,广泛应用于摄像头标定、三维重建、工业测量等场景。其核心目...

桌面便签工具(支持保存与提醒)

清晨八点的办公室键盘声中,某科技公司产品经理张薇习惯性点开屏幕右下角的橙色图标。三行待办事项、两则会议...

图片相似度比对工具(直方图算法)

在数字图像处理领域,快速判断两张图片的相似度是许多场景下的刚需。直方图算法作为一种基础且高效的技术方案...

网络爬虫图片去重与压缩工具

互联网图片资源呈爆发式增长,如何高效处理海量图片成为开发者面临的实际问题。一套整合网络爬虫、图片去重与...

跨平台PDF阅读器历史记录清理器

数字时代的文件处理离不开PDF阅读器,无论是学术研究、商务合同还是日常资料查阅,用户几乎每天都会在不同设备...

基于自然语言的日期提醒解析器

在信息爆炸的时代,时间管理工具逐渐成为刚需。传统日历应用繁琐的操作步骤——点开软件、手动选择日期、输入...

社交媒体数据定时抓取与备份工具

社交媒体数据已成为企业运营与个人用户不可或缺的数字资产。面对海量信息的实时更新与平台规则限制,如何高效...

系统快捷键映射管理器

在数字办公场景中,键盘快捷键早已成为提升效率的核心工具。但系统自带的快捷键往往无法满足个性化需求——例...

影视剧本人物对话情感分析工具

这段对手戏的张力不够""主角的情绪转变太突兀"——剧本创作过程中,创作者常陷入情感表达的困境。一款基于自然...

CPU-RAM使用率悬浮图表

当电脑运行卡顿、程序无响应时,多数用户的第一反应是调出任务管理器查看资源占用情况。针对这个高频需求,一...

基于ARP协议的局域网设备扫描器

在复杂的局域网环境中,快速识别并管理接入设备是运维工作的重要环节。基于ARP协议的扫描工具,因其高效性与底...

系统调用跟踪资源关联器

在Linux系统运维领域,工程师们经常面对这样的困境:某个进程突然异常消耗大量CPU资源,或是某个服务莫名其妙地占...

小说章节自动抓取合并工具(正则匹配)

对于习惯在网络上追更小说的读者来说,碎片化的章节更新常带来阅读体验的割裂。手动下载每一章、整理顺序、合...

系统网络速度测试工具(上传下载带宽检测)

互联网时代,网络质量直接影响着工作娱乐体验。打开在线视频频繁缓冲、多人游戏频繁掉线时,普通用户往往难以...

SymPy符号计算系统

在麻省理工学院的实验室里,数学系研究生艾米莉对着屏幕上的积分公式皱起眉头。她需要验证的微分方程解涉及复...

招聘数据分行业词频对比分析工具

在招聘市场信息爆炸的背景下,企业常面临海量岗位描述数据难以提炼核心需求的痛点。一款针对招聘数据的分行业...

天文数据文件可视化关联器

浩瀚宇宙中,天文观测设备每天产生数百TB的异构数据——从射电望远镜的频谱记录到空间探测器的多维坐标,再到光...