CSV文件数据去重清洗工具

在数据处理领域,CSV文件因其轻量化和兼容性强的特点,成为存储、交换数据的常见载体。实际业务中常会遇到因人工录入、系统导出或数据合并导致的重复记录问题。这类冗余数据不仅浪费存储资源,还可能引发分析结果偏差。针对这一痛点,高效的数据去重清洗工具逐渐成为企业及个人用户的刚需。

核心功能:精准定位与灵活处理

一款合格的CSV去重工具,核心在于精准识别重复项并支持多样化清洗策略。例如,某工具通过字段组合对比技术,允许用户自定义关键列(如"订单号+用户ID"),避免单一字段判断的局限性。工具内置模糊匹配算法,可识别因大小写、空格或标点差异导致的"伪唯一值",例如将"NewYork"与"New York"自动归类为同一实体。

针对复杂场景,部分工具还支持正则表达式过滤。例如,清理手机号字段中的国际区号干扰(如"+86-"转为""),或统一日期格式("2023/08/01"与"01-Aug-2023"标准化为"20230801")。这种预处理能力显著提升了去重结果的准确性。

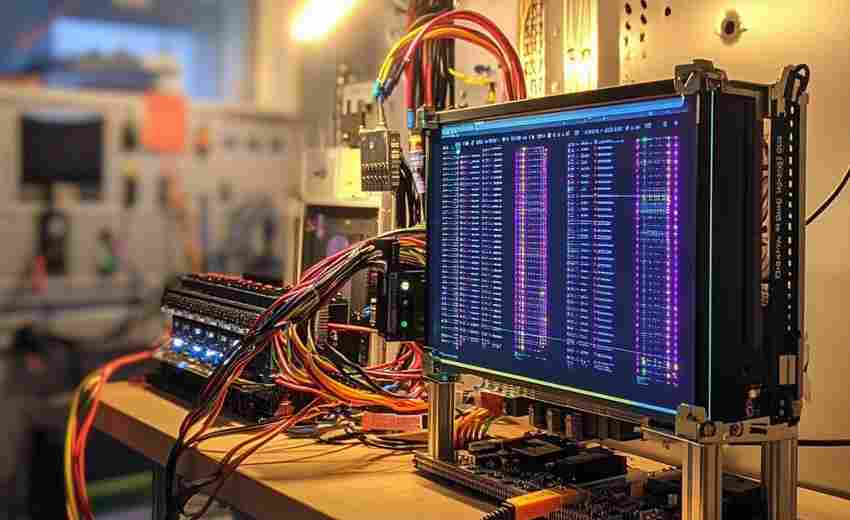

技术优势:效率与安全的平衡

面对百万级数据文件,传统Excel手动操作常因内存不足导致崩溃。专业工具则采用多线程处理机制,通过分块读取、内存优化等技术,将10GB文件的去重时间压缩至分钟级。某测试案例显示,对包含500万行的CSV文件进行全字段比对,开源工具OpenRefine耗时约32分钟,而定制化工具通过索引优化可将时间缩短至8分钟以内。

数据安全方面,优秀工具会提供"预检-备份-执行"三重防护。用户可先预览重复项分布,确认规则后自动生成原始文件备份,避免误操作风险。部分企业级产品还支持操作日志记录,满足审计需求。

应用场景:从科研到商业的覆盖

在电商领域,工具可快速清理促销活动产生的重复订单;金融机构利用其整合多系统导出的,消除身份重叠;科研人员则依赖其处理实验数据的多次采集结果。曾有用户反馈,使用某工具后,某零售品牌的库存SKU数量减少12%,采购成本测算误差率从5%降至0.7%。

工具兼容性亦影响使用范围。支持命令行调用的版本可嵌入自动化流程,图形化界面则降低非技术用户门槛。部分产品甚至提供API接口,与企业ERP或BI系统直接对接。

随着数据量的指数级增长,对清洗工具的需求已从"能用"转向"快、准、稳"。未来,集成机器学习模型预测重复规律、结合自然语言处理解析非结构化数据的功能,或将成为行业新方向。

- 上一篇:CSV文件批量预处理与统计分析工具

- 下一篇:CSV日志异常值自动标注工具

相关软件推荐

随机软件推荐

支持代理切换的网页敏感词实时监测工具

互联网内容监管需求日益增长的环境下,网页敏感词监测工具逐步成为政企单位的标配系统。近期市场出现的某款支...

招聘数据分行业词频对比分析工具

在招聘市场信息爆炸的背景下,企业常面临海量岗位描述数据难以提炼核心需求的痛点。一款针对招聘数据的分行业...

音频文件静音检测标记工具

在音视频内容创作领域,音频文件的后期处理往往是耗时费力的环节,尤其是需要精准定位静音片段时。传统的人工...

本地文件搜索与快速定位工具

在信息爆炸的数字化时代,每位电脑用户都可能遭遇这样的困境:明明记得某份文档存在硬盘里,却在层层文件夹中...

文本文件内容统计工具(统计行数-单词数-字符数)

在信息爆炸的数字时代,文字工作者常需要快速掌握文档的基础数据特征。某款基于命令行的文本统计工具悄然成为...

利用beautifulsoup的网页内容抓取器

互联网时代,数据采集已成为技术人员的必修课。在众多网页解析工具中,BeautifulSoup凭借简洁的语法和强大的容错能...

基于CSV文件的批量数据清洗与格式化工具

在数据处理领域,CSV格式文件因结构简单、兼容性强,常被用作数据传输与存储的载体。原始数据往往存在冗余、格...

Tkinter版密码管理器(AES加密存储)

现代生活中密码管理已成为刚需。市面上虽有不少商业密码管理工具,但数据隐私始终是用户的核心顾虑。近期在技...

开始菜单项目分类管理器

整理开始菜单的崩溃时刻,每位Windows用户都经历过。工作文档与游戏启动器混作一团,专业软件淹没在临时下载的压...

批量去除图片背景工具(简单抠图)

在数字图像处理领域,去除背景是许多设计师、电商从业者和普通用户的刚需。面对海量图片处理需求时,传统手动...

实时文件夹变化监控与容量预警工具

现代办公场景中,数据量的激增常导致存储空间失控。某运维团队曾因日志文件未及时清理,导致服务器宕机4小时,...

文本连续重复子串统计器

在数据处理领域,重复信息的识别与分析常成为关键挑战。例如,在文本压缩、代码优化或基因序列比对等场景中,...

古籍文本情感倾向分析工具

传统典籍研究领域长期面临着情感分析的空白区。以《史记》为例,司马迁在"李将军列传"中埋藏的情感线索,究竟是...

批量图片格式转换脚本(PNG-JPG转换)

现代数字内容创作中,PNG与JPG格式的图片占据着绝对主流地位。专业摄影师常遇到客户临时要求变更图片格式的情况...

网络速度实时监测与记录器

在数字化场景日益复杂的今天,网络稳定性已成为企业运营和个人用户体验的核心命脉。一台能够实时追踪网络速度...

网页加载时间性能测试器

互联网时代,打开网页超过3秒就有53%的用户选择离开。这种用户行为倒逼着开发者重视网页加载速度,而专业测试工...

启动项注册表键权限继承修复器

在计算机系统维护过程中,注册表权限问题常导致关键程序无法正常启动。某款专注于修复注册表启动项权限继承异...

命令行密码安全评分检测器

在网络安全领域,密码强度的评估是基础却不可忽视的环节。一款名为 PassSecCheck 的命令行工具近期在开发者社区引发...

带图形界面的ASCII艺术字生成器

深夜两点半的设计师林深盯着屏幕,咖啡杯底凝固的褐色液体倒映着光标闪烁。他刚在开源社区发现一款名为ArtChar的...

批量ZIP文件加密与解密工具

在数字化文件管理过程中,数据安全始终是核心痛点。面对需要同时处理数十个甚至上百个压缩文件的企业用户或技...

图片文字擦除工具(智能修复+背景填充)

日常修图时,常会遇到需要去除图片中多余文字的困扰。传统方法需要反复使用印章工具手动修补,既耗费时间又容...

密码管理器(AES加密存储)

输入第十三次相似的密码依然显示错误,手机验证码收件箱堆满临时登录凭证,这种场景在数字生活中早已司空见惯...

翻译项目术语提取分析工具

在全球化背景下,翻译项目复杂度持续攀升,术语管理直接影响翻译效率与质量。针对这一需求,术语提取分析工具...

大数据量CSV文件分块转JSON批处理工具

凌晨三点钟的开发部办公室,服务器机箱的嗡鸣声格外刺耳。李工盯着屏幕上第37次报错的内存溢出提示,手中的咖啡...

CSV文件大小智能分割工具(按行-体积)

在数据密集型行业中,CSV文件因其通用性成为数据交换的标配格式。随着数据量膨胀,动辄数GB的单一文件常导致传输...

Python定时自动导出书签备份脚本

痛点场景 浏览器收藏夹突然丢失的经历困扰过不少人。某次系统崩溃后,用户小张发现三年积累的600多个技术文档链...

单词本背诵与抽卡工具

地铁摇晃的车厢里,年轻白领从口袋摸出印着"ephemeral"的卡片,背面淡蓝墨迹标注着"短暂"的字样。纸质特有的毛糙触...

屏幕定时截图工具(计划任务实现)

清晨的办公室,技术主管李明盯着监控大屏上跳动的服务器数据,突然想起上月某次系统崩溃因缺乏现场截图导致复...

系统进程管理工具(显示和终止进程)

在操作系统运行过程中,后台进程的实时监控与管理直接影响系统性能与稳定性。无论是排查程序卡顿、释放资源,...

TTS电子书转有声书自动分章节工具

深夜台灯下翻开电子书的读者,通勤路上戴着耳机的上班族,渴望获取知识却视力受限的群体——当文字遇见声音,...

文件哈希值生成工具(支持MD5-SHA1算法)

安装完体积超过3GB的工程文件后,屏幕突然弹出"文件可能已损坏"的提示。这个困扰无数用户的常见问题,如今通过开...

PyFilesystem2-统一文件系统接口

在数据存储介质爆炸式增长的今天,开发者经常需要面对本地磁盘、对象存储、内存文件系统等不同类型的存储系统...

文件内容差异批量对比工具(输出差异报告)

在信息爆炸的数字化时代,开发者、运维团队或文案编辑常面临同一类问题:如何在短时间内精准识别多个文件之间...

单词背诵抽卡程序

翻开单词书的瞬间,困意总会准时袭来——这种场景外语学习者再熟悉不过。传统背诵方法依赖机械重复,大脑很快...

网络路由跳数分析工具

互联网数据包传输就像一场接力赛,每个路由器都是赛道上的交接点。网络工程师常被这样的问题困扰:跨国视频会...

登录记录时间线可视化工具

数字化时代,用户登录行为数据如同散落的拼图碎片。如何快速定位异常登录、回溯安全事件轨迹,成为企业安全运...

JSON与XML格式互转批量处理工具

在数据交换与系统集成的开发场景中,JSON与XML作为两种主流结构化数据格式,常因业务需求需频繁转换。传统手动逐...

基于规则的日志文件自动分析器

在IT运维、网络安全或系统开发领域,日志文件的分析效率直接影响故障排查的进度。传统的手动筛查不仅耗时,还容...

用户自定义指标监控配置工具

企业数字化转型浪潮下,数据监控体系正面临根本性变革。传统监控工具预设的CPU、内存等基础指标,在电商大促流...

邮件自动分类器(基于关键词过滤)

在信息爆炸的数字化时代,企业邮箱日均处理量突破百封已成常态。某互联网公司运维部曾做过统计:人工处理每封...