自动化robots.txt规则优化建议工具

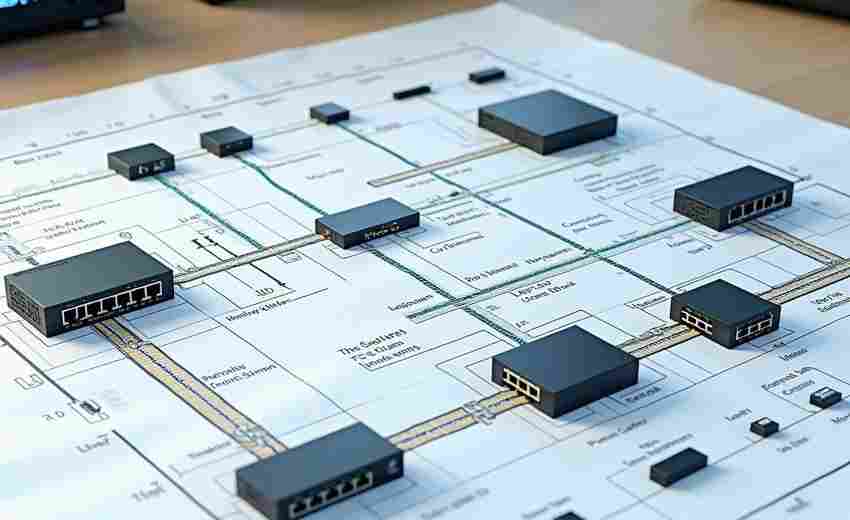

在搜索引擎优化领域,robots.txt文件如同交通信号灯般控制着网络爬虫的访问路径。某跨国电商平台的技术团队曾发现,其日均200万次的无效爬虫请求中,有38%源于robots.txt配置不当。这个发现直接催生了新一代自动化规则优化工具的研发需求。

这类工具的核心在于动态解析引擎,通过模拟主流搜索引擎爬虫的抓取逻辑,自动识别网站结构中的敏感区域。当某新闻门户网站启用该工具后,系统在12小时内扫描出17处存在风险的目录路径,包括本应屏蔽的临时稿件存储区。更值得注意的是,工具内置的冲突检测模块能够预判多条规则间的逻辑矛盾,某汽车论坛曾因此避免了对产品库目录的意外屏蔽。

智能推荐算法会根据网站类型自动适配最佳实践方案。例如,工具为在线教育平台生成的规则会优先开放课程目录,而对用户个人中心则实施梯度访问限制。动态更新功能确保规则库每周同步Google、Bing等搜索引擎的最新抓取政策,某跨境电商网站通过此功能及时调整了欧盟分站的多语言页面索引策略。

在技术架构层面,这类工具普遍采用双重验证机制。某工具在内部测试阶段曾成功拦截某爬虫程序对API接口的异常遍历请求,同时保持对正常产品页面的索引效率。日志分析模块提供的可视化报表,帮助某旅游平台发现其酒店详情页存在重复爬取问题,直接降低服务器负载21%。

数据安全防护机制采用分权管理模式,确保规则修改必须通过双重验证。某金融机构使用的版本甚至集成了爬虫指纹识别技术,可自动区分常规搜索引擎与恶意数据采集程序。部分工具开始整合机器学习模型,通过分析历史访问日志预测未来可能出现的爬虫行为模式。

- 上一篇:自动化PPT演示点击播放工具

- 下一篇:自动化Windows壁纸定时更换程序

相关软件推荐

随机软件推荐

办公文档自动重命名工具(按日期-关键词)

办公室里最常听到的抱怨之一:"上周的合同存哪儿了?""财务部要的报表怎么有三个版本?"杂乱无章的文件命名正在...

进程流量消耗阈值自定义提醒器

电脑或手机后台程序偷跑流量,是许多用户都遇到过的问题。下载软件时突然弹出流量告急提醒,追查原因才发现是...

文件压缩包(ZIP-RAR)批量解压工具

在数字化办公场景中,文件压缩包已成为跨平台传输的标配载体。当项目文档、设计素材或数据报表以数百个ZIP/RA件...

局域网广播天气信息推送工具

清晨六点,某工业园区的广播系统准时启动。不同于传统通知播报,控制室电脑自动将气象台实时数据转化为语音,...

简易绘图板工具(支持保存为PNG格式)

在数字创作领域,一款名为"SketchPad Pro"的轻量级绘图软件近期在设计师群体中引发关注。这款仅占用32MB内存的工具,...

局域网聊天记录自动保存分析工具

随着企业数字化进程加速,内部通讯软件产生的数据量呈指数级增长。某跨国科技公司2023年内部审计报告显示,其技...

批量修改服务器用户密码管理器

在多服务器集群运维场景中,管理员常面临密码集中管理的技术挑战。某互联网公司曾因未及时更新某边缘服务器密...

SQLite设备配置模板批量部署工具

在物联网与工业自动化场景中,设备配置管理直接影响着项目实施效率。某科技团队研发的SQLite设备配置模板批量部...

学生成绩表关联分析与统计工具

教育场景中,成绩数据蕴藏着大量可挖掘的信息。传统人工统计难以发现学科间的潜在关联,更无法精准定位教学薄...

专辑封面自动下载与嵌入工具

音乐爱好者与数字内容创作者常面临一个共同痛点:如何快速为本地音乐文件匹配并嵌入高质量的专辑封面。手动搜...

简易论坛帖子监控通知器

互联网时代,信息更新速度远超人工处理极限。某游戏论坛连续三天讨论外挂的帖子突破千条,版主直到用户大规模...

开机音效自定义修改工具

当电子设备逐渐成为生活的一部分,开机音效早已超越功能提示的范畴。对于追求个性化的用户而言,默认的"滴"声或...

音乐播放列表管理器(ID3标签)

对于音乐爱好者来说,本地曲库的混乱程度堪比一场灾难。文件名乱码、专辑信息丢失、歌手分类错乱……这些问题...

简易端口扫描与开放服务检测器(多线程扫描)

网络运维工作中,端口扫描是摸清资产底数的常规操作。传统单线程扫描器面对C段地址段时动辄需要数小时,这在云...

日志错误信息正则聚合统计工具

数字时代产生的日志数据呈现指数级增长趋势,某电商平台单日产生的服务器日志就超过2TB规模。面对海量日志中的...

图像颜色提取工具(生成调色板)

打开手机相册里随手拍的夕阳时,你是否好奇晚霞的渐变色谱如何转化为设计素材?某电商团队曾用故宫红墙的影像...

IP地理位置伪装检测文件保护工具

在数字化办公场景中,数据安全与访问权限控制的重要性日益凸显。近期,一款专注于 IP地理位置伪装检测 与 文件保...

字体单位换算工具(磅-像素-毫米)

在数字设计领域,字体单位换算常被视为一项基础却容易踩坑的工作。无论是印刷品、网页界面还是移动端应用,设...

网站登录状态自动检测器

在数字化场景中,用户频繁登录各类网站时,常会遇到登录状态异常的问题。例如,操作过程中因登录失效被迫中断...

简易文本笔记管理系统(基于TXT文件存储)

在信息过载的时代,许多人依赖电子笔记管理碎片化知识,但复杂的软件常伴随卡顿、格式混乱或隐私风险。一种基...

基于命令行的音乐播放器(播放本地文件)

在图形界面统治数字世界的今天,有人依然执着于在黑色终端窗口里敲击命令。当月光透过百叶窗投射在机械键盘上...

多格式文件类型转换器(基于魔术字节验证)

在数字化办公场景中,文件格式转换需求呈几何级增长。某技术团队近期推出的FileMagic Converter工具,凭借魔术字节(...

扫描件自动旋转摆正工具

许多人在处理扫描文件时都遇到过这样的烦恼:手动调整歪斜的图片既费时又难以对齐,尤其是批量处理会议纪要或...

基于Django的设备管理Web门户

医疗设备的全生命周期管理历来是医院资产管理中的难点。某三甲医院信息科负责人张工最近带领团队完成了院内设...

目录结构树生成工具(输出为文本)

Tree 是一款经典的目录树生成工具,预装在多数Linux发行版和macOS系统中。其核心功能是通过递归算法扫描指定路径,...

多语言串口调试助手(GUI版)

在嵌入式开发、工业控制或物联网设备调试中,串口通信是最基础的交互方式之一。传统的命令行调试工具虽然功能...

基于Pandas的JSON数据格式转换工具

JSON作为轻量级数据交换格式,在Web开发和数据存储领域应用广泛。但面对复杂嵌套结构或海量数据时,传统文本编辑...

专辑曲目顺序验证器

在数字音乐时代,专辑的完整性和艺术表达往往被忽视。许多听众习惯于点击「随机播放」,但创作者和制作团队却...

网络爬虫数据抓取工具(静态页面版)

数据抓取工具正成为企业及开发者获取公开信息的效率利器。针对静态页面的爬虫工具因其技术门槛低、适配性强等...

电子书数学公式渲染工具

数字阅读时代,数学公式的呈现始终是电子书制作的技术痛点。传统文档转换过程中,复杂公式经常出现符号错位、...

Pillow开发的九宫格图片切割工具

在社交媒体盛行的当下,九宫格拼图成为用户分享长图、创意设计的热门形式。传统手动裁剪不仅效率低,还容易出...

键盘操作记录分析器(带热力图功能)

屏幕右下角闪烁的红色光点逐渐汇聚成密集区域,程序员小林盯着热力图中那片刺眼的"高频误触区",终于找到自己编...

自动生成统计图表工具(matplotlib前端)

数据可视化是现代数据分析不可或缺的环节,而Matplotlib作为Python生态中最经典的绘图库,凭借其灵活性与功能深度,...

备份文件内容增量查重工具

数据备份如同现代人的数字保险箱,但反复存储的冗余文件往往让硬盘空间不堪重负。某互联网公司运维团队曾发现...

批量重命名电子书文件元信息

在数字阅读时代,电子书文件名混乱、元信息缺失或错误的问题困扰着许多读者。一本文件名标注为「未命名_1.epub」...

多客户端文件传输工具(支持断点续传)

在数字化协作日益普及的今天,跨设备、跨平台文件传输已成为高频刚需。传统传输方式如邮件附件、U盘拷贝或单一...

桌面便签自动保存工具(Tkinter界面)

在快节奏的工作和学习场景中,随手记录灵感的需求无处不在。传统便签工具往往需要用户手动点击保存按钮,一旦...

密码安全知识测试问卷系统

在数字化时代,密码安全成为个人与企业数据防护的第一道防线。多数用户对密码安全的理解仍停留在"复杂度越高越...

会议内容关键词实时协作编辑与共享网络图工具

在信息爆炸的会议场景中,如何快速捕捉核心观点并实现团队高效协作,一直是职场人的痛点。传统文档记录方式往...

Markdown标签云生成分析工具

当数据可视化遇上轻量创作:Markdown标签云工具深度解析 在信息爆炸的时代,如何将冗杂的文本数据转化为直观的视...