网页爬虫(抓取指定页面文本内容)

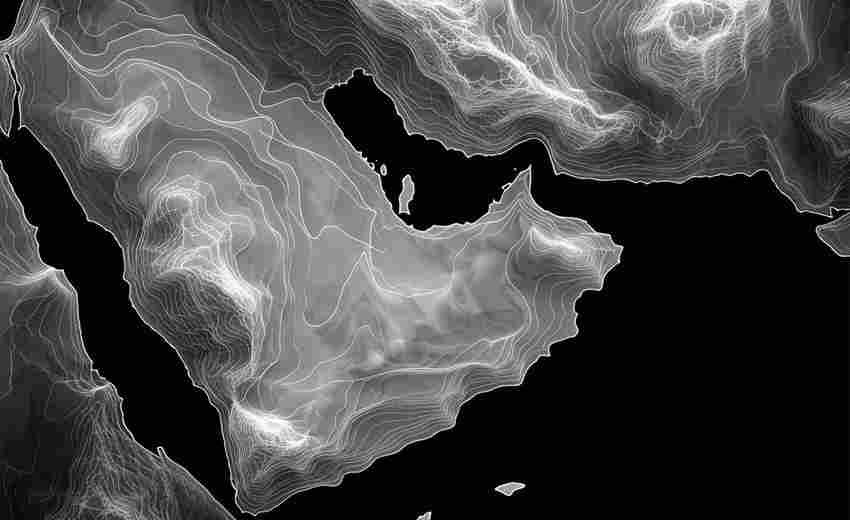

网络数据采集技术早已渗透到日常工作的各个环节,其中网页文本抓取作为基础功能,支撑着市场调研、舆情监控、学术研究等场景。面对海量网页信息,如何高效获取目标文本成为技术团队必须解决的问题。市面上常见的工具有Python的Requests库、Scrapy框架,以及Node.js的Puppeteer等,它们各自具备独特的技术特性。

Requests与BeautifulSoup的组合常被用于静态页面抓取。这个技术方案通过发送HTTP请求获取网页源码,再配合解析库提取特定标签内的文本。开发者在处理新闻门户或企业官网时,往往只需十余行代码就能完成基础采集任务。但遇到动态加载的页面时,这种方案容易获取到不完整的DOM结构。

Scrapy框架适合中大型采集项目。其内置的异步处理机制支持并发请求,自动化的URL去重和增量抓取功能,在处理电商平台商品详情页这类结构化数据时表现突出。配置文件与爬虫逻辑分离的设计,让工程化部署变得简单,但学习曲线相对陡峭的问题客观存在。

针对JavaScript渲染的网页,Puppeteer这类无头浏览器工具展现出独特优势。通过完整模拟浏览器环境,能够获取到动态加载后的最终DOM树。在抓取单页应用(SPA)或需要执行交互操作才能显示的内容时,该方案的成功率明显高于传统方法,不过资源消耗量会成倍增加。

数据清洗环节往往被低估重要性。正则表达式配合XPath组成的过滤体系,能有效剔除广告代码、无关注释等噪声数据。某些特殊场景需要处理编码转换问题,比如网页声明为GBK编码但实际使用UTF-8的情况,这时候自动检测编码库就变得尤为重要。

网络请求频率控制直接影响抓取稳定性。设置随机间隔时间(2-5秒)配合IP代理轮换,可以规避多数基础反爬机制。对于Cloudflare等高级防护系统,可能需要引入浏览器指纹模拟技术才能突破封锁。

- 上一篇:网页爬虫链接检测器(检查失效链接)

- 下一篇:网页版单位转换计算器

相关软件推荐

随机软件推荐

直播带货商品销量实时监控面板

凌晨三点的直播间依然人声鼎沸,某美妆品牌的运营负责人盯着后台突然飙升的曲线图,立即调整了库存调配方案。...

系统声音控制器(分应用调节)

当视频会议中突然弹出广告音效,当深夜追剧遭遇游戏音效突袭,多数人选择匆忙点击全局静音键。这种"一刀切"的操...

网络速度测试工具(Ping-下载测速)

现代人对网速的敏感程度远超想象。当视频缓冲圈转个不停,游戏延迟标红时,人们本能地打开测速网站。但多数用...

TXT小说阅读器(章节导航+书签)

当代数字阅读场景中,TXT格式小说因体积小、兼容性强占据主流地位。针对大容量文本文件的深度阅读需求,具备智...

翻译进度实时可视化面板

王总监,法语组还有3章没处理!""德文术语库同步延迟了!"某游戏公司的本地化会议室内,项目经理李然盯着密密麻...

简易BMI指数计算器(健康评估)

身高体重指数(BMI)作为国际通用的健康评估指标,已成为现代人快速了解自身体质的基础工具。通过数学公式将身...

简易待办事项管理工具(桌面提醒)

现代生活节奏加快,任务管理成为刚需。一款轻量、免安装的桌面待办事项工具,能帮助用户快速整理碎片化事务,...

多线程文件分类整理图形化工具

桌面堆积着数千份工作文档,设计师小周在项目收尾阶段陷入混乱。同事推荐的「SwiftSort Pro」让他半信半疑地启动了...

TXT文件行重复项清理器

日常办公中,经常遇到需要处理文本文件的场景。当面对动辄数万行的日志文件、用户数据或调研报告时,重复内容...

中英文翻译词典查询工具

中英文翻译词典查询工具近年持续迭代,功能边界不断突破。从最初的基础词库匹配到如今融合AI技术,这类工具已发...

网络请求模拟工具(POST-GET调试)

调试接口对于开发者而言就像厨子试菜,每个参数都是决定菜品成败的调味料。市面上一款名为PostPro的工具正成为...

图像滤镜应用工具(灰度、反色处理)

清晨的阳光透过百叶窗斜射在电脑屏幕上,设计师小张正在反复调整一组产品图。当他点击"灰度滤镜"时,原本色彩鲜...

Matplotlib生成的文件大小分布柱状图工具

在服务器运维和存储优化的实际工作中,技术人员经常需要分析海量文件的体积分布特征。某开源社区近期推出的文...

文件关联设置管理器

当系统弹出「无法打开此文件」的弹窗时 ,多数用户会选择随机安装各类解码器,或是反复点击属性面板手动修改后...

自定义铃声的会议休息提醒器

午后的会议室里,PPT仍在循环播放,咖啡杯早已见底却无人起身。某科技公司产品总监张林习惯性点开手机里的倒计...

简易注册表清理工具(安全项扫描)

Windows注册表如同操作系统的神经中枢,存储着软硬件配置的核心数据。随着使用时间增长,残留的无效注册项可能导...

利用scrapy框架的分布式爬虫系统

互联网数据指数级增长的今天,传统单机爬虫常面临IP封禁、效率瓶颈等问题。某电商平台技术团队曾遭遇日均千万级...

文件元数据分析提取器

在数字信息爆炸的时代,每份文档、图片或视频都携带隐藏的"身份证"——元数据。这些信息如同文件的"基因图谱",...

批量网页上传图片自动压缩工具

在数字化内容爆发式增长的今天,网页运营者常面临图片上传效率低、服务器负载过高的难题。手动逐张压缩图片不...

局域网设备SMB共享目录扫描器

办公环境中常出现这样的场景:行政部门共享的工资表模板突然消失,研发部门的项目文档意外出现在访客电脑中,...

网站静态资源打包工具

在网页加载速度直接影响用户留存率的今天,静态资源打包工具已成为前端工程师的必备利器。这类工具通过自动化...

代码注释自动生成器(.py-.java)

在苏州某科技公司的研发部,工程师张明面对两千行未注释的Python遗产代码皱起眉头。当他尝试使用CodeNoteX工具时,...

3D 渲染临时文件自动回收工具

在数字内容创作领域,3D渲染生成的临时文件往往成为存储空间的隐形杀手。一次高精度建模可能产生数百GB的缓存数...

多用户系统进程监控权限管理工具

在复杂的多用户操作环境中,如何高效管理进程权限、防范越权操作,一直是系统管理员面临的挑战。针对这一需求...

文件版本管理工具(本地备份历史)

日常工作中误删重要文件、找不到历史版本的经历困扰着很多人。本地文件版本管理工具如同数字世界的时光机,能...

迁移过程中密码过期策略处理工具

企业IT系统迁移过程中,密码策略的衔接处理往往成为容易被忽视的隐患环节。传统的手工迁移方式不仅耗时费力,更...

基于天气的户外摄影光线建议工具

清晨五点,山间雾气未散,摄影师陈岩打开手机里的天气分析工具。实时数据跳动着:湿度82%,能见度500米,日出时...

PDF表单字段批量清除工具

日常工作中常遇到PDF表单需要重复利用的情况。手动逐个删除表单字段不仅效率低下,还容易产生遗漏。专业开发者...

桌面便签贴纸工具(透明窗体)

启动软件后桌面会浮现半透明色块,如同在显示器表面覆盖了真实的便利贴。这款仅12MB的桌面便签工具支持Windows全系...

视频片段自动剪辑与拼接工具

在短视频日均播放量突破千亿的时代,内容创作者常面临这样的困境:手机里堆满的素材需要耗费数小时筛选,复杂...

窗口化注册表快捷访问工具

Windows注册表作为操作系统的核心数据库,长期困扰着普通用户与技术人员。传统regedit编辑器需要精确记忆路径,操作...

批量音频文件元数据编辑器

音乐收藏量突破四位数后,手动整理音频信息逐渐成为折磨。某位独立音乐人曾自嘲,为三百首原创作品添加专辑信...

简易PDF合并-分割工具(拖拽操作支持)

市面上一款名为QuickPDF的桌面工具近期引发关注。这款不足20MB的绿色软件无需安装即可运行,其极简设计风格与高效...

IP地址与ASN信息联合查询工具

在网络安全与数据分析领域,IP地址与ASN(自治系统号)的关联查询正成为专业人员不可或缺的基础能力。某款创新型...

网络爬虫抓取指定网站标题和链接的脚本

在互联网时代,数据抓取工具已成为市场调研、舆情监控等领域的重要助手。基于Python开发的网络爬虫脚本因其灵活...

简易电子商务商品管理系统

打开笔记本电脑,某淘宝店主陈婷正在核对库存数据。三天前新上的春装套装突然冲上店铺热销榜,但后台显示的库...

带图形界面的ASCII艺术字生成器

深夜两点半的设计师林深盯着屏幕,咖啡杯底凝固的褐色液体倒映着光标闪烁。他刚在开源社区发现一款名为ArtChar的...

压缩包密码字典破解工具(基础版)

深夜的电脑屏幕前,急促敲击键盘的手指突然停住——半年前加密的工作文档静静躺在D盘角落,密码却像被橡皮擦抹...

智能生成组织结构图工具

智能生成组织结构图工具:让企业管理更直观 在企业管理中,组织结构图是梳理部门关系、明确岗位职责的重要工具...

日志文件关键字分析器(正则表达式匹配)

在数据中心机房此起彼伏的报警声中,运维工程师李明正对着屏幕上海量的日志文件发愁。直到他输入一行正则表达...