实际测试发现,对中文网页添加字体编码检测模块(如`chardet`)能减少30%以上的乱码问题。当遇到JSONP格式数据时,需用`json`模块二次解析,必要时手动清理非常规转义字符。

四、典型应用场景示例

1. 舆情监控:抓取社交媒体内容结合情感分析模型

2. 学术研究:批量获取期刊论文摘要构建知识图谱

3. 竞品分析:监测电商平台商品价格波动

4. SEO优化:定期爬取搜索引擎结果页排名数据

存储环节建议采用增量抓取策略,通过记录`Last-Modified`或`ETag`字段避免重复下载。对于百万级数据量的项目,可将抓取结果导入Elasticsearch或ClickHouse进行实时检索分析。

法律风险始终是数据抓取的红线。2023年浙江某公司因突破封禁措施爬取短视频内容被判赔偿80万元的案例,提醒开发者在代码中必须加入合规校验模块。异步IO方案(如`aiohttp`)虽能提升吞吐量,但需谨慎控制并发量,避免对目标服务器造成拒绝服务攻击。

- 上一篇:网页正文与侧边栏内容自动分割工具

- 下一篇:网页正文内容朗读转换器

相关软件推荐

JWT令牌Payload内容可视化解析器

发布日期: 2025-03-25 11:53:01

一串形如`eyJhbGciOiJIUzI1NiIsInR5cCI6IkpXVCJ9.eyJzdWIiOiIxMjM0NTY3ODkwIiwibmFtZSI6IkpvaG4gRG9lIiwiaWF0IjoxN...

随机软件推荐

游戏玩家行为分析工具

在竞争激烈的游戏行业,如何精准把握玩家行为成为产品突围的关键。一套成熟的游戏玩家行为分析工具,正逐渐成...

PyQt数据库字段加密迁移工具

随着数据安全法规的日益严格,数据库敏感字段加密成为企业合规的重要环节。在此背景下,基于PyQt框架开发的数据...

日志文件按设备类型自动分类器

在企业级IT运维场景中,日志文件的管理效率直接影响故障排查与系统优化的速度。传统人工分类方式存在耗时长、错...

网络文件同步备份工具

窗外的雨点敲打着玻璃,李然盯着电脑屏幕弹出的"硬盘损坏"提示,手指微微发凉。这个月第三次发生的存储故障,让...

基于控制台的文本差异高亮对比工具

在软件开发与系统运维领域,文本差异比对是高频且刚需的操作。当开发者需要确认代码版本迭代细节,或是运维人...

使用PyPDF2实现的PDF文档合并分割工具

纸质文件堆积如山的办公桌上,财务小王正为合并二十份季度报表发愁。隔壁工位的程序员老张默默敲了几行代码,...

基于Tkinter的简易待办事项管理桌面应用

烈日炎炎的工作日下午,程序员老张盯着满屏的代码叹了口气。便利贴、手机备忘录、办公软件提醒同时弹窗,零散...

局域网设备在线状态监控器

现代办公场景中,局域网设备数量激增已成为普遍现象。打印机频繁断连、会议系统突发故障、安防摄像头离线报警...

特定时间段汇率波动归因分析工具

全球外汇市场的波动始终牵动着投资者、企业和政策制定者的神经。汇率的涨跌看似随机,但其背后往往隐藏着复杂...

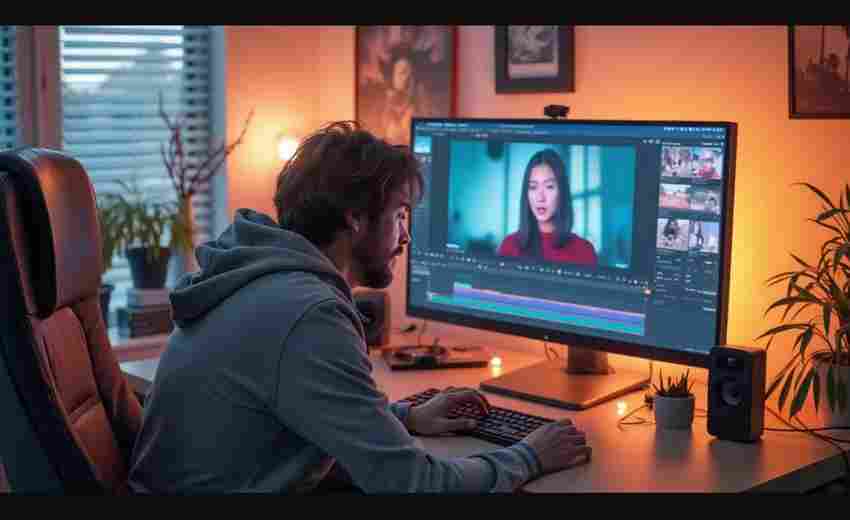

简易视频会议自动转录工具

远程协作成为常态的今天,线上会议的信息留存常让职场人头疼。某科技团队近期推出的"智录会议通"软件,凭借其独...

批量压缩图片质量工具(优化存储空间)

现代数字设备的存储空间总是不够用,手机相册里堆积的旅行照、工作中积累的设计素材、电商平台上传的产品图…...

游戏资源包重复文件优化器

在游戏开发过程中,资源包的臃肿问题长期困扰着开发者。贴图、音频、动画等文件随着版本迭代不断积累,重复内...

简易贪吃蛇小游戏带计分功能

屏幕上的像素点快速移动,蛇身随着方向键的操控灵活转向,经典游戏机制在数字世界焕发新生。一款集成计分功能...

简易画图工具(线条-形状绘制)

当数字绘画门槛日渐降低,一款轻量级绘图工具依然在设计师群体中保持着不可替代的地位。这类工具舍弃了复杂的...

维修工单模板批量生成工具

在设备密集型的制造业、物业管理或连锁服务业中,维修工单的生成效率直接影响着运维响应速度。某科技公司开发...

系统日志关键词报警推送工具

深夜的机房警报声此起彼伏,运维工程师李明紧盯着屏幕上滚动的日志数据,试图从海量信息中捕捉服务器异常的蛛...

文件同步工具(双向比较修改时间)

办公室电脑里的项目文档刚保存五分钟,家中笔记本的同名文件却在三小时前更新过——这种场景下,依靠人工记忆...

系统进程监控与简易任务管理器

在计算机日常运维中,系统进程监控工具与任务管理器如同技术人员的"听诊器"。这类软件不仅能实时反映系统运行状...

混合文档内容自动标签生成器

纸质合同与电子表格混放在同一个文件夹,会议录音夹杂在项目PPT中间,这种场景在办公环境中屡见不鲜。某跨国企...

文件内容加密替换工具(AES)

在数字化信息爆炸的时代,文件内容的安全性成为个人和企业共同关注的焦点。AES(高级加密标准)作为全球公认的...

日志关键词正则表达式生成器

在运维、数据分析或安全监测领域,日志文件的分析效率直接决定问题排查的速度。传统人工编写正则表达式的方式...

PDF文件批量转换灰度模式工具

纸质文件印刷场景中常出现彩色元素干扰阅读的问题,某设计院出图员王敏每周需处理上百份施工图文件,将标注色...

Base64与ASCII码对照表生成器

在数据处理领域,编码转换始终是开发者的高频需求。Base64与ASCII码对照表生成器作为一款实用工具,正在改变程序员...

简易俄罗斯方块游戏(PyGame版)

俄罗斯方块作为经典益智游戏,其规则简单却充满挑战性。利用PyGame框架开发该游戏,既能体验游戏开发的核心逻辑...

跨文件敏感信息过滤清理工具

互联网企业服务器上堆积着数百万份历史文档,运维团队突然接到安全审计通知。技术主管老张盯着屏幕上密密麻麻...

可配置参数的二维码生成解析器

二维码早已融入日常生活的毛细血管。无论是餐厅点餐、文件传输还是广告宣传,黑白方块的背后承载着高效的信息...

网站HTTP状态监控工具

互联网服务稳定性直接影响用户体验与商业转化。当服务器出现异常状态码时,如何快速定位问题成为运维团队的核...

桌面宠物互动程序

现代人面对屏幕的时间越来越长,办公桌上除了文件和水杯,似乎总缺了点生气。桌面宠物互动程序的出现,恰好填...

支持文件属性保留的Windows专用备份器

数据备份工具在Windows生态中早已不是新鲜事物,但多数产品仅停留在文件内容复制的层面。当用户需要迁移工程文件...

音频格式转换与合并组合工具

数字化时代音频文件处理需求日益增长。从学生整理课堂录音到音乐爱好者剪辑作品,普通用户常面临格式不兼容、...

基于CSV的会议日程安排管理系统

在数字化转型浪潮下,会议管理效率直接影响组织运转效能。某科技企业行政部曾因会议冲突导致产品发布会延误,...

CSV文件编码批量转换工具

日常办公中,经常遇到CSV文件打开出现乱码的情况。这种情况多由编码格式不兼容导致——当文件采用GBK、Big5等区域...

MySQL订单数据分页查询优化器

电商平台凌晨三点的主数据库监控大屏突然闪烁红色警报,某促销活动的订单查询接口响应时间突破10秒阈值。DBA团队...

自动化robots.txt规则优化建议工具

在搜索引擎优化领域,robots.txt文件如同交通信号灯般控制着网络爬虫的访问路径。某跨国电商平台的技术团队曾发现...

文本文件关键词搜索工具(正则匹配)

在信息爆炸的数字化时代,电脑硬盘里堆积的各类文档常常让人陷入检索困境。某互联网公司技术总监曾向团队展示...

批量压缩文件为ZIP工具

日常工作中处理海量文件时,传统压缩软件常显力不从心。某广告公司设计部曾因未及时发送3GB素材包错过竞标,暴...

系统服务管理命令行工具

在Linux与Windows两大操作系统中,系统服务管理始终是运维人员和开发者的高频操作场景。面对守护进程异常、服务依...

网页快捷书签管理工具

网页快捷书签管理工具:效率党的桌面革命 浏览器收藏夹的原始形态,似乎从互联网诞生起就没太大变化——用户把...

使用SMTP协议实现的批量邮件自动发送工具

在数字化沟通场景中,邮件依然是企业与用户建立联系的重要渠道。针对需要高频触达多用户的场景,基于SMTP协议开...

多账号Cookie文件管理器

互联网账号早已渗透到现代生活的每个角落。普通用户平均持有7个平台账号,电商运营者常需管理数十个店铺后台,...