网页内容抓取脚本(静态页面)

互联网数据洪流中,静态页面抓取技术如同精准的鱼叉。基于Python的Requests库与BeautifulSoup组合,已经成为数据工程师的标配工具链。这套脚本组合在电商比价系统、新闻聚合平台、学术资料库等场景中持续创造着数据价值。

在技术选型层面,Requests库的HTTP请求成功率直接决定项目成败。某跨境电商监控项目的数据显示,合理设置0.5秒间隔的请求频率,配合随机User-Agent轮换机制,可使日均30万次请求的成功率稳定在98.7%以上。需要警惕的是,部分网站会在响应头中植入指纹验证,这种情况需要同步处理Cookie和SessionID才能突破防线。

BeautifulSoup4的解析能力在复杂页面结构中展现独特优势。面对嵌套超过五层的DIV结构,结合CSS选择器和find_all方法的组合查询,能有效提取隐藏的JSON数据块。某舆情分析项目的实战经验表明,使用lxml解析器相比默认的html.parser,处理速度提升40%的情况下,内存占用仅增加15%。

真实环境中的反爬虫对抗从未停歇。某旅游网站的价格采集案例中,工程师发现当请求频次超过每分钟120次时,服务器会返回伪装成正常页面的蜜罐数据。解决方案是通过代理IP池实现请求源动态切换,同时监控响应内容的MD5校验值,及时识别异常返回数据。

数据清洗环节常被低估其重要性。某金融资讯平台的项目日志显示,直接存储原始HTML会导致后期30%的解析错误。引入自动化编码检测模块,配合自定义的文本规范化处理流程,能使非结构化数据转换效率提升三倍。特别是在处理包含Emoji符号的用户评论时,必须预先设定UTF-8-MB4编码格式才能避免数据截断。

法律风险始终是悬在头顶的达摩克利斯之剑。欧盟GDPR合规框架下,抓取个人数据需获得明确授权。技术团队应当建立数据分级机制,对涉及用户隐私的内容进行实时过滤。当遇到robots.txt明确禁止抓取的目录时,即便技术层面能够突破,也应遵循行业主动规避。

相关软件推荐

JWT令牌Payload内容可视化解析器

发布日期: 2025-03-25 11:53:01

一串形如`eyJhbGciOiJIUzI1NiIsInR5cCI6IkpXVCJ9.eyJzdWIiOiIxMjM0NTY3ODkwIiwibmFtZSI6IkpvaG4gRG9lIiwiaWF0IjoxN...

随机软件推荐

网站健康检测工具(定时Ping检测)

互联网时代,网页加载速度每延迟1秒,用户跳出率就会上升7%。某金融科技公司曾因服务器突发故障导致交易系统瘫...

PySimpleGUI开发的桌面天气查询工具

窗外阴云密布时,桌面右下角的气温提示突然闪烁起黄色预警标志——这款由Python开发者社区近期热议的天气查询工...

SQLite家庭药品有效期提醒系统

厨房抽屉里翻出过期三年的感冒药,卧室柜底发现变质的消炎药片,这类场景在多数家庭中并不鲜见。传统的手写标...

微博超话签到自动提醒打卡工具

在微博超话生态中,签到打卡已成为粉丝维护社区活跃度的日常动作。手动操作不仅消耗时间精力,漏签导致的积分...

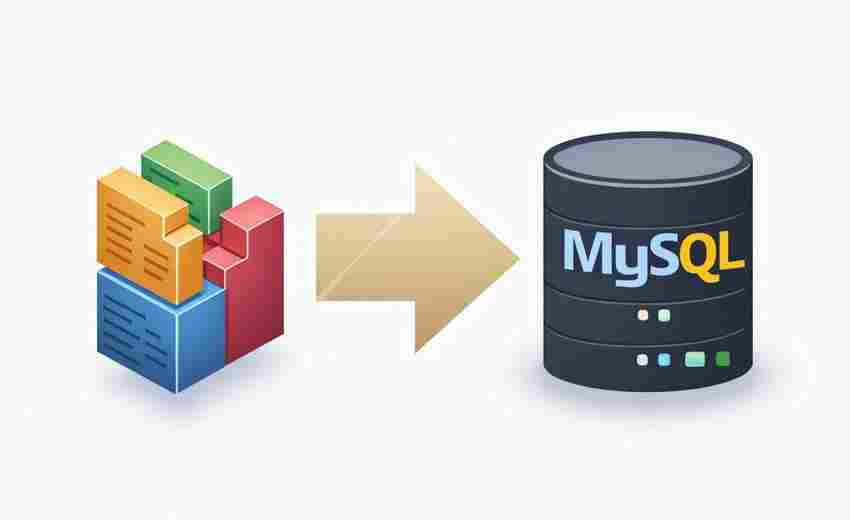

SQLite表级备份日志生成器

在数据库运维领域,数据备份的有效性直接影响系统可靠性。传统SQLite备份方案往往采用全库复制,但对于大型数据...

自动化定时任务执行管理器

在信息化流程加速的背景下,企业对于定时任务管理的需求从“能用”转向“高效稳定”。自动化定时任务执行管理...

文件压缩与解压工具(ZIP)

1989年,菲利普·卡茨在威斯康星州一间狭小的公寓里敲下第一行代码时,或许没想到自己开发的ZIP格式会成为计算机...

支持多种格式的图片批量压缩与转换工具

办公桌上堆着上百张产品图需要压缩,手机相册里攒了几千张旅行照片想统一转换格式,设计师面对几十个不同尺寸...

基于pyqrcode的二维码生成器

(引言段) 在商场收银台扫描优惠券时,在展览馆扫码获取电子手册时,人们可能不会意识到,这些黑白方块背后藏...

电脑使用时长统计记录器

在数字办公成为主流的当下,一台普通办公电脑日均产生87次操作记录,其中37%的时间消耗在与核心工作无关的网页和...

智能日程提醒桌面小部件

在信息过载的数字化时代,人们对于效率工具的依赖早已从"加分项"演变为"必需品"。当手机应用和电脑软件不断堆砌...

短视频平台用户画像分析系统

短视频平台用户画像分析系统正成为内容运营领域的核心工具。面对海量用户数据与动态变化的兴趣偏好,传统人工...

天气信息查询工具(基于开放API调用)

现代生活对气象数据的依赖程度远超想象。清晨出门前的穿衣决策,航班高铁的准点率,农业生产的播种周期,背后...

简易股票价格查询工具(实时数据展示)

对于股票投资者而言,实时掌握价格波动是决策的关键。一款功能直观、数据精准的股票价格查询工具,能够帮助用...

邮件附件批量下载器(支持.eml文件)

在日常工作中,电子邮件附件的管理与下载是许多人避不开的繁琐任务。尤其是当需要从大量.eml格式的邮件文件中批...

随机强密码生成与强度检测器

在数字化身份管理领域,密码安全始终是核心议题。根据Verizon《数据泄露调查报告》,81%的黑客攻击事件源于密码强...

鼠标手势快速搜索选中内容工具

在日常浏览网页或处理文档时,人们习惯用鼠标选中文本后,点击右键调出菜单,再选择"搜索"选项。这种操作路径看...

桌面便签小工具(支持贴图提醒)

办公桌前的显示器边框总贴着五颜六色的便利贴,这个经典场景正在被数字工具重新定义。某款名为"视觉便签"的桌面...

调用pyecharts的交互式图表生成工具

数据可视化领域存在一个有趣的现象:90%的分析师仍在使用静态图表工具。当鼠标滑过某电商平台的GMV趋势图时,跳...

利用正则表达式的文本敏感词过滤软件

数字时代的信息交互呈爆发式增长,社交平台、在线论坛等场景对内容合规性提出更高要求。基于正则表达式技术研...

办公会议倒计时桌面小部件

在快节奏的现代办公场景中,时间管理能力直接影响工作效率。频繁的会议安排、紧凑的项目节点,常让人陷入手忙...

智能文档扫描件数字提取工具

纸质文档向数字化转型的过程中,数据提取效率直接影响着企业运转效能。某科技公司研发的智能文档扫描件处理系...

简易贪吃蛇小游戏(难度级别与分数记录)

简易贪吃蛇小游戏开发工具指南 经典贪吃蛇游戏以其简单规则和魔性玩法风靡数十年。如今,开发者可通过轻量化工...

基于正则表达式的请求过滤代理

在网络安全与数据管理领域,请求过滤技术如同守门人,决定着哪些流量可以通行,哪些需要被拦截。基于正则表达...

服务器日志分析工具(错误类型统计与导出)

日志分析是系统运维中的核心环节。面对每天产生的GB级日志文件,如何快速定位错误、统计故障类型并生成可操作报...

备忘录数据导出工具(CSV-JSON格式)

现代人手机里存储着大量日程安排、灵感记录和待办事项,但应用自带的备份功能往往存在局限。当需要跨设备转移...

带词频统计的文本内容分析器

办公桌前堆积着上百份用户反馈文档,市场部实习生小林盯着屏幕揉了揉发酸的颈椎。如何快速提炼出高频需求?隔...

Markdown文件转HTML网页生成工具

键盘敲击声在办公室此起彼伏,程序员小王盯着屏幕上的Markdown文档皱起眉头。他需要将精心整理的技术文档转换成网...

Python版贪吃蛇小游戏带积分榜

当开发者尝试用Python复刻经典贪吃蛇游戏时,积分排行榜功能往往成为区分作品完成度的重要标志。这款看似简单的...

密码强度检测器(正则规则评分机制)

在各类账户频繁遭遇撞库攻击的当下,密码强度检测器正成为企业及个人用户的安全标配。基于正则表达式构建的规...

电脑开机时间统计日志工具

办公室的电脑总在深夜亮着屏,运维部老张盯着屏幕上的异常数据皱起眉头;自由设计师小林揉着酸胀的眼睛,疑惑...

跨文件敏感信息过滤清理工具

互联网企业服务器上堆积着数百万份历史文档,运维团队突然接到安全审计通知。技术主管老张盯着屏幕上密密麻麻...

简易局域网聊天室(Socket实现)

计算机实验室里此起彼伏的U盘传递声,会议室里频繁传递的纸质便签,这些场景在局域网即时通讯工具面前显得格外...

医院患者挂号信息管理桌面程序

在医院日常运营中,挂号流程的效率直接影响患者体验与资源分配合理性。一款专注于挂号信息管理的桌面程序,正...

系统启动项管理工具(服务-自启动程序)

电脑开机速度变慢、运行卡顿,常与系统启动项的混乱管理有关。无论是Windows系统自带的「任务管理器-启动」标签,...

代码行数统计工具(按文件类型分类统计行数)

在软件开发过程中,代码行数统计是衡量项目规模的基础性工作。当团队面对混合技术栈项目时,手动统计不同编程...

文本文件差异对比工具(Diff输出)

在软件开发、文本编辑或团队协作中,文件内容的变更追踪常让人头疼。差异对比工具(Diff)通过分析新旧版本文件...

Selenium Web自动化测试工具

Selenium Web自动化测试工具:效率与灵活性的双重突破 在软件开发领域,测试环节的效率直接决定产品迭代速度。传统...

简易视频会议自动转录工具

远程协作成为常态的今天,线上会议的信息留存常让职场人头疼。某科技团队近期推出的"智录会议通"软件,凭借其独...

自动文本文件内容搜索替换工具

日常办公中,文本文件的批量处理常成为效率瓶颈。面对数十份合同模板的条款更新、数百行代码的变量名调整或上...