网页内容抓取工具(基于requests库)

互联网时代,数据采集成为企业与开发者获取信息的重要途径。基于Python语言的requests库,因其简洁高效的特性,已成为网页内容抓取的首选工具。本文将从实际应用角度解析该工具的核心功能与使用技巧。

环境搭建与基础配置

安装requests库仅需执行`pip install requests`命令即可完成。建议配合虚拟环境使用以避免依赖冲突,通过`python -m venv env`创建隔离环境后激活使用。对于需要处理复杂HTML的场景,可结合BeautifulSoup或lxml库进行内容解析。

核心功能解析

1. GET请求处理

通过`requests.get(url)`即可完成基础请求,支持超时设置(timeout参数)防止程序阻塞。对于需要处理Cookies的网站,可通过Session对象保持会话状态:

```python

session = requests.Session

response = session.get(' params={'user':'test'})

```

2. 响应内容解析

response对象包含status_code、headers、text等属性。建议优先使用`response.content`获取字节数据,配合chardet库自动检测编码:

```python

import chardet

encoding = chardet.detect(response.content)['encoding']

text = response.content.decode(encoding)

```

3. POST请求构造

处理表单提交时,使用`data`参数传递字典类型数据。对于JSON格式的API请求,改用`json`参数自动序列化:

```python

requests.post(' json={'key':'value'})

```

4. 请求头定制

模拟浏览器请求头可有效降低被反爬机制拦截的概率。典型配置包含User-Agent、Accept-Language等字段:

```python

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64)'

requests.get(url, headers=headers)

```

异常处理机制

网络请求存在不可控因素,必须包含异常处理逻辑。requests库提供ConnectionError、Timeout等具体异常类型,推荐使用try-except结构:

```python

try:

response = requests.get(url, timeout=10)

response.raise_for_status

except requests.exceptions.HTTPError as err:

print(f"HTTP错误: {err}")

except requests.exceptions.Timeout:

print("请求超时")

```

实战应用场景

开发者需注意遵守网站的robots.txt协议,控制请求频率避免对目标服务器造成过大压力。对于复杂反爬策略的网站,可结合Selenium或Scrapy框架构建更健壮的采集系统。数据存储环节建议使用SQLAlchemy对接数据库,或直接输出为CSV/JSON格式文件。

相关软件推荐

随机软件推荐

屏幕使用时间统计Excel生成器

当代人日均面对电子屏幕超过8小时,注意力分散、效率低下成为普遍困扰。一款名为「屏幕使用时间统计Excel生成器...

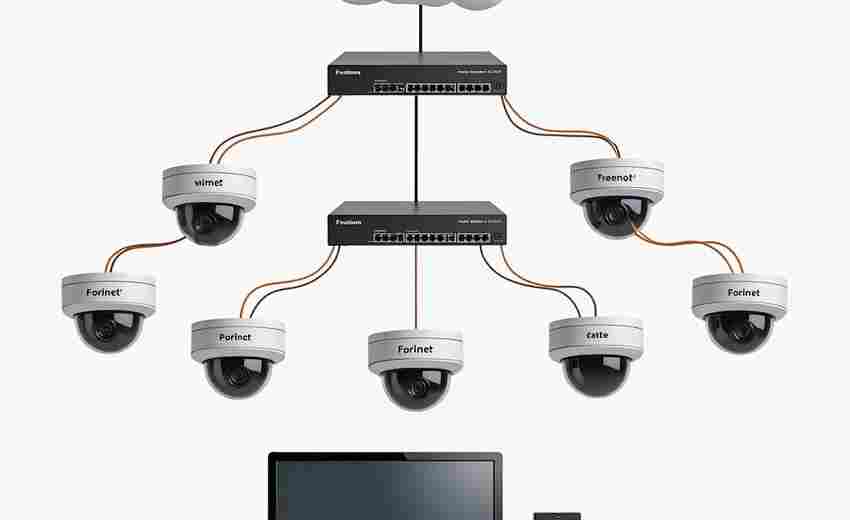

网络设备ARP表分析工具

在复杂的网络环境中,ARP表作为二层通信的核心枢纽,承载着IP地址与MAC地址的动态映射关系。传统的手工排查方式效...

电子书章节自动拆分与格式整理工具

纸质书籍的电子化进程中,格式混乱与结构无序始终是困扰阅读者的两大顽疾。一本电子书可能包含上千页未分段的...

医学影像DICOM元数据重命名工具

医学影像数据管理领域长期存在一个痛点:海量DICOM文件命名缺乏统一标准,导致影像检索效率低下。某三甲医院放射...

自动化电子表格报告生成器

在数据驱动的商业环境中,企业每天需要处理海量信息生成各类报表,传统手工操作不仅耗时耗力,且容易因人为疏...

字体文件云端同步工具(跨设备字体库管理)

在数字内容创作领域,字体文件的管理长期困扰着设计师、编辑及自媒体从业者。某广告公司设计总监张林曾遭遇过...

农历-公历转换工具(节假日标注)

翻开手机预装的日历软件,总感觉缺少某些熟悉的元素。当需要确认端午假期安排时,突然意识到现代数字工具与传...

批量图片格式转换脚本(PNG-JPG转换)

现代数字内容创作中,PNG与JPG格式的图片占据着绝对主流地位。专业摄影师常遇到客户临时要求变更图片格式的情况...

学术引用情感关联性检测工具

学术引用情感关联性检测工具近年来逐渐成为科研领域的热门辅助手段。该工具通过分析论文引用行为中的情感倾向...

系统日志循环归档压缩工具

日志管理是系统运维中容易被忽视但至关重要的环节。随着服务器运行时间增长,日志文件体积膨胀可能引发存储告...

局域网内简易聊天室(基于Socket)

互联网时代的信息传递离不开网络通信技术,对于开发者而言,掌握Socket编程如同厨师熟练运用刀具般重要。本文将...

网站页面内容定时抓取监控工具

互联网信息以秒级速度更新迭代,企业若想保持竞争力,必须掌握网站内容动态追踪的主动权。市场监测领域近期出...

简易电商价格追踪器(定时监控商品价格)

网购时最头疼的莫过于商品价格波动。上午刚下单的电器,下午突然降价200元;放进收藏夹半个月的化妆品,促销结...

长按语音备忘录记录器

实体按键在触控屏时代常被视为低效设计,但长按语音记录器的圆形金属按键颠覆了这种认知。当拇指自然搭在阳极...

语音博客转文字发布平台

在内容创作领域,语音博客(Podcast)因其便捷性和感染力持续走红,但纯音频形式的传播始终存在天然短板——无法...

手机键盘输入统计热力图生成器

手机键盘输入统计热力图生成器是一款针对触屏设备开发的实用工具。它通过捕捉用户日常打字行为的数据,自动生...

带行号显示的TXT转PDF生成器

凌晨三点的办公室,程序员李明反复核对屏幕上的代码片段。当他试图将调试记录发送给海外团队时,突然意识到没...

简易API接口测试工具

开发团队在日常工作中,常常需要验证接口是否符合预期。传统的手动测试方式效率低下,而市面上的专业工具又存...

电脑锁屏倒计时助手(自定义休息提醒)

午后三点半的办公室,显示器右下角突然浮现卡通企鹅的弹窗:"该起来活动颈椎啦!"这个画面或许很多人都有过共鸣...

Windows功能组件清理器

当Windows系统运行三年以上,许多用户都会发现开机时间从15秒逐渐延长到两分钟,C盘空间如同被黑洞吞噬般持续缩小...

实验室安全数据表(SDS)检索工具

实验室安全数据表(SDS)检索工具正在成为现代科研场景中不可或缺的辅助设备。这种工具的开发初衷源于实验室事...

批量图片重命名与元数据清除器

在数字内容爆炸的时代,用户设备中存储的图片数量呈指数级增长。无论是摄影师的专业图库,还是普通用户的日常...

TXT文件行号自动添加与移除工具

在办公场景或代码编写过程中,文本文件的行号管理常成为刚需。行号自动添加与移除工具正是为解决这一痛点而生...

简易CAD图纸查看器(DWG-DXF基础显示)

对于需要频繁处理工程图纸的设计师或施工方来说,传统CAD软件存在启动慢、操作复杂等问题。近期测试的这款国产...

简易屏幕截图工具(区域-全屏)

日常办公或学习场景中,屏幕截图的使用频率远超想象。根据第三方数据平台统计,普通职场人日均截图操作超过8次...

图片相似度快速比对工具(基于哈希算法)

一张商品图在不同平台重复出现超过50次,人工核对需要多久?某电商平台技术团队曾做过测试:10人小组花费8小时仅...

Python脚本实现的简易RSS阅读器

最近在整理个人信息流工具时,发现市面上的RSS阅读器普遍存在功能冗余的问题。尝试用Python写了个不到200行的脚本...

系统USB设备检测工具(厂商信息识别)

当USB设备接入电脑出现驱动异常时,技术人员总会掏出那个蓝色图标的小工具。这款USB设备检测工具在业内已积累十...

文字冒险游戏引擎(基于JSON剧本)

清晨的咖啡馆里,开发者老张正对着笔记本电脑皱眉。屏幕上的代码编辑器里,几十行JSON结构化数据正安静地躺在蓝...

网页内锚文本关键词分布统计工具

锚文本作为网页内部链接的核心元素,直接影响搜索引擎对页面主题的判断以及用户体验的优化。针对这一需求,网...

图片重复检测与低分辨率版本筛选器

办公桌上堆叠的纸质文件逐渐被数字文档取代时,硬盘里成千上万的图片文件正在成为新的管理难题。某款智能图片...

EXIF元数据关键词搜索工具

一张照片能传递的信息远不止画面本身。对于摄影师、调查人员或普通用户而言,隐藏在图像背后的EXIF元数据往往承...

简单密码强度检测与生成器

密码安全作为数字时代的第一道防线,其重要性常被低估。根据2023年全球网络安全报告显示,超过60%的数据泄露事件...

基于MongoDB的日志文档存储系统

灵活应对海量日志:MongoDB在文档存储中的实践价值 在当今数据驱动的技术场景中,日志管理系统的性能直接影响运维...

剪贴板历史记录管理工具(缓存最近内容)

工作文档与聊天窗口频繁切换时,你是否经历过「刚复制的内容被覆盖」的抓狂时刻?当PPT制作需要调用三天前的参...

PyAutoGUI实现的自动化鼠标点击工具

在现代办公与开发场景中,重复性鼠标操作消耗大量时间精力。PyAutoGUI作为一款Python第三方库,凭借简洁的接口和跨...

文件夹内容同步工具(自动对比差异并复制)

计算机存储空间从GB到TB的跨越式发展,催生了用户跨设备存储需求的指数级增长。普通用户手机相册存着3个G的露营...

多平台定时消息推送工具

在信息爆炸的数字化场景中,团队协作与信息触达的效率直接影响业务推进速度。多平台定时消息推送工具的出现,...

使用正则表达式的日志关键词提取器

在日常运维与数据分析中,日志文件常以海量、非结构化的形态出现。面对成百上千行的文本内容,人工逐行筛查不...

微博热搜关键词抓取与词云生成器

互联网时代,海量信息以秒速更迭。某科技团队推出的"微云洞察"系统,正成为舆情分析师与新媒体从业者的得力助手...