简易网络爬虫(基础页面抓取)

当互联网成为信息海洋的时代,手动收集网页数据就像用木桶舀海水般低效。网络爬虫作为自动化数据采集工具,正在改变人们获取信息的传统方式。这种技术通过编写程序代码,能够实现网页内容的批量抓取与结构化处理。

网络爬虫的工作原理其实不难理解,它主要通过模拟浏览器访问网页的行为。当程序发送HTTP请求到目标网站后,服务器会返回HTML格式的网页源代码。就像拼图游戏需要拆解零件,开发者会使用XPath或CSS选择器从HTML文档中提取特定的文本、链接或图片元素。对于动态加载的网页内容,则需要借助Selenium等工具控制浏览器内核进行渲染。

在Python生态中,requests库配合BeautifulSoup组件是入门级开发者的标配组合。通过十余行代码就能实现基本的网页抓取功能:发送GET请求获取网页源码,使用选择器定位目标数据,最后将结果存储为CSV文件或数据库记录。对于需要登录验证的网站,开发者可以通过维护Cookie会话或使用自动化测试工具突破访问限制。

电商价格监控是爬虫技术的典型应用场景。某数码产品经销商曾通过定时抓取竞品平台的商品信息,实现价格波动的实时预警。社交媒体数据采集则为品牌营销提供决策支持,某美妆品牌通过分析微博话题数据,成功预测了当季流行色系趋势。学术研究领域更是常见爬虫的踪迹,文献元数据抓取大大提升了研究者的资料收集效率。

数据采集的道德边界需要谨慎把握,访问频率控制应遵循网站robots.txt的指引。某知名论坛曾因未设置访问间隔,导致服务器过载引发法律纠纷。建议开发者设置合理的请求间隔,在User-Agent中标注联系方式以示善意。当遇到验证码防护时,优先考虑与网站方协商数据接口方案。

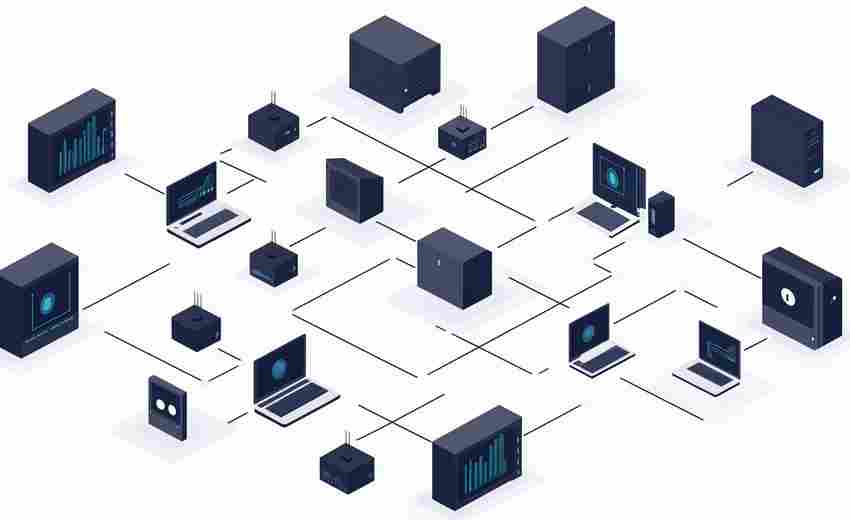

爬虫技术正从桌面端向云端集群演化,分布式架构大幅提升了采集效率。数据清洗环节开始融合NLP技术,智能去重算法能有效剔除无效信息。部分企业开始尝试结合OCR识别技术,突破图片验证码的防护机制。

数据确权争议持续发酵,欧盟《数字市场法案》明确爬取公开数据的合法性边界。国内司法实践中,合理使用原则逐渐成为裁判共识。机器学习模型训练对数据质量提出更高要求,结构化数据存储方案开始支持向量数据库技术。

- 上一篇:简易网络爬虫监控(自动保存抓取结果)

- 下一篇:简易网络爬虫(带反爬虫延迟)

相关软件推荐

随机软件推荐

配置文件敏感项检测与自动加密工具

在数字化进程加速的当下,配置文件作为各类系统运行的核心载体,往往隐藏着数据库密码、API密钥等高危敏感信息...

网络带宽使用率实时监控工具

网络带宽作为企业IT架构的血脉,其使用效率直接影响业务连续性。传统的人工巡检或脚本监控模式已无法应对突发流...

多用户协作式在线日历

现代职场中,时间管理效率直接影响团队生产力。传统日历工具常因信息孤岛、更新延迟等问题导致协作障碍,而多...

简易博客文章草稿编辑工具

文字工作者常陷入两难境地:灵感需要即刻捕捉,但传统写作软件往往功能臃肿。某款近期走红的草稿工具恰好填补...

多窗口参考图比对工具

在视觉信息处理领域,图像比对是设计师、科研人员与医疗工作者常面临的高频需求。传统的单窗口切换模式需反复...

PDF与Excel表格互转工具

数字化办公时代,纸质文档与电子表格的隔阂常让职场人头疼。当财务主管张薇凌晨三点还在手动录入PDF报表数据时...

文本编码-解码转换工具

在数字化信息爆炸的时代,文本编码与解码技术默默支撑着数据传输、存储和交换的底层逻辑。无论是网页中的特殊...

电脑屏幕截图工具(带标注功能)

工作场景中经常遇到这种情况:演示文档需要圈出数据重点,设计稿要标注修改意见,在线会议得实时标记屏幕内容...

视频片段自动剪辑与拼接工具

在短视频日均播放量突破千亿的时代,内容创作者常面临这样的困境:手机里堆满的素材需要耗费数小时筛选,复杂...

停车场车位占用异常监控工具

现代城市停车资源紧张,车位管理效率直接影响用户体验与运营成本。车位占用异常现象——例如车辆超时停放、非...

文件粉碎机(安全擦除防止数据恢复)

电子设备迭代速度越来越快,人们更换手机、电脑的频率远超二十年前。二手交易平台上,标注着"已恢复出厂设置...

终端版抽奖程序(名单文件支持)

办公室的灯光下,技术部小王正对着满屏的代码皱眉。行政部临时递来的年会抽奖需求,要求两小时内处理完三百多...

数字时钟带闹钟功能

清晨六点,窗外的天色尚未透亮,书桌上的方形设备准时亮起琥珀色柔光。伴随着渐强的鸟鸣声,睡眠监测系统感应...

基于命令行的密码管理器

在数字身份泛滥的时代,密码管理器的选择往往折射着使用者的技术偏好。对于习惯与黑色终端窗口打交道的人群来...

文件备份任务进度监控器

当企业服务器遭遇突发断电,自由职业者的设计稿因硬盘故障消失,家庭用户误删三年旅行照片…这些真实场景催生...

网站政务办理信息自动提交器

近年来,随着"互联网+政务服务"的深化推进,全国已有89%的市级政务大厅实现线上业务办理。但高频次、重复性的信...

城市PM2.5浓度变化面积图生成器

城市空气质量监测领域迎来一款创新工具。这款基于网页端运行的PM2.5浓度面积图生成器,借助地理信息系统与动态数...

电子书元数据批量修改工具(EPUB-MOBI)

现代数字阅读场景中,电子书元数据的准确性直接影响着书籍管理效率。当个人图书馆积累至千册规模时,常会遇到...

网页截图工具(整页截图保存功能)

滚动鼠标滚轮二十多下才能看完的网页,用普通截图工具需要手动拼接十几张图片——这个困扰互联网用户多年的痛...

音频格式转换与元数据编辑工具

在数字音频处理领域,格式转换与元数据编辑是两大刚需。面对市面上繁杂的工具,如何选择适合自己的解决方案?...

邮件阅读回执自动追踪统计工具

在日常工作中,邮件沟通占据重要地位。但发件人往往面临两大困扰:对方是否及时查看邮件?重要信息是否被有效...

会议纪要自动模板生成器(时间-参会人记录)

一场两小时的部门例会结束后,行政专员张婷对着录音笔和潦草的笔记皱起眉头。整理会议时间轴需要反复核对录音...

多进程CPU时间片分配热力图工具

现代操作系统的进程调度机制中,时间片分配策略直接影响着CPU资源的利用效率。对于开发者或系统优化人员而言,...

网页内容朗读器(文本转语音)

长时间盯着屏幕阅读,眼睛容易疲劳,注意力也容易分散。网页内容朗读器的出现,为这一痛点提供了解决方案。这...

外汇实时汇率对接物联网设备

跨境贸易与全球化供应链的快速发展,推动企业对外汇汇率数据的实时性需求持续上升。传统人工监控汇率的方式效...

个人月度支出分类环形图生成软件

在个人财务管理领域,手工记账与表格统计的繁琐常让用户半途而废。近期一款名为"支出光谱"的环形图生成工具,通...

多语言新闻摘要实时翻译工具

在全球信息爆炸的时代,跨语言新闻获取成为刚需。一款名为"GlobalFeed"的多语言新闻摘要实时翻译工具应运而生,其...

电脑锁屏倒计时助手(自定义休息提醒)

午后三点半的办公室,显示器右下角突然浮现卡通企鹅的弹窗:"该起来活动颈椎啦!"这个画面或许很多人都有过共鸣...

多国语言翻译器(Google API)

在孟加拉国达卡市的服装加工厂里,印度采购经理正通过移动端应用与德国客户核对订单细节。这个看似普通的商业...

基于Crontab的定时截图工具

窗外的阳光斜斜照进办公室,桌面右下角的系统托盘突然弹出提示框——"15:00截图任务已执行"。这是某企业技术部正...

简易计算器程序(Tkinter GUI)

在编程学习与日常工具开发中,图形用户界面(GUI)的设计往往是提升用户体验的重要环节。本文介绍一款基于Pyth...

查重结果置信度评估工具

在学术研究与内容创作领域,查重工具的普及极大提升了文本原创性审查的效率。传统查重系统仅提供重复率数值,...

电子邮件附件智能压缩管理器

在深圳某跨境电商公司的办公室里,行政主管李薇正盯着电脑屏幕皱眉——季度财报的PPT因包含大量图表导致附件体...

简易3D图形渲染器(OpenGL基础应用)

在三维数字内容创作领域,OpenGL始终保持着不可替代的地位。这款跨平台的图形API历经三十余年发展,其底层架构设...

Python实现TTS的代码错误提示语音化工具

调试代码时,视觉疲劳和重复性信息处理常让开发者效率骤降。针对这一痛点,基于Python的TTS(文本转语音)技术可...

PDF合并分割工具(页面操作)

日常办公中,纸质文件正逐步被PDF格式取代。这种跨平台兼容的电子文档虽便利,却常因无法直接编辑引发困扰。市...

智能家居设备状态记录仪(MQTT转CSV存储)

在智能家居系统运行过程中,设备状态数据的长期记录常面临技术瓶颈。传统方案存在数据分散、格式混乱等问题,...

抖音用户作品信息采集工具(API调用)

在短视频内容生态高度繁荣的当下,抖音平台日均产生超过10亿条互动数据。针对品牌方、研究机构及内容创作者对数...

基于SSH的服务器安全漏洞扫描助手

随着远程办公与云计算技术的普及,SSH协议因其加密特性成为服务器远程管理的标配工具。配置不当、密钥泄露、协...

算式练习工具(自动生成加减乘除题目)

数学计算能力是学习理科的基础,但枯燥的重复练习常让人失去耐心。算式练习工具的出现,让生成加减乘除题目变...