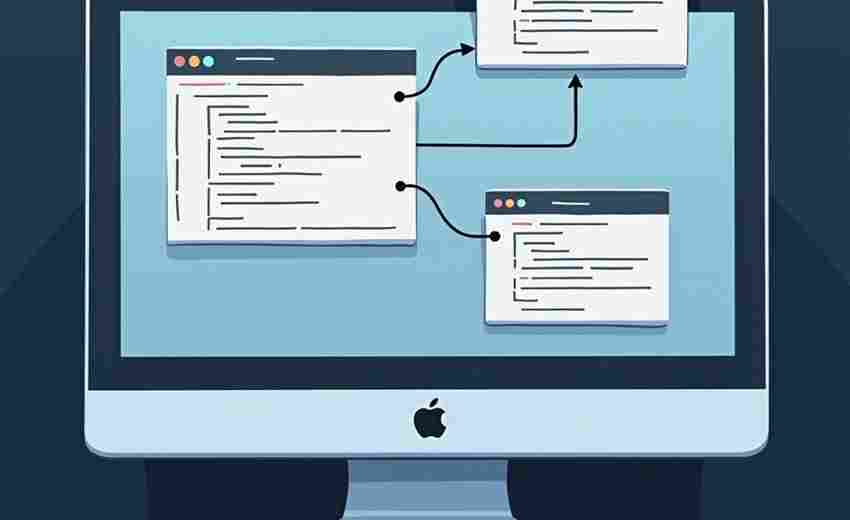

简易爬虫程序(抓取指定网页内容并保存为文本)

互联网时代,海量网页数据蕴藏着巨大价值。基于Python开发的网页抓取工具,通过20行左右的核心代码,就能实现指定网页内容的自动采集与存储。这种轻量级程序在合法合规前提下,能有效提升信息处理效率。

该工具主要依赖requests网络请求库与BeautifulSoup解析模块。requests组件模拟浏览器访问行为,向目标网址发送HTTP请求并获取响应内容,其超时参数可设定为15秒防止网络阻塞。BeautifulSoup通过标签选择器定位特定内容,支持CSS选择器和正则表达式混合使用,能精准提取标题、正文或表格数据。

实际应用中常见两种典型场景:新闻网站的文章批量存档需要循环处理分页链接,电商平台的价格监控则需定时抓取更新数据。某测试案例显示,配置合理的抓取程序可在1分钟内完成50个商品页面的信息采集,相比人工操作效率提升超过40倍。

核心代码结构分为三个部分:使用requests.get获取网页源码时,添加headers参数能模拟真实浏览器访问;soup.find方法定位目标元素时,结合try-except异常处理可避免因页面结构变化导致的程序中断;文件存储环节采用with open语句自动管理资源,编码参数设为utf-8确保中文正常显示。

当处理动态加载内容时,需改用selenium库控制浏览器内核。反爬虫机制较强的网站通常设置访问频率检测,合理设置3-5秒的随机延迟能降低被封禁风险。数据存储环节可扩展CSV或数据库格式,便于后续分析处理。

法律合规边界需严格遵守,抓取公开数据时避开个人信息等敏感字段。网站根目录下的robots.txt文件明确标注了禁止抓取的目录,程序开发阶段应优先读取该协议。部分平台采用异步加载技术,页面源码中并不直接包含目标数据,这种情况需要分析XHR请求获取真实数据接口。

- 上一篇:简易爬虫代理IP有效性验证器

- 下一篇:简易爬虫网页内容提取工具

相关软件推荐

简易屏幕取色器(RGB-HEX值显示与复制)

发布日期: 2025-03-21 13:05:00

鼠标悬停瞬间,网页导航栏的渐变蓝被精准捕获,RGB(67,133,235)与4385EB两组数值同步显示...

简易数据可视化工具(matplotlib实现)

发布日期: 2025-03-23 09:14:37

一、当数字遇上视觉 一位数据分析师曾调侃:"如果Excel是算盘,Matplotlib就是3D打印机。...

Tkinter画板程序(支持画笔颜色与粗细调整)

发布日期: 2025-04-05 11:04:30

对于刚接触图形界面编程的开发者而言,Tkinter作为Python内置的GUI工具包,一直是快速实...

随机软件推荐

农作物生长环境监测数据库

农业生产的精准化与智能化已成为现代农业发展的核心趋势。在这一背景下,农作物生长环境监测数据库应运而生,...

Windows功能组件清理器

当Windows系统运行三年以上,许多用户都会发现开机时间从15秒逐渐延长到两分钟,C盘空间如同被黑洞吞噬般持续缩小...

自动化微博热点抓取机器人

互联网时代的信息以秒速更迭,微博热搜榜作为全民话题风向标,时刻牵动着媒体从业者、品牌运营者的神经。传统...

本地天气预报工具(基于城市名称查询)

在快节奏的现代生活中,天气变化直接影响着出行安排、户外活动甚至工作决策。一款基于城市名称查询的本地天气...

批量去除图片背景并转换格式的透明化工具

在数字内容爆炸式增长的当下,图片处理已成为各行业的基础需求。对于需要频繁处理产品展示图的设计师、电商运...

局域网聊天记录自动保存分析工具

随着企业数字化进程加速,内部通讯软件产生的数据量呈指数级增长。某跨国科技公司2023年内部审计报告显示,其技...

定时任务执行监控与管理界面工具

在互联网公司的机房深处,无数定时任务如同精密钟表里的齿轮持续运转。某电商平台凌晨自动更新的库存数据,银...

扫描版PDF文字识别增强工具

扫描版PDF文件在数字化过程中常面临文字模糊、排版错位等痛点问题。针对这一需求,文字识别增强工具应运而生。...

桌面便签备忘录工具(基于Tkinter)

清晨阳光斜射进办公室的玻璃窗,程序员李明习惯性双击桌面上那个黄色图标——这是他用Python+Tkinter独立开发的桌面...

局域网设备路由表信息导出工具

路由表作为网络设备的核心数据载体,记录着数据包的传输路径与转发规则。在局域网管理中,快速获取并分析路由...

工业传感器数据转Excel预测分析工具

在工业制造领域,传感器实时采集的温湿度、压力、振动等数据是生产优化的核心依据。面对海量、碎片化的原始数...

键盘连击速度测试器

屏幕右下角跳动的数字从50涨到76,李明的手指在机械键盘上带起一片残影。作为《魔兽世界》职业玩家,他每周都会...

网络爬虫自动翻页抓取新闻聚合器

在信息爆炸的互联网环境中,新闻聚合平台需要持续获取时效性强、覆盖面广的内容资源。基于Python开发的SmartCrawl...

批量重命名办公文档工具(按规则命名)

当市场部小李面对电脑里三十多个"未命名报告.docx"时,手指悬停在F2键上迟迟无法落下。这个每月都会上演的场景,...

简易计算器(支持表达式解析和计算)

屏幕前的计算器总带着距离感。传统的按钮式设计需要反复切换界面,复杂的科学计算器更是堆砌着陌生符号。如今...

屏幕颜色拾取器(实时取色码)

在数字设计、摄影后期或网页开发领域,色彩是视觉表达的核心。屏幕颜色拾取器作为一款实时取色工具,能够帮助...

多格式图片拼接与分辨率统一工具

现代数字图像处理领域,跨平台协作与多源素材整合的需求日益增长。面对不同格式、尺寸的图片文件,专业人员常...

简易Excel数据批量清洗与格式转换工具

在日常办公中,Excel数据处理是高频需求,但面对海量数据时,重复的手动操作往往消耗大量时间。一款针对Excel设计...

自动化磁盘空间监控告警代理

现代企业数据量呈指数级增长,某电商平台曾因临时促销活动导致日志文件激增,存储空间在3小时内耗尽,直接造成...

桌面便签记事本小工具(Tkinter实现)

在信息碎片化的时代,快速记录灵感或待办事项成为刚需。一款基于Python Tkinter开发的桌面便签记事本工具,凭借其简...

批量生成二维码名片工具(带GUI)

深夜的办公室亮着最后一盏灯,市场部小王盯着电脑屏幕上密密麻麻的Excel表格叹气。300位参会嘉宾的名片信息亟待处...

数字时钟带闹钟功能

清晨六点,窗外的天色尚未透亮,书桌上的方形设备准时亮起琥珀色柔光。伴随着渐强的鸟鸣声,睡眠监测系统感应...

局域网群聊消息记录导出工具

在局域网办公场景中,即时通讯软件承载着大量关键对话。某能源公司曾因服务器故障导致三个月的工作沟通记录丢...

邮件发送频率限制监控与提醒工具

在邮件营销场景中,触发服务商的发送频率限制是企业常踩的雷区。某跨境电商公司曾因营销邮件超频发送,导致企...

社交媒体动态抓取工具(如Twitter RSS)

在信息爆炸的社交媒体时代,如何精准获取目标数据成为刚需。Twitter作为全球性舆论场,其动态抓取技术近年持续迭...

网络下载加速工具(多线程分片下载)

点击下载按钮后盯着进度条发呆的经历,几乎每个互联网用户都遭遇过。当单个下载线程遇到网络波动或服务器限速...

系统风扇转速动态曲线绘制工具

在硬件性能监控领域,风扇转速的动态变化直接关联设备的散热效率与运行稳定性。针对这一需求,系统风扇转速动...

温度转换结果TTS语音播报程序

在日常生活和科研场景中,温度单位的转换需求广泛存在。传统方式需要用户手动计算后查看屏幕结果,对于烹饪操...

设备资产管理二维码标签打印系统

设备资产管理二维码标签打印系统近年来已成为企业数字化转型的重要工具。该系统将物联网技术与传统资产管理相...

MP3音乐文件元数据编辑器

深夜整理音乐收藏时,突然发现某张专辑的发行年份标注错误,歌手名字拼写混乱,这种体验让强迫症患者如鲠在喉...

命令行版图片格式快速转换脚本

在数字内容处理领域,图片格式转换是高频需求。对于习惯命令行操作的用户,图形化工具往往显得笨重且低效。一...

终端版聊天室(局域网通信)

当图形界面统治现代计算机交互时,某些开发者开始逆向而行,在黑白终端里重建最原始的通信乐趣。这类运行在命...

股票分红数据收集分析工具

对于长期投资者而言,股票分红数据是衡量企业盈利能力和股东回报的重要指标。面对海量数据与动态变化的市场,...

基于Tkinter的本地文件管理器

在软件开发领域,高效管理本地文件的需求从未消退。对于需要快速浏览、操作本地资源的开发者或普通用户而言,...

基于时间戳的屏幕截图自动命名工具

在数字办公场景中,屏幕截图作为信息留存的重要方式,每天产生的图像文件常因命名混乱导致后期检索困难。某款...

文件夹大小统计与可视化工具(树状图)

当电脑存储空间亮起红灯时,多数人对着资源管理器的百分比条束手无策。系统自带的存储分析功能往往只能显示笼...

监控日志文件增长并发送邮件警报的守护程序

运维工程师最不愿在深夜接到的电话,往往来自突发的磁盘爆满告警。某中型电商平台曾因未及时处理Nginx日志暴增,...

网络爬虫抓取指定网站标题和链接的脚本

在互联网时代,数据抓取工具已成为市场调研、舆情监控等领域的重要助手。基于Python开发的网络爬虫脚本因其灵活...

文件属性批量修改工具(时间戳-只读属性设置)

日常办公场景中,常会遇到需要统一调整上百份文件属性的情况:财务部门需要锁定所有报表防止误删,摄影团队需...

飞镖比赛得分统计训练器

飞镖运动对精准度的要求近乎苛刻,职业选手的日常训练中,得分统计的精确性与反馈效率直接影响水平提升。传统...