学术机构科研产出统计爬虫

——以学术机构统计爬虫为例

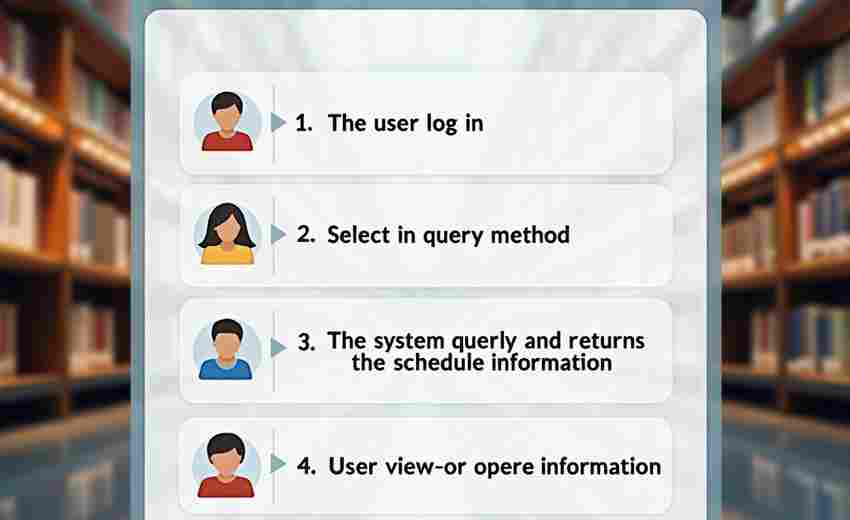

在科研管理与学术评价领域,如何高效获取多源异构的学术产出数据始终是核心问题。传统的人工收集模式受限于时间成本与数据维度,难以满足动态监测需求。在此背景下,基于网络爬虫技术的科研产出统计工具逐渐成为高校、智库及科研管理部门的重要辅助手段。

技术架构与核心功能

此类工具通常采用分布式爬虫框架,通过API接口与网页解析双通道获取数据。以Scopus、Web of Science等权威数据库为基础,同时覆盖高校官网、预印本平台等开放资源。系统内置的智能调度模块可动态调整采集频率,平衡数据完整性与反爬规避的关系。例如,针对Scopus数据库设计的增量采集算法,能够通过文献DOI特征码实现数据去重更新,较传统全量采集模式效率提升约40%。

数据清洗环节采用机器学习模型,重点解决机构名称歧义问题。北京大学(北京)与北京大学深圳研究院的文献混淆情况,通过地址字段分析与合作网络识别,准确率可达92%以上。统计维度支持定制化扩展,除常规的论文数量、影响因子外,还可整合专利引用、技术转化率等产业关联指标。

应用场景与合规边界

实际部署案例显示,某双一流高校科研处利用该工具后,年度学科评估数据准备周期由28人天缩短至6人天。工具生成的机构科研画像包含学科趋势热力图、国际合作网络拓扑图等可视化模块,为资源分配提供数据支撑。但需注意,部分商业数据库的爬取存在法律风险,工具通常内置合规检测模块,实时比对Robots协议与用户授权范围。

技术团队建议用户重点关注数据安全机制。成熟的系统会采用沙箱隔离技术,确保原始数据不外流,统计结果仅保留聚合值。随着人工智能技术的发展,未来可能实现跨语言文献的自动语义分析,但当前仍受限于非结构化数据的处理能力。

硬件配置方面,中小型机构采用云服务器集群即可满足需求,但涉及百万级文献处理时,建议配置独立GPU加速卡提升自然语言处理效率。开源社区已有部分替代方案,但商业版本在数据接口稳定性与更新时效性上更具优势。

数据隐私保护条例的全球差异可能影响跨国学术机构的使用,开发者通常提供区域化部署方案应对此问题。在学术层面,工具设计需避免引入非公开的同行评审信息,保持科研评价的客观性基础。

- 上一篇:学术期刊影响因子查询系统

- 下一篇:学术论文PDF元数据提取与整理工具

相关软件推荐

随机软件推荐

系统风扇转速控制脚本工具

现代计算机硬件性能提升的散热需求日益增长。传统主板BIOS提供的固定温控策略常无法满足个性化需求,尤其在多任...

屏幕取色器工具(支持HEX-RGB转换)

在数字设计领域,颜色从来不只是视觉符号。一个精准的色值往往决定着界面质感、品牌调性甚至用户行为。当设计...

定时文件备份到外接硬盘工具

定时文件备份工具:让数据安全更省心 对于依赖电子设备工作或生活的人来说,文件备份的重要性不言而喻。手动备...

设备兼容GIF调色板优化器

在移动端与桌面端内容呈现差异化的今天,GIF动图因其兼容性强、传播便捷的特性,依然是社交媒体、产品演示等场...

知乎问答数据采集与关键词提取工具

知乎作为国内最具影响力的知识分享平台,日均活跃用户超5000万,沉淀了海量的问答数据。如何高效挖掘这座信息金...

压缩包密码暴力破解工具

在数字化信息存储场景中,加密压缩包常被用于保护敏感数据。当用户遗忘密码或需要恢复他人遗留文件时,基于暴...

系统定时关机工具(支持倒计时和计划任务)

深夜赶工的程序员、挂机下载的电影爱好者、习惯通宵开机的游戏玩家,总会在某些时刻需要定时关机功能。市面上...

颜色心理学搭配推荐器

在视觉主导的信息时代,颜色不仅传递美感,更成为情绪与场景的无声语言。颜色心理学搭配推荐器的诞生,为设计...

简易数据可视化工具(matplotlib实现)

一、当数字遇上视觉 一位数据分析师曾调侃:"如果Excel是算盘,Matplotlib就是3D打印机。"在Python生态中,这个诞生于...

动漫资源站更新监控爬虫

对于动漫爱好者来说,追番最头疼的问题莫过于错过更新。传统的手动刷新不仅效率低下,还容易遗漏关键信息。近...

PDF文档内容提取器

数字办公环境中,PDF文件因格式稳定性成为主流文档载体,但内容提取难题始终困扰着用户群体。传统复制粘贴操作...

法律文书特定条款快速定位提取器

法律从业者常常面临海量文书处理的难题。一份动辄数百页的合同文本中,想要快速找到违约金条款或争议解决条款...

内存泄漏自动检测报警小工具

凌晨三点的办公室,程序员老张盯着屏幕里缓慢膨胀的进程内存曲线,咖啡杯在指尖转了三圈。这已经是本周第三次...

文件压缩-解压工具(ZIP-RAR格式支持)

在数字化办公场景中,文件压缩工具早已成为效率工作的标配。面对海量数据存储或跨平台传输需求,能够灵活处理...

算式练习工具(自动生成加减乘除题目)

数学计算能力是学习理科的基础,但枯燥的重复练习常让人失去耐心。算式练习工具的出现,让生成加减乘除题目变...

网络IP地址归属地快速查询工具

互联网的匿名性让许多场景需要快速定位网络行为的来源。无论是判断电商平台上的异地登录风险,还是追踪游戏服...

多语言输入法切换提示工具

在全球化的工作场景中,多语言输入需求日益频繁。无论是跨国协作、多语种文档撰写,还是日常沟通中的即时翻译...

个人健康数据可视化仪表盘

早晨七点,手机自动生成睡眠质量报告,运动手环推送静息心率趋势图,智能体脂秤同步更新人体成分分析。当海量...

图像直方图均衡化自动处理器

在数字图像处理领域,直方图均衡化是一项基础且关键的技术,用于增强图像的对比度与细节表现。传统的手动操作...

带计算历史版本对比的差异分析器

在软件开发和文档协作领域,版本迭代带来的变更管理始终是痛点。传统差异对比工具仅能展示文本层面的修改,而...

文件加密-解密工具

在数据泄露频发的当下,个人隐私与商业机密的安全防护成为刚需。文件加密工具作为主动防御手段,通过算法将普...

文件差异对比工具(diff)

1974年诞生的Unix工具diff,至今仍在代码审查、文档校对等领域发挥核心作用。当程序员面对Git提交记录中数千行变动...

Twitter关键词实时监测工具

信息爆炸时代,社交媒体平台每分钟产生数万条动态。当某国际品牌新品发布会因突发舆情陷入被动时,其公关团队...

系统温度异常报警通知工具

在数字化基础设施规模持续扩大的背景下,服务器的稳定运行直接影响企业业务连续性。传统人工巡检方式难以应对...

桌面便签与剪贴板历史管理工具

碎片化信息处理一直是职场人的痛点。临时会议纪要、项目进度备忘、跨平台资料收集……信息稍纵即逝,传统方式...

简易Markdown文档编辑器(支持实时预览)

在信息爆炸的时代,文字工作者常陷于排版困境。有人坚持用传统办公软件反复调整格式,也有人被迫在专业代码编...

多服务器日志同步分析器

在分布式架构普及的当下,一台服务器宕机、一个接口超时、一次流量突增,都可能涉及数十台甚至上百台服务器日...

日志文件行内容长度分布分析工具

运维工程师张磊盯着屏幕上持续刷新的日志文件,密密麻麻的字符流中突然出现数行超过2000字节的记录。这种异常现...

多层级目录图片缩略图生成器

在数字化信息爆炸的今天,图片管理已成为设计师、摄影师、电商从业者等群体的刚需。面对动辄上千张图片的文件...

Tkinter版密码管理器(AES加密存储)

现代生活中密码管理已成为刚需。市面上虽有不少商业密码管理工具,但数据隐私始终是用户的核心顾虑。近期在技...

网络端口扫描工具(TCP端口可用性检测)

夜深人静,某企业安全工程师王工盯着屏幕上跳动的扫描进度条。他正在使用TCP端口扫描工具排查内网服务器异常,...

Pygame制作的记忆力翻牌小游戏

午后阳光斜照在咖啡杯边缘,屏幕上的纸牌图案随着鼠标点击翻转又合上。这种经典的记忆力翻牌游戏,如今通过P...

颜色拾取器(屏幕实时取色)

电脑屏幕里藏着1677万种颜色,但人类肉眼只能识别约1000种色相。当设计师盯着渐变色卡发愁,摄影师为色彩偏差焦头...

批量生成缩略图创建工具

在数字媒体内容爆炸的时代,图片处理效率成为设计师、运营人员和摄影工作者的核心痛点。面对动辄上百张的高清...

多平台(Win-Mac-Linux)时间同步工具

在分布式办公、远程协作成为常态的今天,设备之间的时间误差可能导致数据错乱、会议迟到甚至系统故障。对于使...

文件权限与属性保留同步工具

在服务器运维或跨设备协作场景中,文件同步工具的可靠性往往被简化为"能否完整传输数据"。真实环境中存在一个常...

微博粉丝发帖时间热度折线图工具

在信息爆炸的社交媒体时代,微博用户每天面对海量内容时,常会陷入困惑:什么时候发布动态更容易被关注?某明...

批量提取PDF文本内容工具(多语言OCR支持)

数字化办公场景中,纸质文件电子化已成刚需。某款支持多语言OCR的PDF文本提取工具,凭借其核心技术突破了传统文...

基于Pandas的数据统计分析助手

在大数据时代,数据分析的效率与准确性直接影响业务决策的质量。Pandas作为Python生态中广受欢迎的数据分析库,凭...

系统调用跟踪资源关联器

在Linux系统运维领域,工程师们经常面对这样的困境:某个进程突然异常消耗大量CPU资源,或是某个服务莫名其妙地占...