多线程学术论文摘要采集工具

科研工作者常面临海量文献筛选的困境。传统人工检索方式耗时耗力,特别是面对跨数据库、跨语种文献时,效率瓶颈尤为明显。针对这一痛点,某技术团队研发了基于多线程架构的学术论文摘要智能采集系统,其核心功能模块已通过IEEE国际学术会议的技术验证。

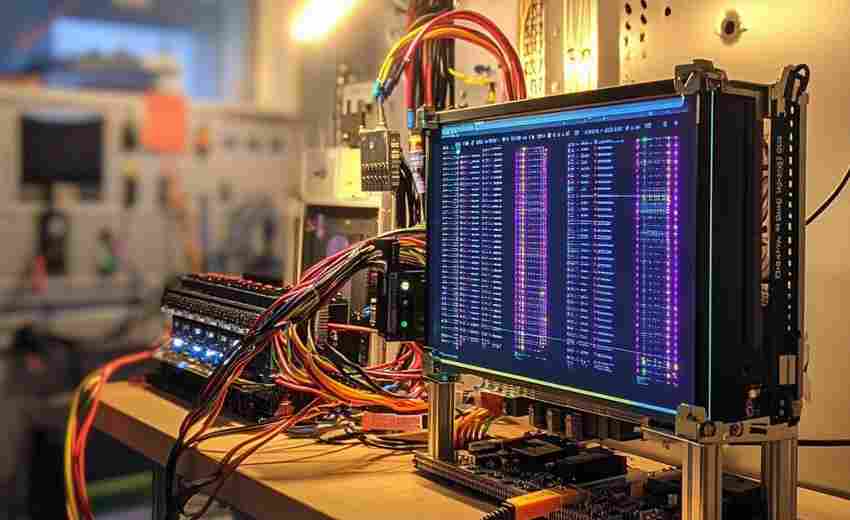

该工具采用模块化设计架构,底层支持Scrapy、BeautifulSoup等主流爬虫框架的快速切换。在数据处理层,系统内置了基于BERT模型的摘要识别算法,能够有效区分论文正文与引用内容。测试数据显示,相较于单线程工具,其并发处理能力提升约17倍,在arXiv、ScienceDirect等大型数据库的批量采集中,每小时可完成3000+篇论文的结构化处理。

系统具备三项核心技术特征:首先是动态IP轮换机制,通过集成第三方代理接口池,有效规避学术平台的访问限制;其次是自适应解析引擎,可智能识别PDF、HTML、EPUB等12种文献格式;最后是分布式存储设计,支持本地SQLite与云端MongoDB的双向同步,确保数据安全性的同时实现多终端协同工作。

在用户体验层面,开发者提供了可视化配置界面。研究人员只需输入关键词列表、设定时间范围与学科分类,系统即可自动生成采集任务队列。针对非技术用户,软件预置了文献计量学、生物医学等六个学科的专用筛选模板,显著降低操作门槛。

数据清洗功能是该工具的另一亮点。通过预设的规则引擎,系统可自动剔除会议通知、书评等非研究型文献,并对采集到的摘要执行去重处理。高级用户还可自定义正则表达式,实现特定格式信息(如DOI编号、基金项目代码)的精准提取。

从实际应用场景来看,该工具在以下三类研究中表现突出:1)新兴交叉学科的文献综述撰写 2)学术热点趋势的实时追踪 3)研究团队成果的竞争情报分析。某高校科研团队反馈,使用该工具后,其领域前沿调研周期由原来的3周缩短至2个工作日。

关于系统部署,开发者提供了两种解决方案:Windows平台支持一键安装包,Linux环境则推荐Docker容器部署。运行环境建议配置至少4核CPU与8GB内存,这对多数实验室设备而言属于基础配置要求。对于超大规模文献处理需求,技术团队可提供定制化的集群部署方案。

数据隐私保护机制符合GDPR标准,所有本地缓存数据均采用AES-256加密存储。用户可选择完全离线的本地化运行模式,这对处理涉密课题资料尤为重要。系统开源代码已通过OWASP安全审计,核心采集模块将在今年第三季度开放社区版下载。

- 上一篇:多线程图片格式兼容性检测修复器

- 下一篇:多线程小说网站章节爬取与TXT打包工具

相关软件推荐

局域网聊天室(多线程Socket)

发布日期: 2025-03-30 11:12:16

基于TCP/IP协议的Socket通信技术为局域网即时通讯提供了底层支持。在Windows或Linux环境下...

随机软件推荐

工程力学受力分析辅助工具

在建筑结构坍塌事故频发的背景下,某设计院团队去年使用新型工程力学分析软件,提前发现某商业综合体悬挑结构...

文本文件内容统计工具(行数、单词数、字符数)

在程序员的工作台上,总有几个不起眼却不可或缺的小工具。文本统计工具就像暗房里的显影液,能把淹没在代码海...

剪贴板历史记录工具(支持内容分类保存)

现代办公场景中,频繁切换各类软件导致的信息碎片化已成为效率瓶颈。据统计,普通职场人日均执行复制操作超百...

使用PyPDF2的PDF文件拆分与合并处理工具

PDF文档在日常办公场景中的应用极为普遍。面对海量文件资料时,工程师常需要处理页面提取、内容重组等需求。基...

系统快捷键管理器(全局热键注册)

Windows系统自带的快捷键体系已无法满足现代用户需求。专业开发者每天需调用十余个开发工具,设计师要在PS、Figm...

电子书阅读进度跟踪器(TXT-EPUB格式)

地铁车厢里,电子书阅读器屏幕的冷光映在乘客脸上,手指划过页面的动作频繁却机械。当数字阅读逐渐成为主流,...

游戏内天气系统模拟小工具

在游戏开发领域,天气系统早已超越“背景装饰”的定位,成为塑造玩家体验的关键元素。一款轻量化的天气系统模...

网页悬浮菜单功能自动化交互测试工具

网页悬浮菜单作为现代网页设计的常见交互元素,其功能稳定性直接影响用户体验。传统手工测试在面对复杂悬浮逻...

邮件自动归档存储管理系统

某国际物流公司的IT部门最近发现,员工平均每天花费47分钟处理邮件整理工作。传统的手动归档方式不仅消耗时间,...

智能音乐播放列表文件生成器

音乐爱好者常面临一个难题:如何在海量曲库中快速整理出符合特定场景、情绪或主题的播放列表。手动筛选不仅耗...

简易画中画视频播放器(支持多窗口同步控制)

在碎片化学习与多任务处理场景下,某款国产视频播放器近期引发市场关注。这款支持四窗口同步控制的工具,以极...

单词本记忆卡片系统(艾宾浩斯复习算法)

翻开单词本时,那些似曾相识的字母组合总让人陷入纠结——昨天刚背过的词汇,今天却像从未见过。这种遗忘困境...

拼音转换文件名批量处理器

日常办公中常遇到文件名混乱的困扰——中文命名文件在不同系统间传输时易出现乱码,特殊字符导致检索困难。针...

天气数据定时抓取与提醒器

天气预报早已融入现代生活,但传统服务存在更新滞后、信息单一等问题。一款名为「气象哨兵」的智能工具正在改...

局域网设备在线检测器(ARP扫描弹窗通知)

局域网设备在线检测器(ARP扫描弹窗通知)是一款针对中小型网络环境设计的轻量化安全工具。该工具通过主动监测...

基于SMTP的数据库主从同步延迟邮件告警系统

在分布式数据库架构中,主从同步延迟超过阈值可能导致业务数据不一致、订单处理异常等严重事故。某电商平台曾...

单词背诵抽卡程序

翻开单词书的瞬间,困意总会准时袭来——这种场景外语学习者再熟悉不过。传统背诵方法依赖机械重复,大脑很快...

文件权限管理工具(Linux系统专用)

在Linux操作系统中,文件权限是系统安全的第一道防线。当管理员在终端输入"Permission denied"提示时,往往需要借助权...

颜色格式批量转换工具(RGB↔HEX↔HSL)

在数字设计领域,颜色格式的转换是设计师和开发者绕不开的基础操作。无论是调整网页的CSS样式,还是优化移动端...

简易网络爬虫代理轮换工具

网络爬虫在数据采集过程中常面临IP封禁问题。代理轮换工具通过动态切换IP地址,帮助用户规避反爬机制,提升数据...

扫码固定资产标签管理与折旧计算平台

随着企业资产管理需求日益精细化,传统手工台账逐渐暴露效率瓶颈。某中型制造企业上月因设备台账登记错误导致...

基于Django的待办事项Web应用

清晨的阳光斜照在咖啡杯边缘,程序员小陈习惯性点开浏览器里的待办事项页面。这个用Django搭建的任务管理系统,...

登录记录时间线可视化工具

数字化时代,用户登录行为数据如同散落的拼图碎片。如何快速定位异常登录、回溯安全事件轨迹,成为企业安全运...

多层级目录图片缩略图生成器

在数字化信息爆炸的今天,图片管理已成为设计师、摄影师、电商从业者等群体的刚需。面对动辄上千张图片的文件...

基于Cron的批量图片OCR识别工具

凌晨三点的服务器机房,数十万张医疗票据扫描件在硬盘阵列中沉睡。当城市尚未苏醒时,系统已自动启动文字识别...

视频片段剪切合并工具(基础功能)

手机相册里堆满零碎素材,电脑桌面存着十几个未完成的视频片段——这种场景对多数普通用户来说并不陌生。市面...

日志文件分析器(关键词统计-过滤)

海量日志数据如同未经提炼的矿石,隐藏着系统运行状态、用户行为轨迹等重要信息。传统人工查阅方式在应对日均...

哈希链生成器(连续哈希计算)

在数字资产保护领域,哈希链生成器如同一套精密设计的密码齿轮组。这种通过反复执行哈希运算构建链条的工具,...

简易数据库备份工具(MySQL定时导出)

凌晨三点的服务器警报声划破寂静,运维小张盯着屏幕上"数据库异常"的红色提示,后背瞬间被冷汗浸透。这种惊悚时...

基于浏览器的代码语法高亮展示工具

在编程教学、技术文档编写或在线代码分享场景中,清晰的代码展示直接影响信息传递效率。基于浏览器的语法高亮...

文本文件关键词高亮搜索工具(支持多文件批量处理)

在日常办公或编程开发中,面对海量文本文件时,快速定位关键信息往往让人头疼。传统的文档搜索工具虽然能解决...

简易编译器(解析数学表达式)

数学表达式解析能力是图形计算器、报表工具等应用的核心模块。某开发者社区近期开源了一款C语言实现的表达式解...

简易绘图工具(Turtle-PyQt)

屏幕上的光标突然动了起来,一笔一画勾勒出歪歪扭扭的正方形。对于Python初学者来说,这可能是他们第一次见证代...

系统时间同步状态监控与偏差报警脚本

在分布式系统或跨区域网络中,服务器时间的一致性直接影响日志分析、事务处理等核心业务。传统的时间同步方案...

网页爬虫数据采集器(支持正则匹配)

在信息爆炸的互联网时代,高效获取结构化数据成为许多行业的核心需求。网页爬虫数据采集器作为一种自动化工具...

系统服务监控工具(进程状态查看)

在服务器运维工作中,运维工程师每天需要面对数十个运行中的系统进程。某次线上服务异常时,技术团队曾耗费两...

日志统计可视化仪表盘生成器

在数字化运维场景中,日志分析是定位问题、优化系统的核心环节。传统日志处理依赖人工逐行检索,耗时且容易遗...

汇率波动趋势图表生成器

在金融市场的动态环境中,汇率波动直接影响着跨国贸易、投资决策与个人资产管理。面对瞬息万变的国际货币市场...

番茄工作法时间管理工具(带休息提醒)

在星巴克角落敲键盘的年轻人手腕上,总能看到闪着绿光的电子表。当倒计时归零的震动声响起,他们才会放下滚烫...

代码仓库提交异常频率监测系统

清晨八点的办公室,某互联网公司的技术总监李航习惯性打开监控面板。一组红色预警引起他的注意:支付核心模块...