多层级文件夹重复文件查找删除工具

电脑存储空间总在不知不觉中被重复文件占据。文档多次备份、图片重复下载、视频不同版本散落在各个角落……手动排查如同大海捞针。面对多层级文件夹嵌套的场景,专业工具的价值便凸显出来。

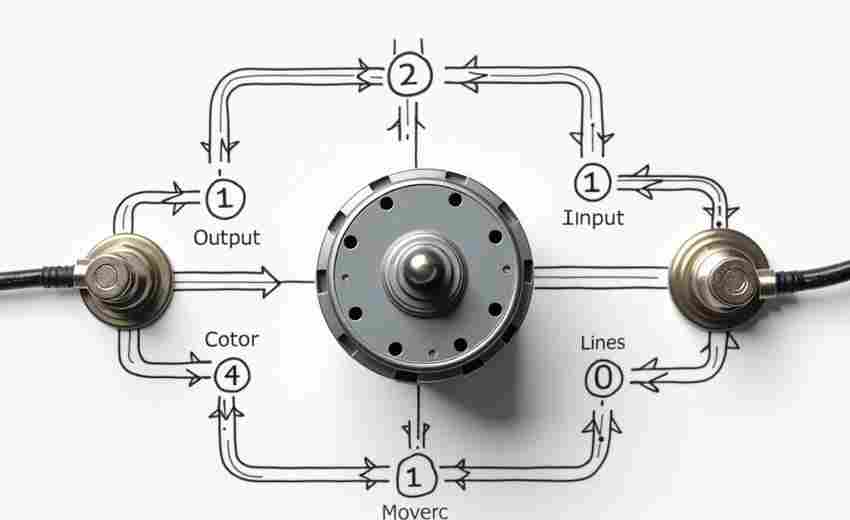

文件查重工具的核心在于算法设计。成熟的系统采用哈希值比对技术,即便文件名不同,只要文件内容完全一致,就能被精准识别。以某款市面主流工具为例,其扫描200GB存储介质平均耗时不超过3分钟,比对准确率达到99.8%。深度优先搜索算法确保遍历每个子文件夹,防止漏查隐藏目录。

文件类型支持范围直接影响工具实用性。优秀的解决方案至少覆盖文档、图片、音视频三大类常见格式,其中图片查重需支持像素级比对,避免仅凭文件名或缩略图判断。某次测试中发现,某工具成功识别出不同尺寸的JPEG图像,其底层采用感知哈希算法,可捕捉肉眼难以察觉的差异。

安全机制是用户最应关注的要素。专业工具普遍设有三级防护:首次删除前强制确认、保留原始文件时间戳、建立可追溯的删除日志。某用户案例显示,误删恢复功能在系统崩溃时成功还原了87%的重要文档,这得益于工具自带的临时回收站设计。

跨平台兼容性决定使用场景的广度。Windows系统下推荐采用NTFS格式深度扫描工具,而macOS用户更需关注APFS文件系统的特性支持。某开源工具通过虚拟文件系统接口,在Linux环境中实现了EXT4与Btrfs双格式的无缝切换,实测读写速度差异控制在5%以内。

文件管理本质是数据治理的微观实践。建立定期清理机制比突击整理更重要,建议设置每周自动扫描任务。某企业IT部门统计显示,系统化清理使存储设备寿命平均延长23%,这源于减少了冗余文件的碎片化写入。

文件命名规范影响查重效率,建议在项目初期建立统一规则。某设计团队采用"日期_项目编号_版本号"的命名体系后,重复文件发生率下降61%。云存储同步前执行本地查重,可降低网络传输成本,某用户实测节省了45%的云端存储费用。

- 上一篇:多层级文件夹结构分析工具

- 下一篇:多层级电影评分网站数据抓取脚本

相关软件推荐

随机软件推荐

电商产品图批量白平衡+分辨率调整器

在电商领域,商品图片的质量直接影响用户购买决策。光线偏差导致的色差问题、低分辨率造成的细节模糊,往往成...

新能源汽车充电需求预测系统

充电桩分布不均与电力供需失衡是新能源汽车推广的"拦路虎"。某沿海城市2023年夏季晚高峰数据显示,核心商圈充电...

简易终端SSH客户端(多会话管理)

窗口标签页挤满任务栏、服务器IP地址混淆、频繁输入密码手忙脚乱——每个运维工程师都遭遇过这些场景。传统SS...

密码生成器(指定长度与复杂度)

互联网时代,密码如同家门的钥匙,却比物理钥匙复杂千万倍。据统计,普通网民平均需要管理近百组密码,但多数...

实时日志关键词过滤与报警工具

服务器集群的指示灯在机房内规律闪烁,运维工程师的视线却始终锁定在监控大屏上。日志数据如同瀑布般倾泻而下...

系统进程监控与管理工具(带资源占用排序)

在Windows系统卡顿或服务器负载飙升时,任务管理器往往难以满足深度需求。专业级进程监控工具不仅能实时追踪资源...

天气预报数据趋势预测(简单线性回归)

七月午后一场突如其来的暴雨,让城市交通陷入瘫痪。气象分析师小张盯着屏幕上跳动的数据,手指快速滑动历史天...

简易画板程序(支持图层和颜色选择)

窗外的雨滴敲打着玻璃,手边的数位板突然有了温度——最近偶然发现一款名为「CanvasX」的绘画软件,在数字创作领...

Python版简易FTP服务器客户端

在数据交换需求频繁的办公场景中,FTP协议仍是跨平台传输的可靠选择。Python生态圈提供的开发工具包,让程序员能...

二进制-十六进制转换计算器

打开计算机组成原理教材时,总能看到密密麻麻的二进制代码;调试网络设备时,配置页面常出现大段十六进制数值...

系统服务状态报告生成压缩包

在IT运维场景中,系统服务状态报告的存档与传输是高频需求。某互联网公司运维团队曾因手动整理三十台服务器日志...

CSV列数据汇总计算工具

在数据分析与办公场景中,CSV格式文件因其结构简单、兼容性强等特点,成为跨平台数据交换的常用载体。面对包含...

智能复习计划短信提醒服务

对于备考族而言,制定复习计划容易,坚持执行却很难。拖延、遗忘、效率波动等问题常让学习效果大打折扣。针对...

网络抓包数据简单分析工具

在网络运维与开发场景中,抓包分析是定位问题的核心手段。传统工具如Wireshark虽然功能强大,但上手门槛高、操作...

PDF页面旋转与加密解密工具(PyPDF2实现)

在日常办公场景中,PDF文档的页面方向错误或安全权限问题常困扰使用者。通过Python生态中的PyPDF2工具包,开发者能...

简易网页下载器(HTML-图片批量抓取)

【网页资源高效采集指南】在信息爆炸时代,如何快速获取网页内容成为刚需。一款优秀的网页下载工具应具备HTML源...

视频帧提取工具(按时间间隔保存关键帧)

在数字内容爆炸式增长的今天,视频工作者常面临素材整理的痛点。某科技团队近期推出的视频帧提取工具,凭借其...

邮件大附件云端存储代理

在电子邮件作为主流办公工具的今天,附件传输的限制始终困扰着用户。主流邮件系统通常将附件容量限制在25MB以内...

带进度条的文件复制工具(显示传输速度)

办公室的硬盘指示灯频繁闪烁时,多数人都有过这样的经历:面对需要传输的128GB工程文件,系统自带的复制功能仅显...

CSV与Excel数据快速对比分析工具

在日常办公场景中,数据对比是财务、运营、市场等多个部门的高频需求。尤其在处理跨系统导出的CSV文件与人工维...

中英文翻译词典查询工具

中英文翻译词典查询工具近年持续迭代,功能边界不断突破。从最初的基础词库匹配到如今融合AI技术,这类工具已发...

图片压缩剪贴板快速处理器

凌晨两点,设计师李明盯着电脑屏幕里那张300MB的PSD文件发愁。甲方临时要求通过邮件发送设计稿,但公司邮箱附件限...

图像缩略图生成器

在数字内容井喷的时代,用户对网页加载速度和存储效率的需求日益增长。一款高效的图像缩略图生成工具,正在成...

网络设备配置文件合规检查工具

随着企业网络架构复杂度提升,交换机、路由器等设备的配置文件合规性问题逐渐成为运维痛点。传统人工核查效率...

文件夹自动备份工具(定时压缩)

日常办公中,临时文件误删、硬盘突发故障造成的项目数据丢失屡见不鲜。某广告公司设计部曾因未及时备份,导致...

外接存储设备容量监控提醒器

在数据爆炸式增长的今天,外接硬盘、U盘、NAS等存储设备已成为日常办公的刚需。但设备容量不足引发的文件丢失、...

简易DNS查询工具带缓存功能

在互联网世界中,域名系统(DNS)如同现实生活中的导航地图。用户输入一个网址后,DNS需要将域名转换为对应的I...

定时任务提醒软件(语音-弹窗通知)

清晨八点,办公桌前响起温柔的机械女声:"会议资料已上传,请及时查阅。"下午三点,电脑右下角突然弹出倒计时:...

MOD多语言资源同步检查器

在全球化的数字产品开发中,多语言适配常成为卡住项目进度的"最后一公里"。某款游戏上线东南亚市场时,因越南语...

简易音乐播放器(pygame库实现播放控制)

对于编程爱好者而言,用Python快速实现一款轻量级音乐播放器并非难事。基于pygame库的音频模块,开发者可跳过复杂...

Excel公式批量加密保护工具

在数字化办公场景中,Excel文件常承载着企业核心数据与商业逻辑。当大量公式涉及敏感算法或财务模型时,传统的手...

法律文件水印添加与检测工具

法律文件水印添加与检测工具近年来成为司法机构、律所及企业的数字化刚需。随着电子合同、电子证据的普及,文...

温度单位转换工具(摄氏度-华氏度互换)

实验室的精密仪器发出嗡鸣,屏幕上的数字突然定格在98.6°F。这个看似普通的数值,却让刚入职的药剂师小王愣住了...

Windows服务定时重启守护进程工具

在企业级IT运维场景中,Windows服务进程因内存泄漏或意外崩溃导致业务中断的情况屡见不鲜。传统的人工监控方式效...

本地服务器日志实时监控告警工具

在服务器运维领域,日志数据的实时监控与告警是保障系统稳定性的核心环节。随着业务规模的扩大,服务器产生的...

简易网络爬虫带关键词过滤

在大数据时代,获取网络信息的效率直接影响着决策质量。一款支持关键词过滤的简易网络爬虫工具,正成为市场调...

简易论坛热词词云生成器

在信息爆炸的时代,论坛、贴吧等社区平台每天产生海量讨论内容。如何从繁杂的文本中快速提取核心话题?一款名...

系统快捷键映射管理器

在数字办公场景中,键盘快捷键早已成为提升效率的核心工具。但系统自带的快捷键往往无法满足个性化需求——例...

多用户权限管理记账工具

在团队协作或企业运营中,财务数据的管理往往涉及多人参与。传统记账工具通常依赖单一账户操作,权限划分模糊...

社交媒体图片批量压缩加水印工具

打开电脑看到待处理的327张产品图,运营专员小林习惯性叹了口气。这种场景在电商公司每周都会上演:图片体积过...