基于urllib的网页图片批量下载爬虫工具

在互联网信息爆炸的时代,网页图片采集需求持续增长。基于Python标准库urllib开发的批量下载工具,凭借其原生兼容性和轻量化特征,成为许多开发者处理中小规模图片采集任务的首选方案。

该工具的核心实现逻辑围绕HTTP请求与文件存储展开。通过urllib.request模块发送HEAD请求获取资源类型,利用正则表达式匹配网页源码中的图片URL特征值。开发者需要针对目标网站的DOM结构编写特定的XPath或CSS选择器,例如处理电商平台产品图时,通常需要定位class包含"product-img"的div容器。

代码实现中需重点构建三个功能模块:页面解析器负责提取有效图片链接,下载控制器管理多线程任务队列,本地存储器采用二进制写入模式。为防止触发网站反爬机制,建议在请求头中随机切换User-Agent参数,并设置500ms以上的间隔延时。

实际测试发现,某服装品牌官网单页约含30张产品图(平均尺寸800KB),在常规网络环境下完整下载耗时约47秒。值得注意的是,部分网站采用延迟加载技术,需配合Selenium模拟滚动操作才能获取完整资源列表。此时可将urllib与自动化测试工具结合使用,构建混合型采集方案。

数据存储环节推荐采用时间戳+MD5哈希的复合命名规则,既能避免文件重复,又能建立清晰的文件索引体系。对于需要持久化管理的项目,建议将下载日志记录为CSV格式,包含文件来源URL、下载时间、文件大小等元数据。

法律层面需特别注意《络传播权保护条例》相关规定,商业性批量下载行为应当取得著作权人许可。技术方面,开发者应设置合理的采集频率,避免对目标网站服务器造成过大负荷。

相关软件推荐

随机软件推荐

XML-JSON转换工具(xmltodict库)

在数据处理领域,XML与JSON格式的转换需求长期存在。一个名为xmltodict的Python第三方库,正以轻量级解决方案的姿态活...

网页HTML转Markdown格式转换器

打开代码编辑器的瞬间,程序员的指尖在键盘上方停顿了五秒。显示器上堆砌着三层嵌套的HTML表格,客户要求将上周...

待办事项清单管理工具(带本地存储)

点击桌面右下角的时间显示区域,一个极简的悬浮窗跃然而出。这是TodoMaster区别于其他任务管理软件的核心交互方式...

文本文件差异比较工具(并排显示对比)

在信息处理频繁的数字化场景中,文本差异比对工具逐渐成为效率刚需。当开发者需要合并代码分支、编辑需核对合...

支持批量图片方向校正的工具

工作室内,摄影师小林正面对上千张拍摄素材发愁——横构图与竖拍作品混杂,部分照片因设备问题出现方向错乱。...

支持OCR识别的截图文字提取工具

数字时代每天产生海量图像信息,办公场景中PDF合同、会议纪要截图、纸质文档照片等非结构化数据大量堆积。传统...

基于Pandas的Excel表格数据批量导出工具

在数据处理与分析领域,Excel因其易用性和广泛兼容性成为最常见的工具之一。面对大规模数据或多文件批量处理时,...

老旧照片批量修复与增强工具

泛黄的老照片承载着几代人的情感记忆,却在时光侵蚀下面临褪色模糊的困境。某科技团队推出的智能修复系统,正...

网络设备配置文件合规检查工具

随着企业网络架构复杂度提升,交换机、路由器等设备的配置文件合规性问题逐渐成为运维痛点。传统人工核查效率...

PyQt5实现的Markdown编辑器

对于追求效率的内容创作者而言,一款简洁高效的Markdown编辑器不可或缺。近期,一款基于PyQt5框架开发的本地化Mar...

电子书章节标题提取工具(.epub)

在数字阅读逐渐普及的当下,电子书格式的多样性对内容管理提出了新挑战。以.epub格式为例,其特有的非线性排版结...

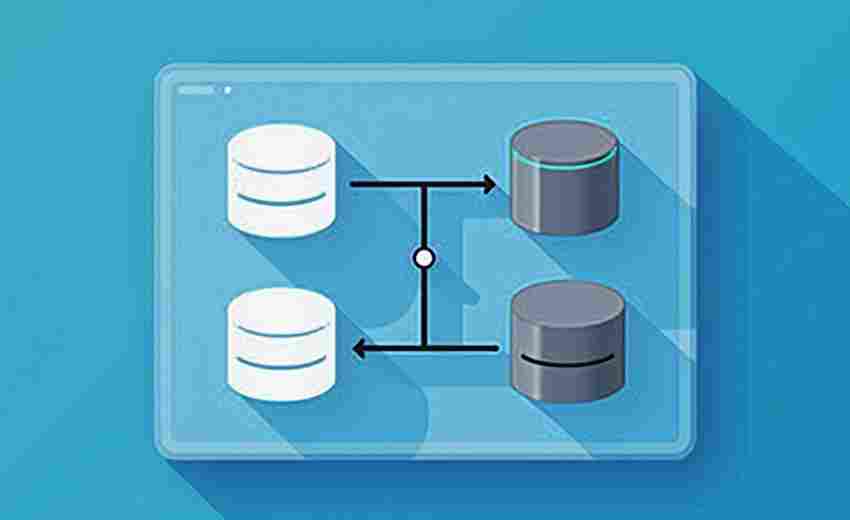

自动文件备份与同步脚本

在信息爆炸的时代,数据如同沙漏中的细沙不断累积。普通用户手机里可能躺着5个不同云盘的客户端,设计师的电脑...

基于Turtle模块的几何图形绘制器

在程序与艺术的交汇点上,Python语言的Turtle模块悄然绽放出独特魅力。这款诞生于1967年的绘图工具,历经半个世纪迭...

备忘录数据导出工具(CSV-JSON格式)

现代人手机里存储着大量日程安排、灵感记录和待办事项,但应用自带的备份功能往往存在局限。当需要跨设备转移...

数学题自动生成器(中小学难度)

一、核心功能与适用场景 数学题自动生成器是一款专为中小学师生设计的智能工具,覆盖从小学一年级到初中三年级...

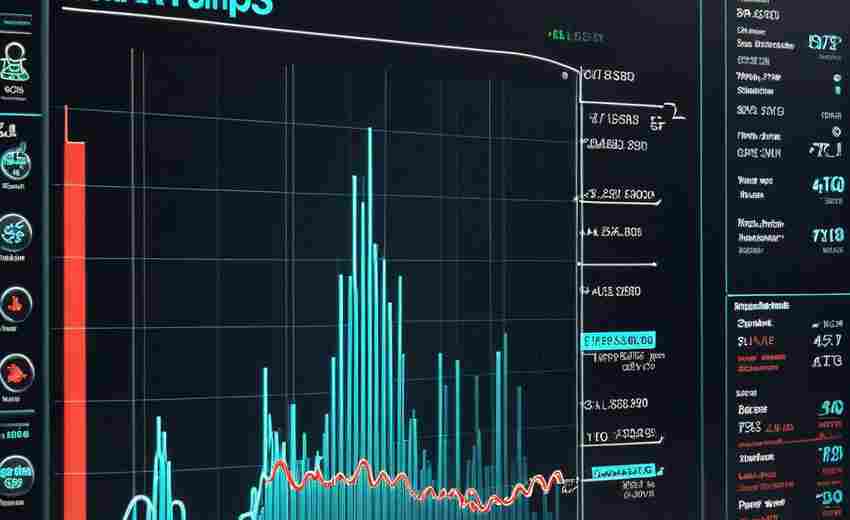

股票历史数据下载与分析工具(Tushare)

金融数据领域流传着一句话:得数据者得天下。Tushare作为国内老牌金融数据接口,凭借其稳定的服务和丰富的数据库...

批量压缩包属性修改器(统一修改时间戳-属性信息)

日常办公场景中,大量压缩文件的管理常面临属性信息混乱的问题。某技术支持团队在项目收尾阶段发现,387个交付...

宇航员健康数据语音日志系统

在长期太空任务中,宇航员的健康监测面临特殊挑战——微重力环境下传统手动记录数据的效率低下,突发健康问题...

多线程图片格式兼容性检测修复器

图片格式兼容性问题常导致素材无法正常显示。例如网页设计场景中,设计师交付的WebP格式图片可能因浏览器版本限...

Last.fm用户听歌多样性指数计算器

在数字音乐流媒体时代,用户的听歌数据成为分析个人偏好的重要依据。Last.fm作为全球知名的音乐社交平台,长期记...

键盘鼠标宏录制器(动作回放功能)

在效率至上的数字时代,键盘鼠标宏录制器正逐渐成为游戏玩家、办公白领及设计从业者的必备工具。这种能够记录...

单词背诵抽卡软件(自定义词库)

背单词软件层出不穷,但真正解决用户痛点的产品却屈指可数。某款主打卡片化记忆的新锐工具近期引发关注,其突...

文件权限与属性保留同步工具

在服务器运维或跨设备协作场景中,文件同步工具的可靠性往往被简化为"能否完整传输数据"。真实环境中存在一个常...

视频批量添加章节标记工具

视频创作者常面临一个痛点:如何在海量素材中快速定位关键内容。手动为每个视频添加章节标记耗时费力,尤其在...

微博评论情感倾向分析器(基础版)

微博作为国内用户活跃度最高的社交平台之一,每天产生数千万条评论内容。这些碎片化信息蕴含着大量用户情绪,...

腾讯视频播放量排行榜生成器

随着网络视频内容的爆发式增长,如何在海量内容中精准捕捉观众喜好成为行业难题。一款基于腾讯视频平台的播放...

天气API数据获取与桌面提醒工具

现代人对于天气信息的依赖远超想象。早晨出门是否需要带伞,出差前查看目的地温度,运动时避开暴雨时段……实...

外文网页内容自动翻译插件

浏览外文网页时,文字符号组成的迷阵常令人望而却步。当传统翻译工具需要反复复制粘贴时,智能插件正悄然改变...

CSV自定义字符集编码转换工具

数据处理过程中,CSV文件因结构简单、兼容性强被广泛使用。但当文件涉及多语言或特殊符号时,编码问题常导致乱...

微博话题地域分布热力图生成工具

微博作为国内最大的社交平台之一,每天产生海量话题数据。如何快速捕捉话题在不同区域的热度差异,成为舆情分...

磁盘空间热力图生成器

电脑硬盘空间总在不知不觉中被各类文件吞噬。当系统弹出"存储空间不足"的警告时,用户常常陷入茫然——究竟哪些...

网页内容变更自动检测与邮件通知工具

互联网信息瞬息万变,无论是电商平台的价格调整、企业官网的公告更新,还是竞争对手的页面改版,用户往往难以...

智能股票交易提醒工具(设定阈值)

证券市场瞬息万变,普通投资者常因盯盘时间有限错失交易良机。智能股票交易提醒工具通过"阈值设定"功能,为不同...

本地磁盘空间分析可视化工具(树状图)

在数字化时代,硬盘空间总在不知不觉中告急。面对层层嵌套的文件夹与混杂的文件类型,传统存储管理方式如同在...

文档关键词高亮导出工具

在信息过载的办公场景中,某科技公司研发团队近期开发出一款智能文本处理工具,该工具针对文档关键词处理功能...

密码语音生成工具(TTS朗读生成的密码)

在信息安全领域,密码管理始终是个人与企业的重要课题。传统密码记忆方式存在遗忘风险,而文字记录又面临泄露...

天气查询命令行工具(接入API数据)

窗外的雨点敲击键盘时,某个运维工程师正盯着黑色终端窗口。他输入"weather -c shanghai -u",0.8秒后,彩色编码的降雨...

股票价格波动预警通知脚本(调用财经API)

金融市场的高波动性让投资者对价格变动保持高度敏感。针对这一需求,基于财经API开发的股票价格波动预警工具应...

外汇点差实时比较工具(多平台API)

全球外汇市场日均交易量超7万亿美元,点差作为隐易成本,直接影响着投资者的最终收益。传统人工比价模式效率低...

系统声音控制器(分应用调节)

当视频会议中突然弹出广告音效,当深夜追剧遭遇游戏音效突袭,多数人选择匆忙点击全局静音键。这种"一刀切"的操...