利用urllib的网站可用性监测程序

网站可用性监测是运维工作中不可或缺的环节。基于Python标准库urllib开发的监测工具,因其轻量化和高兼容性,成为中小型企业常用的解决方案。本文重点解析该工具的核心设计逻辑与典型应用场景。

核心代码架构

通过urllib.request模块构建基础请求框架,核心代码不超过30行。关键点在于异常捕获机制的设计——当目标站点返回5xx状态码或响应超时时,timeout参数与try-except语句配合实现错误拦截。部分开发者会忽略URLError与HTTPError的区别,前者涵盖网络层故障,后者专精HTTP协议错误,精确分类能提升日志分析效率。

性能优化策略

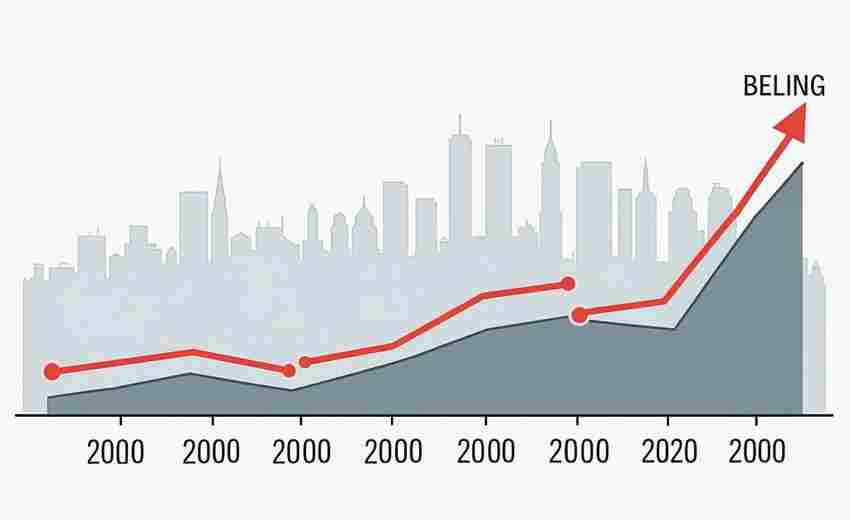

同步监测模式存在效率瓶颈,引入concurrent.futures线程池可将检测效率提升8-12倍。某电商平台实测数据显示,200个站点的批量检测耗时从42秒压缩至3.8秒。但需注意线程数设置,超出系统TCP连接限制反而会引发虚假报警。

典型误判场景

某金融客户曾遭遇凌晨时段频繁误报,根源在于监测节点与CDN节点的时钟不同步。解决方案是增加区域性监测节点,通过地理分散部署消除单点偏差。另一个常见问题是SSL证书验证失败,临时关闭验证虽能解决问题,但会带来中间人攻击风险,更推荐定期维护证书白名单。

数据可视化延伸

原始工具仅输出文本日志,通过集成matplotlib库可生成响应时间趋势图。某在线教育平台通过时序分析,成功定位到每天10:00-11:00的周期性延迟现象,最终发现是定时备份任务占用带宽所致。这种可视化改造使工具价值从基础监控升级到性能优化层面。

监测频率需遵守robots协议约定

异常告警应设置多级触发阈值

历史数据保留周期建议不少于90天

响应时间统计要区分DNS解析和服务器处理时间

- 上一篇:利用Unittest的模块功能测试框架

- 下一篇:利用回溯算法的数独求解器

相关软件推荐

利用logging模块开发的程序运行日志记录工具

发布日期: 2025-04-03 12:54:02

在日常开发中,程序运行日志如同飞机黑匣子般重要。Python标准库中的logging模块提供了...

利用PyJWT的API访问令牌生成验证工具

发布日期: 2025-03-24 13:58:25

现代API开发中,安全验证机制直接影响系统可靠性。PyJWT作为Python生态中成熟的JWT(J...

随机软件推荐

汇率波动趋势图表生成器

在金融市场的动态环境中,汇率波动直接影响着跨国贸易、投资决策与个人资产管理。面对瞬息万变的国际货币市场...

网站可用性监测与报警脚本

互联网服务中断造成的损失每小时可达数十万美元,传统人工巡检模式已无法满足现代企业的运维需求。某跨国电商...

批量创建文件夹结构生成器(树状图)

日常工作中,每当启动新项目总会遇到相同困扰——需要手动创建大量嵌套文件夹。某国际咨询公司的调研数据显示...

智能药盒定时提醒服药装置

药盒与计时器结合的设计并不新鲜,但传统设备常因功能单一被闲置。某品牌近期推出的第五代智能药盒,通过多模...

简易屏幕截图工具(支持区域选择快捷键)

每次整理工作周报时,总要在十多个窗口间反复切换截图。直到上个月发现某款轻量级截图工具,彻底改变了我的工...

局域网设备在线状态监控与提醒程序

在智能设备普及的今天,家庭和办公场所的网络环境正变得日益复杂。当无线打印机突然离线、会议室投影仪连接异...

自动化Excel报表生成工具(模板数据填充)

在日常办公场景中,Excel报表的重复性制作常被视为效率瓶颈。财务人员需要反复核对数据模板,销售团队每周手动更...

数据跨表关联校验工具

企业数据库里散落着成千上万的表格,看似无关的采购单号可能在物流系统里对应着运输批次,财务系统中的客户编...

简易思维导图生成器(导出为图片)

信息爆炸的时代,大脑每天需要处理海量碎片。如何让复杂逻辑快速清晰呈现?支持图片导出的简易思维导图生成器...

文件系统索引搜索工具

在数字信息爆炸的时代,电脑中的文件数量往往以几何级数增长。传统的资源管理器搜索功能常因响应速度慢、支持...

计算器(支持基本四则运算与历史记录)

现代计算器早已突破传统数学工具的局限,成为日常生活不可或缺的助手。具备四则运算与历史记录功能的设备尤其...

压缩文件内容搜索工具(关键词查找)

在信息爆炸的数字化时代,压缩文件已成为存储传输的必需品。面对动辄数十GB的压缩包,传统解压检索方式显得力不...

文本文件逐行对比差异工具

日常办公与程序开发中,文件版本管理常令人头疼。某款专注逐行对比的文本差异工具,正成为解决这类问题的专业...

软件错误堆栈跟踪关键信息提取工具

在软件调试过程中,开发者常常要面对长达数百行的错误堆栈信息。某次线上服务崩溃事故中,某电商平台工程师从...

自动化测试截图比对工具(像素差异检测)

当移动端应用迭代周期缩短至周更模式,某头部电商团队曾因按钮位置偏移2个像素点导致用户日均投诉量激增37%。这...

后台服务异常自动重启监控器

运维工程师凌晨三点接到报警电话的场景在互联网行业并不罕见。某电商平台在去年双十一期间因订单服务突发崩溃...

本地天气信息查询桌面小部件

现代人对于天气的关注早已不止于"带不带伞"这类基础需求。通勤路线规划、运动时间选择、出差行程安排……精准的...

网络爬虫抓取指定网站标题和链接的脚本

在互联网时代,数据抓取工具已成为市场调研、舆情监控等领域的重要助手。基于Python开发的网络爬虫脚本因其灵活...

简易CSV文件数据筛选与统计工具

在日常办公或数据分析场景中,CSV格式文件因其兼容性强、结构简单而广受欢迎。面对庞杂的表格数据,手动筛选、...

数字进制转换计算器(自动保存常用进制)

深夜的办公室里,键盘敲击声夹杂着显示器蓝光。程序员老张盯着屏幕上的十六进制错误代码,手指悬停在计算器上...

多标签书签整理助手

在信息爆炸的时代,浏览器书签栏早已成为无数人存储知识、灵感与待办事项的"数字仓库"。然而随着时间推移,超过...

简易聊天室客户端(局域网版)

在局域网环境下实现即时通讯,许多团队仍面临工具适配难题。公共社交平台存在信息泄露风险,专业企业软件又常...

电商商品评论情感与主题分类工具

海量商品评论的涌现为电商平台带来新挑战。面对每天数以万计的文本数据,人工处理效率低下且难以捕捉深层信息...

定时备份指定文件夹到云端存储工具

办公室的日光灯管偶尔发出细微电流声,王磊盯着电脑屏幕右下角跳出的存储空间不足提示,第无数次想起上个月误...

色彩空间3D可视化教学工具

当设计师在屏幕上调整色相环时,屏幕角落的HSV数值可能只是冰冷的数字;当印刷师傅对照潘通色卡时,纸张与屏幕...

QQ群消息关键词监控器

网络社群每天产生海量信息,如何在海量对话中快速抓取核心内容?某科技团队近期推出的QQ群消息关键词监控器,正...

批量重命名电视剧集工具(季集号智能识别)

对影视爱好者而言,整理散乱无序的剧集文件堪称技术活。当电脑里存着《绝命毒师》S01E03、《Breaking.Bad.s1e4》和《绝...

MD5哈希值批量生成多语言支持工具

在全球化开发与数据处理场景中,跨语言文本的哈希值生成需求日益普遍。无论是验证多语言文件完整性,还是构建...

学术论文PDF元数据提取与整理工具

学术文献管理中的PDF元数据处理难题长期困扰研究者群体。面对海量文献资源,如何快速获取论文标题、作者、期刊...

数列求和工具(等差-等比数列自动计算)

在数学学习和工程计算中,等差数列与等比数列的求和问题频繁出现。传统的手动推导不仅耗时,还容易因计算步骤...

使用PyPDF2实现的PDF文档合并分割工具

纸质文件堆积如山的办公桌上,财务小王正为合并二十份季度报表发愁。隔壁工位的程序员老张默默敲了几行代码,...

自动化生成API文档的Markdown转换器

在软件开发领域,API文档的编写常被视为"必要之恶"。据行业调查显示,超过60%的开发者每周需耗费4小时以上维护文...

颜色拾取工具(屏幕取色显示HEX-RGB值)

玻璃幕墙反射着晚霞的橙红色,设计师小王对着显示器皱起眉头。客户临时要求把APP主题色改成「和窗外夕阳相近的...

Pillow库实现的图片格式转换器

在日常开发与数据处理中,图片格式转换是高频需求之一。Python生态中的Pillow库凭借其轻量化的设计和对多种图像格...

数学公式图像生成器(LaTeX转PNG)

学术写作中,数学公式的呈现一直是让人头疼的问题。传统文档编辑器对LaTeX的支持有限,跨平台分享时格式错乱、排...

多账号Cookie管理器(SQLite数据库版)

频繁切换账号的用户都体验过这样的场景:电商大促期间需要同时登录三个店铺后台,社交媒体运营得在五个企业号...

磁盘空间不足自动清理临时文件工具

——智能清理工具如何化解存储焦虑 办公电脑右下角突然弹出的红色预警框,大概是现代职场人最不愿看到的画面之...

密码管理器(AES加密存储)

输入第十三次相似的密码依然显示错误,手机验证码收件箱堆满临时登录凭证,这种场景在数字生活中早已司空见惯...

图片水印批量添加工具(可调位置-透明度)

在数字内容爆炸的时代,图片版权保护成为创作者不可忽视的刚需。一款高效且灵活的图片水印批量添加工具,正在...

多设备文件哈希值同步校验工具

手机相册里的旅行照片、电脑硬盘里的工作文档、云端存储的影视资源——当文件分散在多个设备中,"内容一致性...