使用Requests库的简单网页爬虫工具

在信息爆炸的时代,如何高效获取网络数据成为技术人员的必修课。Python生态中的Requests库凭借其简洁的接口设计,成为快速构建网页爬虫的首选工具。本文将以代码实例为线索,解析构建基础爬虫的关键步骤。

环境配置与基础请求

安装只需一行命令即可完成:

```bash

pip install requests

```

发送HTTP请求时,建议先设置合理的请求头信息。以下代码演示了如何模拟浏览器访问目标页面:

```python

import requests

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64)',

'Accept-Language': 'zh-CN,zh;q=0.9'

response = requests.get(' headers=headers)

print(response.status_code)

```

此处特别需要注意响应状态码的判断。当状态码为200时才进行后续处理,避免对异常页面进行无效解析。

数据解析与存储

获取页面内容后,通常需要配合BeautifulSoup等解析库提取结构化数据。以下示例展示如何提取文章标题:

```python

from bs4 import BeautifulSoup

soup = BeautifulSoup(response.text, 'html.parser')

title = soup.find('h1', class_='article-title').text.strip

print(f"提取到标题:{title}")

```

对于需要保存的数据,建议使用csv模块进行存储。代码示例如下:

```python

import csv

with open('data.csv', 'a', newline='', encoding='utf-8') as f:

writer = csv.writer(f)

writer.writerow([title, response.url])

```

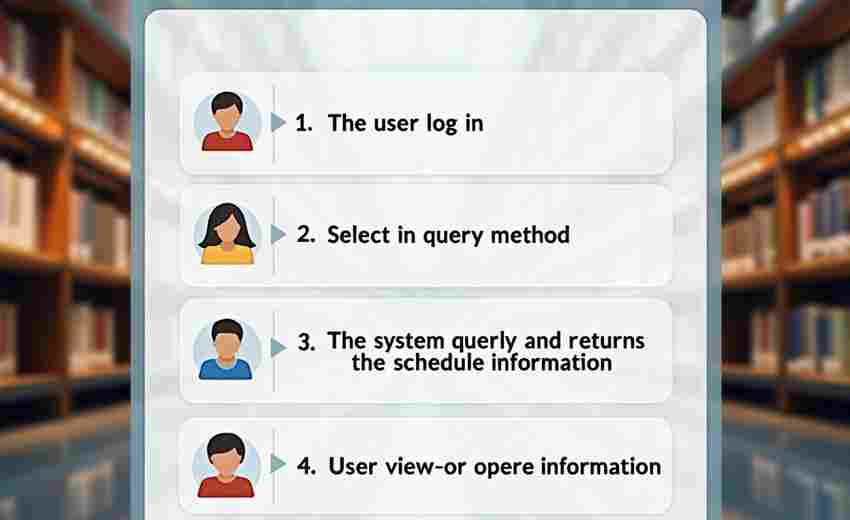

实战注意事项

1. 频率控制:通过time模块设置请求间隔,避免触发反爬机制

```python

import time

time.sleep(2.5) 保持合理请求间隔

```

2. 异常处理:使用try-except块捕获网络异常

```python

try:

response = requests.get(url, timeout=10)

except requests.exceptions.RequestException as e:

print(f"请求失败:{str(e)}")

```

3. 会话保持:需要登录的网站可使用Session对象保持登录状态

```python

session = requests.Session

session.post(login_url, data=credentials)

```

爬虫开发需要遵守目标网站的robots协议,涉及商业数据抓取时应当获取合法授权。当遇到反爬机制时,建议优先与网站方沟通而非强行突破技术限制。

相关软件推荐

随机软件推荐

自动化桌面截图定时存档工具

在远程协作成为常态的数字工作场景中,屏幕内容捕捉需求呈现爆发式增长。某款桌面截图工具通过定时自动存档功...

微信聊天记录自动备份解析工具

微信聊天记录自动备份解析工具:数据管理的隐形助手 随着微信成为日常沟通的核心工具,聊天记录中积累的工作文...

多窗口浏览器标签同步关闭工具

现代人工作时常陷入多窗口浏览的困境——研究资料时打开几十个标签页,临时处理邮件又新增一堆窗口,下班前突...

IP地理位置伪装检测文件保护工具

在数字化办公场景中,数据安全与访问权限控制的重要性日益凸显。近期,一款专注于 IP地理位置伪装检测 与 文件保...

视频文件元信息批量读取与重命名工具

在数字内容爆炸的时代,视频素材管理已成为创作者、摄影师、自媒体从业者的痛点。面对存储卡里数百个命名混乱...

PDF转图邮件发送工具(自动附件发送)

清晨八点半的办公室键盘声此起彼伏,市场部李经理正盯着屏幕上刚完成的季度报告PDF文档。这份包含20张数据图表的...

快递到达最后一公里提醒

快递物流行业的"最后一公里"服务直接影响用户体验。针对包裹到达末端网点后的信息同步需求,市场上涌现出多款智...

拼音转换汉字工具(拼音输入法核心)

键盘敲击声此起彼伏,屏幕上却跳跃出工整的汉字——这个看似简单的场景背后,藏着一场持续四十年的技术进化。...

团队任务分配协作平台API

在数字化协作场景中,团队任务的高效流转与资源合理分配直接影响项目推进效率。 团队任务分配协作平台API 作为一...

热键触发的系统音量快捷控制面板

当屏幕右下角的小喇叭图标成为每次调节音量的必经之路,多数人已默认这种繁琐操作的存在。直到某次视频会议中...

JSON命令行交互式浏览器

处理JSON数据是开发者的日常。当面对复杂嵌套的JSON文件时,传统文本编辑器容易让人迷失在层层括号中。命令行工具...

文件路径规范化处理工具

在软件开发与运维领域,文件路径的标准化处理长期困扰着技术人员。某研发团队近期在部署Web应用时,因测试环境...

会议室空气质量传感器数据可视化系统

密闭的会议室里,二十余人正在讨论项目方案。当PM2.5数值悄然突破100μg/m³时,智能新风系统自动开启换气模式;二...

文本编码自动检测工具

打开一份来自海外的数据报表时,屏幕突然跳出的方块符号让工作陷入停滞;在解析历史存档文件时,系统频繁报错...

个人笔记分类与标签管理工具

在咖啡渍与便利贴交织的办公桌上,某科技公司产品经理李薇翻找三天前的会议记录时,突然意识到自己需要改变。...

简易计算器软件(支持科学计算表达式解析)

市面上计算器工具琳琅满目,但真正能精准处理科学计算表达式的产品并不多见。某款新推出的计算器软件凭借其独...

国际专利申请文档格式转换工具

全球知识产权保护体系日益复杂,各国专利局对申请文件的格式要求存在显著差异。以PCT国际申请为例,申请人需要...

系统日志分析工具(错误日志提取)

服务器机房里闪烁的指示灯背后,每天产生着数以GB计的系统日志。某金融科技企业的运维主管王磊打开监控面板,发...

日志文件敏感信息自动过滤与脱敏工具

在数字化转型不断深化的今天,日志文件已成为企业记录系统运行状态的核心载体。这类文件中往往潜藏大量敏感信...

批量下载指定扩展名的网络爬虫

互联网数据呈指数级增长,如何从海量信息中快速抓取特定格式的文件,成为许多用户的刚需。一款支持自定义扩展...

实验性人脸检测图片批处理工具

实验性人脸检测图片批处理工具:高效处理,精准识别 在数字化时代,人脸检测技术逐渐成为图像处理领域的重要需...

实验室样本条码生成管理系统

在生物医药实验室的日常运作中,样本管理如同暗流涌动的冰山,看似平静的表面下隐藏着数据错位、追踪失效等潜...

批量图片压缩转换工具(支持WebP)

随着数字内容创作需求激增,图片管理逐渐成为设计师、电商运营等群体的高频痛点。某款支持WebP格式的图片处理工...

课堂笔记自动整理归档工具

在信息爆炸的时代,学生和职场人士每天需要处理大量课堂、会议或培训内容。纸质笔记容易丢失,电子文档散落在...

二维码生成与解码工具(支持链接和文本)

二维码已成为现代生活的基础工具。无论是网页跳转、电子票务还是信息传递,黑白小方格背后隐藏着高效的数据处...

错误持续时间箱线图统计分析器

在数据分析领域,异常事件的持续时间分布分析常面临数据离散度高、异常值干扰等问题。某技术团队近期开发的错...

局域网文件传输工具(TCP)

局域网文件传输工具基于TCP协议实现,主要服务于内部网络环境下的高效数据交换。这类工具无需依赖互联网,通过...

知乎热门问题爬取与分析工具

打开知乎客户端,每天滚动出现的海量信息背后,隐藏着当代社会的认知图谱。当传统人工检索难以应对指数级增长...

SQLite数据库统计指标计算工具

在中小型数据处理场景中,SQLite因其轻量便携的特性广受欢迎。但面对复杂的数据分析需求时,如何快速获取有效的...

Excel表格数据对比工具(自动标记差异单元格)

在数据密集型的工作场景中,Excel表格对比是高频出现的需求。财务人员需要核对多版本报表,运营团队要对比活动前...

软件需求文档变更追踪系统

在软件开发过程中,需求文档的频繁变更是团队面临的常态。据统计,约70%的项目延期与需求管理失控直接相关。面...

外文网页内容自动翻译插件

浏览外文网页时,文字符号组成的迷阵常令人望而却步。当传统翻译工具需要反复复制粘贴时,智能插件正悄然改变...

压缩文件内容搜索工具(关键词查找)

在信息爆炸的数字化时代,压缩文件已成为存储传输的必需品。面对动辄数十GB的压缩包,传统解压检索方式显得力不...

基于difflib的文本差异对比程序

在代码版本管理或文档修订场景中,人工核对文本差异往往耗时费力。Python内置的difflib库为解决这类问题提供了专业...

简易键盘记录检测工具(监控输入事件)

任何接入互联网的计算机都可能面临输入信息窃取风险。硬件层面存在USB接口键盘记录器,软件层面则潜伏着各类恶...

速度转换工具(米每秒-公里每小时-英里每小时)

清晨的沿海公路上,蓝色特斯拉以110公里/小时巡航时,车载导航突然提示前方限速65英里/小时。驾驶者轻点中控屏,...

FTP-SFTP远程文件传输监控工具

在数字化转型浪潮中,企业文件传输需求呈现爆发式增长。面对跨地域、跨系统的数据流转场景,传统人工监控方式...

PDF页面拆分与合并工具

在日常办公与学习场景中,PDF文档的灵活处理已成为高频需求。面对动辄数百页的合同文件、需要分类整理的学术资...

桌面便签小工具(置顶显示-颜色自定义)

办公室的玻璃窗上总贴着五颜六色的便利贴,这个场景在数字时代有了全新版本。当电脑屏幕逐渐取代纸质文档,桌...

计算器(科学-单位换算模式)

手持计算器早已突破简单的加减乘除功能。当人们按下"Shift"键激活第二功能面板时,这个巴掌大小的设备便展现出堪...