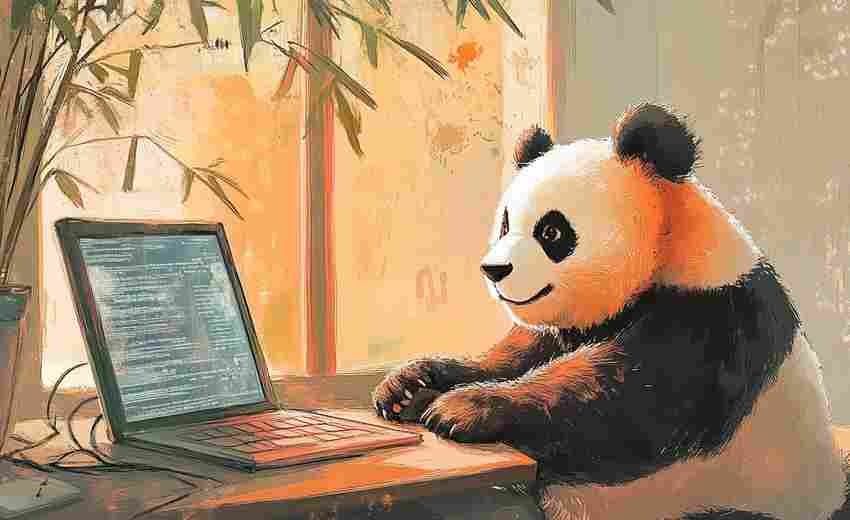

使用Pandas的CSV数据整理与分析工具

Pandas作为Python生态中最重要的数据处理库,在CSV文件处理领域展现出不可替代的价值。其DataFrame结构天然贴合表格型数据,结合丰富的内置方法链,能够将繁琐的数据整理流程转化为简洁的代码逻辑。

日常工作中常遇到的情况是,原始CSV文件往往夹杂着无效字符。某次处理电商销售数据时,发现商品价格列混入了"元"字后缀,直接导致数值类型转换失败。通过df['price'] = df['price'].str.replace('元','').astype(float)这行代码,两分钟内就完成了数据标准化。这种字符串快速处理能力,在清理客户地址、电话号码等字段时尤为实用。

空值处理常让分析工作陷入僵局。某个教育机构的学生成绩表存在15%的缺失值,直接删除会损失大量样本。尝试用df.fillna({'math_score':df['math_score'].median})对数学成绩进行中位数填充,同时保留其他学科原始数据,既保证数据集完整性又避免引入过多噪声。这种灵活的处理方式在应对不完整数据时,往往比简单删除更合理。

当需要合并多个月度的销售报表时,merge方法的how参数选择直接影响最终数据集形态。某次处理区域销售数据,左表包含全部产品型号,右表只有实际售出记录。选择左连接保留所有产品,未售出型号的销售额自动填充为NaN,这种处理方式确保市场覆盖率分析的准确性。而concat方法在垂直堆叠同类数据表时,能保持字段对齐的特性同样重要。

数据筛选方面,query方法的表达力远超普通布尔索引。处理某物流公司运输记录时,需要筛选出发货量大于1000且延误天数小于3的订单,写成df.query('shipment>1000 & delay_days<3')比传统写法节省30%的代码量。当配合@符号调用外部变量时,更能实现动态条件过滤。

可视化前的数据聚合往往决定图表的信息量。某次制作区域销售趋势图,使用df.groupby('region')['sales'].rolling(7).mean计算各区域周滚动平均,配合reset_index整理后的数据直接导入Matplotlib,生成的可视化图表清晰展现了节假日对销量的波动影响。这种从原始数据到洞察结论的快速转化,正是Pandas的核心竞争力。

时间序列处理中,pd.to_datetime的格式化能力不容小觑。处理物联网设备日志时,原始时间戳存在"2023-04-05 14:30"和"05/04/2023 2:30 PM"混用的情况。通过指定format参数统一转换,配合dt属性提取小时、星期等维度,为后续分析扫清了障碍。当处理跨国业务数据时,时区转换功能更是关键。

数据导出环节的细节处理决定成果复用性。将清洗后的数据保存为CSV时,设置index=False避免多余索引列,encoding='utf_8_sig'参数确保中文字符正常显示。需要分片存储时,np.array_split结合循环写入,可实现自动按5万行切分文件,这种处理方式在面对银行交易记录等海量数据时特别有效。

内存优化方面,category类型转换曾帮助某社交平台用户数据缩减70%内存占用。当性别、用户等级等枚举型字段完成类型转换后,不仅提升处理速度,更为后续机器学习模型的One-Hot编码做好准备。astype方法配合dtypes属性监控,形成高效的内存管理闭环。

多线程处理技术在某些特定场景下能突破性能瓶颈。使用swifter库加速apply函数,处理千万级电商评价数据的情感分析时,执行效率提升3倍以上。这种优化技巧配合chunksize参数分块读取,使得普通配置的办公电脑也能处理GB级CSV文件。

正则表达式与Pandas的结合开辟了新的可能性。某次提取客服对话记录中的订单编号,使用str.extract配合正则模式,成功从非结构化文本中捕获关键信息。这种文本挖掘能力在处理调查问卷等半结构化数据时,极大提升了信息提取效率。

当需要保持数据修改痕迹时,通过df.pipe创建数据处理流水线,配合版本控制工具,每个转化步骤都可追溯。某金融项目审计过程中,这种可复现的数据处理流程,帮助团队快速定位某个异常值的产生环节。

数据类型推断功能在自动化处理中表现突出。read_csv的infer_datetime_format参数可智能识别80%常见日期格式,converters参数支持自定义解析函数。这些特性构建起健壮的数据导入机制,特别是在处理跨部门提供的异构数据时,显著降低人工校验成本。

相关软件推荐

网络速度实时监测工具(图形化显示+历史数据记录)

发布日期: 2025-04-07 15:53:00

在数字化办公场景中,网络波动如同隐形的效率杀手。某科技公司研发的Network Velocit...

表格数据差异对比分析工具(difflib模块)

发布日期: 2025-04-13 13:18:36

Python标准库中的difflib模块常被开发者忽视,却在数据比对场景中展现出独特价值。这个...

随机软件推荐

局域网文件传输助手(Python实现)

在办公场景中,跨设备文件传输的需求时常困扰着用户。传统方式如U盘拷贝存在硬件依赖,微信传输受限于网络速度...

视频文件元数据批量编辑与整理工具

在数字内容爆炸式增长的今天,个人创作者与企业用户普遍面临视频文件管理难题。某款专业级元数据批量处理工具...

简易翻译工具(多语种API调用)

语言障碍在全球化场景中愈发凸显。一款支持多语种API调用的翻译工具,正在成为跨语言场景的实用解决方案。不同...

文本加密与解密工具(基础算法如凯撒密码)

在数字化时代,信息传递的安全性逐渐成为刚需。无论是个人隐私还是商业机密,简单的文本加密技术仍是许多场景...

基于用户操作日志的权限滥用检测工具

在企业信息化建设中,权限管理一直是安全防护的核心环节。随着业务系统复杂度提升,权限滥用行为逐渐成为数据...

AES加密的FTP-SFTP文件传输代理

在数字化办公场景中,企业文件传输需求日益复杂,既要兼顾效率,又要防范数据泄露风险。传统FTP协议虽然传输速...

简易PDF合并-分割工具(拖拽操作支持)

市面上一款名为QuickPDF的桌面工具近期引发关注。这款不足20MB的绿色软件无需安装即可运行,其极简设计风格与高效...

健身房设备使用频率统计工具

现代健身房常面临设备资源分配难题——热门器械高峰时段排队严重,冷门设备长期闲置造成资源浪费。某科技公司...

带格式校验的API请求模拟器

开发过程中最头疼的场景之一,大概是深更半夜对着文档逐字比对请求参数格式。某个字段少了个引号、数组层级多...

增量式加密配置历史管理工具

在软件工程领域,配置文件的版本管理与安全性问题长期困扰开发团队。某开源项目组近期推出一款基于增量式加密...

XML配置文件转YAML格式转换工具(保留注释)

在软件工程领域,配置文件的格式迁移常让开发者陷入两难境地。某开源团队近期推出的X2Y-Converter工具,恰好解决了...

交易备注信息随机文本生成器

在跨境支付、企业财务对账等场景中,交易备注信息的规范性直接影响着后续数据处理效率。传统人工编写方式存在...

简易人脸检测图片工具

手机相册里堆满照片时,如何快速找到特定人物的影像?社交媒体发图时,怎样精准给合照里的每个人脸打码?这些...

历史事件时间轴动态演示工具

当教师讲解甲午海战的战术布局时,学生常因时间线模糊产生理解障碍。传统PPT的时间轴往往以静态列表呈现,观众...

桌面便签工具(支持保存与提醒)

清晨八点的办公室键盘声中,某科技公司产品经理张薇习惯性点开屏幕右下角的橙色图标。三行待办事项、两则会议...

文本词频统计工具(输出TOP10)

打开一篇长文档,如何快速抓住作者的核心观点?面对海量文本数据,怎样提炼出高频关键词?文本词频统计工具通...

简易绘图板程序(基于Tkinter)

窗外的梧桐叶随风晃动,电脑屏幕前的手指正握着鼠标在画布上勾线。这个仅占用8MB内存的绘图程序,用二十七行代...

CSV转Markdown表格工具

在日常工作中,程序员、文档编辑者以及内容创作者常会遇到需要将CSV数据快速转换为Markdown表格的需求。手动处理不...

邮件内容情绪分析统计工具

在商务沟通中,邮件承载着大量关键信息,但文字背后隐藏的情绪往往难以捕捉。情绪分析统计工具的出现,为这一...

简易井字棋小游戏(GUI版)

午后的咖啡馆里,屏幕上的九宫格跃动着黑白棋子。这款由国内开发者制作的井字棋GUI小游戏,以极简设计还原经典...

基于PyQtGraph的数据可视化仪表盘

在工业控制与数据分析领域,实时监测系统对可视化工具的性能要求日益严苛。基于PyQtGraph开发的动态仪表盘解决方...

简易数据库查询工具(SQLite命令行交互)

在众多数据库管理工具中,SQLite以其轻量化和零配置的特点脱颖而出。对于开发者和运维人员来说,SQLite自带的命令...

网页自动化表单填写工具(Selenium控制)

网页自动化表单填写工具:Selenium的应用解析 在数字化办公场景中,表单填写是高频且重复的操作。无论是企业数据...

简易汇率换算器(固定汇率表)

手机屏幕亮起,国际航班订单显示着245欧元的价格,朋友圈里日本代购的新款手表标价98000日元,跨境电商平台结算界...

邮件地址有效性检查工具

邮件地址作为现代通讯的核心标识符,其有效性直接影响信息触达率。根据国际反垃圾邮件组织统计,全球每年因无...

注册表重复键值清理工具

在Windows系统的日常使用中,注册表如同一本不断更新的日志,记录着软件配置、硬件信息和用户操作痕迹。但随着程...

Selenium Web自动化测试工具

Selenium Web自动化测试工具:效率与灵活性的双重突破 在软件开发领域,测试环节的效率直接决定产品迭代速度。传统...

企业法人变更记录追踪提醒工具

监控企业法人变更信息的需求在商业活动中日益凸显。某款自主研发的法人信息追踪系统通过技术创新解决了传统信...

电商平台商品评论抓取器

互联网电商平台的商品评论区沉淀着海量用户反馈,这些真实消费体验数据正成为品牌方、商家及研究机构的重要决...

批量图片EXIF信息编辑清理工具

数码相机与智能手机普及后,海量图片存储成为常态。隐藏在每张照片里的EXIF信息,如同电子世界的隐形标签,完整...

图像格式转换GPU加速实验版

在数字图像处理领域,格式转换工具如同空气般存在于每个设计师的日常工作流中。当主流工具仍在依赖CPU进行常规...

批量重命名图片工具(日期序列化)

手机相册里堆积的五千张照片,旅行途中拍摄的八百张风景照,工作中积攒的三千份产品图——当数字影像占据存储...

桌面便签备忘录提醒程序(带定时功能)

在快节奏的现代生活中,时间管理逐渐成为刚需。桌面便签备忘录提醒程序作为办公场景的常见工具,凭借轻量化和...

翻译结果自动排版校正工具

纸质文献扫描件在跨国学术交流时,常出现译文字体错位、表格跨页断裂的情况。某生物实验室曾因技术文档的中英...

本地IP地址切换工具

清晨九点,某跨境电商公司的技术部已进入工作状态。运营组电脑屏幕上的二十余个店铺后台正在同步刷新,但此刻...

文件同步备份工具(本地-网络目录)

在数字信息爆炸的时代,一份合同、一组设计图或是一段家庭视频的意外丢失,都可能造成难以估量的损失。针对本...

桌面图标排列快捷键控制器

清晨的阳光斜照在电脑屏幕上,陈旧的咖啡杯旁堆着半沓文件。设计师小王第5次点开文件夹寻找上周的素材包时,终...

PDF转文本工具(带格式保留)

PDF格式转换工具作为现代办公场景中的刚需产品,始终占据着数字文档处理的核心位置。市场上近期出现的多款智能...

批量生成个性化邀请函工具(邮件合并版)

在商务活动、学术会议或私人聚会中,批量发送邀请函是常见需求。传统方式下,逐个修改收件人信息、称谓或活动...

文件签名验证工具(PGP-GPG)

在数字化信息交换中,数据完整性与身份认证是核心需求。PGP(Pretty Good Privacy)及其开源实现GPG(GNU Privacy Guard)作...