中文分词统计工具(统计文章高频词汇)

现代信息爆炸时代催生了海量文本处理需求。中文分词统计工具作为自然语言处理技术的重要分支,逐渐成为文字工作者不可或缺的智能助手。这类软件通过算法模型自动拆分文本中的词语,统计词频分布,帮助用户快速把握文章核心内容。

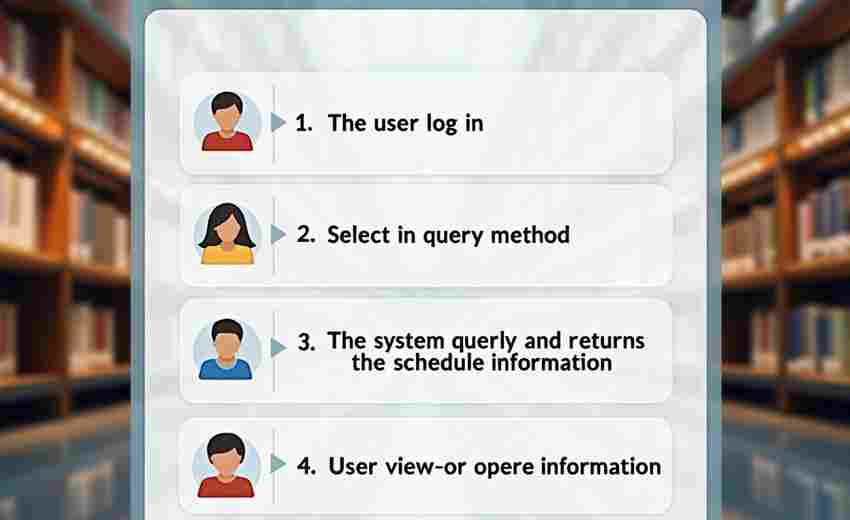

基础功能方面,主流工具普遍具备智能分词与词频统计两大模块。智能分词模块采用动态规划算法,结合百万级词典库,能准确识别"自然语言处理"这类专业复合词。词频统计模块则运用哈希表结构实现快速计数,支持导出CSV、Excel等格式的统计报表。部分工具还集成词云生成功能,通过视觉化呈现让高频词汇一目了然。

技术实现上,现代分词工具普遍采用混合算法。基于词典的逆向最大匹配算法保证基础分词的准确性,双数组字典树(DAT)结构实现词典的快速查询。针对未登录词问题,多数工具引入隐马尔可夫模型(HMM),通过维特比算法计算最可能的词语切分路径。统计结果显示,采用混合算法的工具在新闻类文本中的分词准确率可达97%以上。

实际应用中,教育领域的使用案例颇具代表性。某高校教授使用某款分词工具分析学生论文时发现,超过60%的作业存在"学术不端""数据造假"等敏感词异常重复。出版机构编辑借助词频统计功能,发现某畅销书前五章出现"元宇宙"达273次,及时调整了内容分布。新媒体运营者则通过词云生成器,快速定位爆款文章中的核心传播词汇。

市面上常见工具各具特色。Python平台的Jieba库以轻量化著称,支持用户自定义词典;Java开发的HanLP擅长处理专业术语;在线工具TextMind则提供便捷的网页端操作。测试数据显示,处理10万字文本时,本地工具的平均响应时间为3.2秒,云端工具受网络环境影响可能出现2-5秒延迟。

数据安全始终是工具选型的重要考量。离线版本虽然运行速度稍慢,但能有效避免文本内容外泄。某法律事务所曾披露,其使用的在线分词工具因未加密传输,导致客户合同内容被第三方截获。这个案例提醒使用者需根据文本敏感程度选择合适版本。

- 上一篇:中文分词与简单情感分析工具

- 下一篇:中文成语词典查询命令行工具

相关软件推荐

随机软件推荐

基于日志文件的错误类型统计工具

企业级应用系统运行时,日志文件如同程序运行的"心电图",但动辄数十GB的文本数据往往让运维人员望而生畏。某互...

停车场车位占用异常监控工具

现代城市停车资源紧张,车位管理效率直接影响用户体验与运营成本。车位占用异常现象——例如车辆超时停放、非...

图片格式转换器(支持WebP格式转换)

当Google在2010年推出WebP格式时,可能没想到这款为网页优化而生的图像格式,会在十年后成为设计师和自媒体创作者的...

鼠标轨迹绘画涂鸦板

在数字创作领域,工具的自由度往往决定灵感的落地效果。鼠标轨迹绘画涂鸦板作为一款轻量级创作工具,凭借其简...

用户自定义指标监控配置工具

企业数字化转型浪潮下,数据监控体系正面临根本性变革。传统监控工具预设的CPU、内存等基础指标,在电商大促流...

自动化网页表单填写工具(带数据模板)

表单填写是日常工作中绕不开的重复场景。无论是企业收集、电商平台批量上传商品,还是科研机构录入实验数据,...

设备资源使用监控API(CPU-内存)

在分布式架构与云计算普及的今天,服务器资源监控已成为技术团队的核心需求。无论是应对突发流量高峰,还是优...

服务历史操作日志追踪器

在分布式系统与微服务架构普及的今天,运维团队常面临操作追溯困难、故障定位效率低等痛点。服务历史操作日志...

天气预报数据定时推送桌面小部件

实时天气管家:桌面小工具如何重塑生活节奏 清晨推开窗户前,习惯性瞥一眼电脑右下角——实时温度、降水概率、...

日志时间戳重命名批处理工具

当服务器日志文件堆积如山时,"access_2023.log""error_log_1"这类随机命名的文件常让运维人员陷入混乱。某互联网公司的...

屏幕键盘快速呼出快捷键管理器

办公场景的键盘敲击声突然停滞——设计师小张盯着屏幕右下角闪烁的图标,手指悬停在F3键上方两厘米处。这个持续...

带分类标签的个人记账管理工具

打开手机应用商店,搜索“记账工具”会跳出上千个结果。多数产品停留在记录收支的初级阶段,用户需要手动输入...

RAR-ZIP压缩包密码爆破测试器

加密压缩包广泛存在于日常工作场景中。当遭遇密码遗失或接收加密文件无法打开时,部分技术爱好者会选择使用密...

节假日促销活动价格追踪器

促销季的电商平台总让人眼花缭乱。商品标着“历史低价”“限时五折”,但消费者很难判断优惠的真实性。一款名...

键盘鼠标操作录制工具(自动化重复操作)

办公室的玻璃幕墙外天色渐暗,王磊盯着屏幕上密密麻麻的表格叹了口气。作为某电商平台运营专员,每天要在七个...

Word文档批量关键字查找与替换工具

在日常办公场景中,处理大量Word文档时,重复性操作常成为效率瓶颈。例如,市场部需要统一修改上百份合同中的产...

自动文件备份与同步脚本

在信息爆炸的时代,数据如同沙漏中的细沙不断累积。普通用户手机里可能躺着5个不同云盘的客户端,设计师的电脑...

JSON数据热重载监控工具(文件变更自动刷新)

在软件开发过程中,JSON文件常被用于存储配置信息、模拟接口数据或管理多语言资源。频繁修改JSON内容时,开发者往...

PDF表单字段批量清除工具

日常工作中常遇到PDF表单需要重复利用的情况。手动逐个删除表单字段不仅效率低下,还容易产生遗漏。专业开发者...

文件加密-解密工具

在数据泄露频发的当下,个人隐私与商业机密的安全防护成为刚需。文件加密工具作为主动防御手段,通过算法将普...

古籍文本情感倾向分析工具

传统典籍研究领域长期面临着情感分析的空白区。以《史记》为例,司马迁在"李将军列传"中埋藏的情感线索,究竟是...

本地文件搜索工具(支持关键字过滤)

在数据爆炸的时代,笔记本电脑里堆积着上万份文档已成为常态。某互联网公司运维工程师张磊的经历颇具代表性:...

二维码解码与信息导出工具

二维码作为现代生活中不可或缺的信息载体,逐渐渗透到商业、教育、政务等各个领域。面对海量二维码处理需求,...

系统激活状态检测与提醒工具

在数字化办公场景中,操作系统的合法激活状态直接影响软件生态的稳定性。未激活的系统可能导致功能受限、安全...

简易数据库查询命令行工具

在数据驱动的开发场景中,数据库查询效率直接影响工作流质量。一款名为 QueryCli 的开源工具近期在开发者社区中流...

网络服务版本探测工具(banner抓取)

网络服务版本探测工具常被称作"数字指纹采集器"。这类工具通过抓取服务端的banner信息,帮助技术人员快速识别远程...

视频封面自动调色温工具

视频封面的视觉冲击力往往决定点击率。冷色调传递专业感,暖色调渲染氛围感,但手动调色温耗时耗力。近期一款...

家庭儿童疫苗接种提醒系统

在儿童成长过程中,疫苗接种是预防疾病的核心环节。由于疫苗种类繁多、接种周期跨度大,家长常因工作繁忙或信...

签证-证件续期管理工具

深夜的航班提示音与签证截止日期的重合,让频繁跨国出差的陈先生陷入慌乱。去年因疏忽导致工作签延期失败的经...

天气查询终端工具(城市代码输入)

盛夏的雷雨总爱突然造访。当快递员王师傅在配送站扫描货物条形码时,目光突然停留在同事电脑前跳动的天气数据...

多线程网站可达性批量测试工具

互联网服务稳定性已成为企业运维的核心指标之一,面对动辄上千的域名列表,传统检测工具常因效率不足导致监控...

进程监控与管理系统资源占用工具

在Windows任务管理器意外崩溃的某个深夜,运维工程师老张盯着屏幕上的蓝色死亡界面苦笑。正是这种突如其来的系统...

Excel单元格公式批量检查与纠错工具

在日常办公场景中,Excel公式的复杂性与嵌套逻辑常导致错误频发。尤其当表格数据量激增或多人协作时,人工逐行排...

简易物联网MQTT协议调试工具

物联网设备的快速普及让MQTT协议逐渐成为设备通信的主流选择。这种轻量级的发布-订阅模式协议,虽然简化了数据传...

颜色温度检测与白平衡调节工具

在影像制作领域,色彩的精准控制直接影响作品质量。当光源色温与设备记录参数不匹配时,画面极易产生偏蓝或偏...

视频下载器(支持YouTube或其他平台)

在信息爆炸的互联网时代,优质视频内容常因网络不稳定或离线需求难以随时观看。一款适配YouTube等主流平台的视频...

数据库索引使用率分析工具

在数据库运维领域,索引优化向来是DBA们头疼的难题。传统的人工排查方式如同大海捞针,不仅耗时耗力,还常常出...

Excel单元格合并与拆分处理器

在日常办公场景中,Excel单元格的合并与拆分是高频操作,但手动处理效率低且容易出错。针对这一痛点,第三方开发...

办公文档自动备份同步工具(本地到云盘)

在数字化办公场景中,文件丢失、设备故障或版本混乱等问题常成为职场人的痛点。一款高效的办公文档自动备份同...

单词本(生词本+发音功能)

纸质笔记本边缘卷着毛边,荧光笔的墨迹洇透纸张——传统单词记忆方式逐渐被科技重新定义。智能单词本正以数据...